Видеокарты: чем руководствоваться при выборе

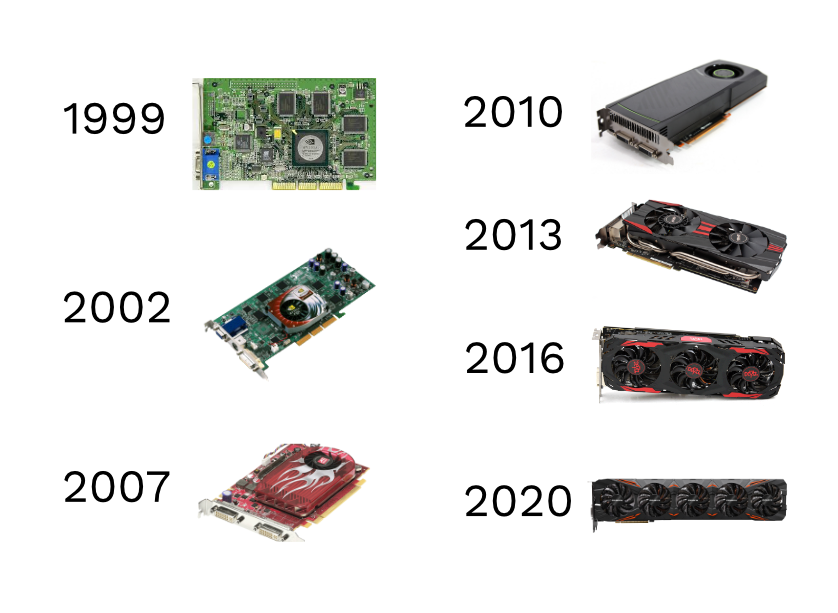

В ранних моделях ПК за преобразование информации в изображение отвечал центральный процессор. Он передавал на дисплей данные, которые хранились в кадровом буфере. Со временем были созданы графические ускорители, взявшие на себя эти задачи.

После центрального процессора (CPU, ЦП), графический (GPU, видеокарта) оказывает наибольшее влияние на производительность компьютера. Его задача — принимать данные от ЦП и преобразовывать их в изображение, выводимое на дисплей.

Современные видеокарты способны обработать внушительный объем графической информации, параллельно выполняя другие задачи. Это делает их невероятно быстрыми при отображении текста, двухмерных объектов и обработке сложной 3D-графики новейших игр. Чем мощнее GPU видеокарты, тем больше данных он может рассчитать и отобразить за единицу времени.

Какую видеокарту купить

На рынке представлен широкий выбор графических процессоров от различных производителей.

Предназначение видеокарты

Чтобы понять, какую видеокарту выбрать, нужно определиться, для чего она нужна. В зависимости от ряда параметров видеокарты делятся на следующие типы.

Офисные

Видеокарты из этой категории могут быть встроенными и дискретными. Основное предназначение таких устройств — выводить на экран визуализацию. Они отлично подходят для просмотра любых изображений и видео в формате HD. Эти бюджетные видеокарты не справятся с геймерскими новинками, но на минимальных настройках потянут некоторые игры прошлых лет. Например, Generic ATI Rage XL 8MB на базе чипсета ATI Rage XL с 8 МБ памяти и двумя видеоускорителями (2D и 3D) стоит на Amazon $23.

https://www.amazon.com

Мультимедийные

Видеокарты среднего ценового сегмента. Им под силу Full HD-видео и современные игры на средних и высоких настройках. Графические платы этого типа предоставляют дополнительные возможности. Например, ядро CUDA в GPU NVidia делает ее пригодной для работы с профессиональными графическими программами. Бренд PNY выпускает видеокарты на базе NVIDIA Quadro с 128-битным интерфейсом памяти и буфером в 1ГБ DDT3 за $60.

https://www.amazon.com

Геймерские

Игровые или «оверклокинг» видеокарты, то есть разгоняемые. Чаще всего это карты 2 в 1: мощные и с большим количеством дополнительных технологий. Такие устройства тянут самые требовательные игры. Производительность можно повысить еще больше, разогнав процессор и память. При производстве используются материалы и компоненты, рассчитанные на максимальные нагрузки. Это самый дорогостоящий сегмент видеокарт.

https://www.amazon.com

Видеокарты для работы с графикой

Подкласс видеокарт, ориентированный на сложные вычисления. Это специализированный тип, который чаще всего не подходит для гейминга, но стоит в разы дороже топовых игровых видеокарт. В этой категории лидируют карты NVIDIA с собственными графическими процессорами. На «Амазон» из относительно недорогих видеокарт в этом сегменте — MSI RADEON RX 5700 за $960, а флагманская модель PNY QUADRO RTX 6000 стоит $3750.

Интерфейс подключения и технические характеристики

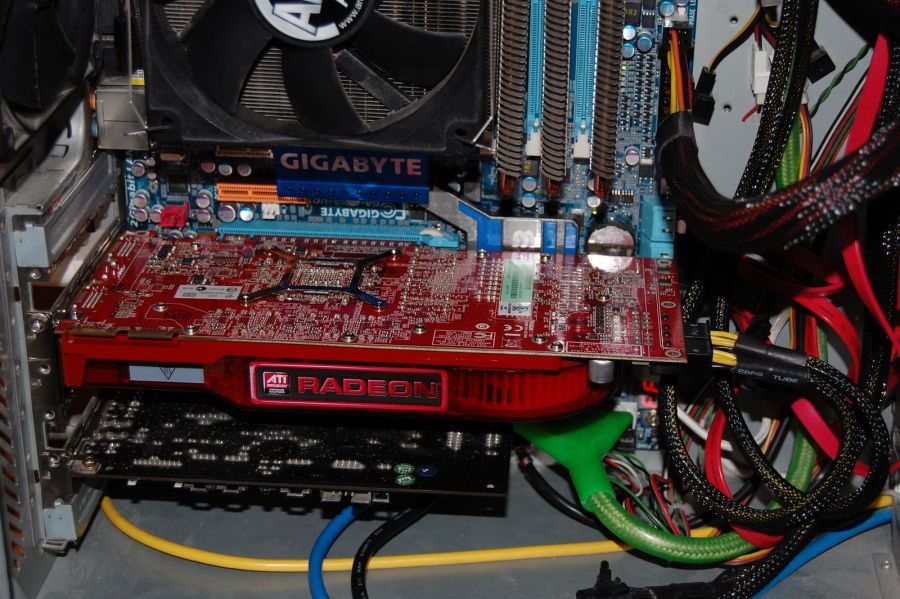

Подсоединение видеокарт осуществляется с помощью шины стандарта PCI-Express, сменившей более ранний интерфейс AGP. Существует в двух вариантах: PCIe и PCI-E. Современные графические платы оснащаются несколькими портами для подключения.

Производительность видеокарты измеряется:

- частотой чипа;

- типом памяти;

- объемом памяти;

Чем шире шина, тем больший объем информации одновременно поступает на графический чип. Но слишком широкая шина — не всегда хорошо. Процессор может не справиться с объемом поступающей информации. На более новом чипе частота может быть небольшой, но это даст высокую производительность. Видеокарты давно превзошли процессоры по количеству ядер, которые теперь исчисляются сотнями. Поэтому новизна чипа тоже имеет значение.

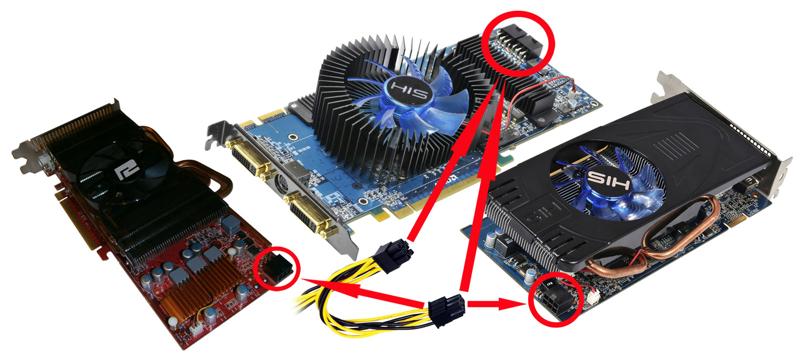

Энергопотребление

Чем мощнее видеокарта, тем больше потребление электроэнергии. Это один из важных моментов, на который стоит обратить особое внимание при покупке. Информацию об энергозатратности видеокарты ищите в технических характеристиках. Она показывает, сколько ватт в час потребляется при максимальной нагрузке.

Значение энергопотребления видеокарты важно знать, чтобы подобрать оптимальную модель в соответствии с мощностью системы. Видеокарты потребляют от нескольких десятков ватт в час, как MSI GAMING GeForce GT 710 (19 Вт), до нескольких сотен, как NVIDIA TITAN XP (250 Вт).

https://www.amazon.com

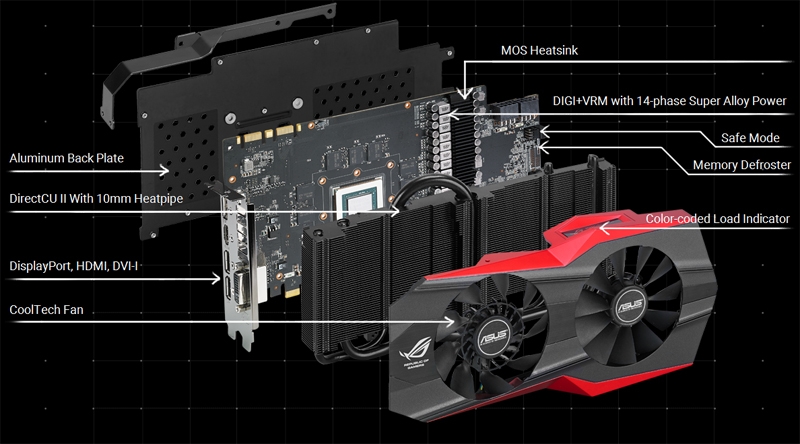

Система охлаждения

Сегодня для украинских покупателей открыты интернет-магазины мира, где можно найти видеокарты с кулерами, разнящиеся параметрами и ценой. Пользователи могут снизить уровень шума и улучшить отвод тепла с помощью установки дополнительных систем водяного охлаждения или пассивного кулера.

Пользователи могут снизить уровень шума и улучшить отвод тепла с помощью установки дополнительных систем водяного охлаждения или пассивного кулера.

Современные универсальные кулеры успешно справляются с контролем температуры «горячих» игровых видеокарт, при этом они тихие и недорогие. ARCTIC Accelero Xtreme IV тише штатного кулера и вполне способен конкурировать с референсными системами охлаждения.

https://www.amazon.com

Выбираем карту, исходя из диагонали монитора

Разрешение экрана — это параметр, указывающий количество пикселей, задействованных в отображении картинки на дисплее.

Диагональ монитора — параметр, который влияет на разрешение. На большом дисплее будет большее количество пикселей, которые необходимо обработать видеокарте. А значит, и нагрузка на нее будет выше.

Ресурсов бюджетной видеокарты полностью хватит, чтобы вывести качественную картинку на монитор диагональю 17–19 дюймов.

Мультимедийные хорошие видеокарты среднего ценового сегмента имеет смысл приобретать для мониторов диагональю от 21–22 дюймов и выше.

Владельцам мониторов с разрешением 2К, 4К, а также тем, кто использует несколько экранов или играет на максимальных настройках графики, нужны видеокарты топового класса. Высокоуровневые модели смогут обеспечить быстродействие и скоростной вывод 3D-объектов.

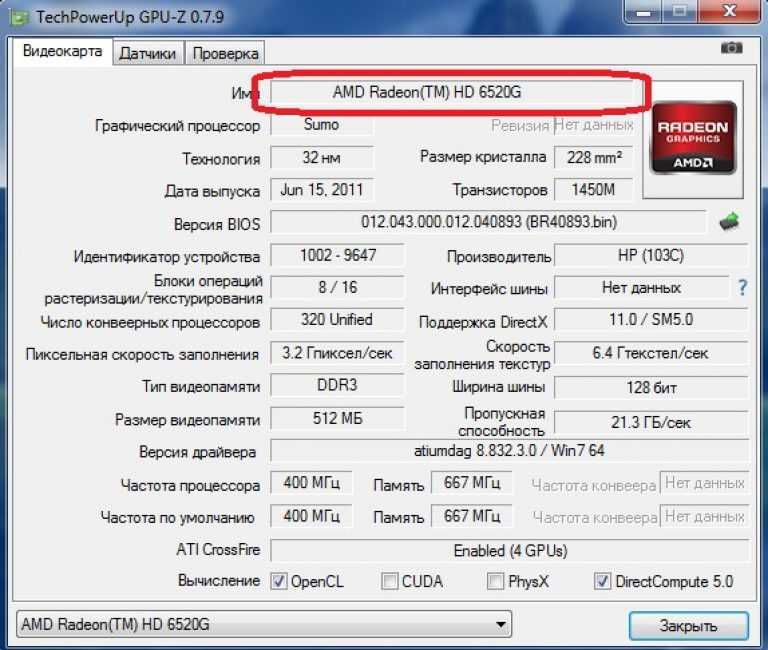

Больше видеопамяти — не всегда лучше

Видеоадаптеру не нужна собственная память, если она есть у компьютера.

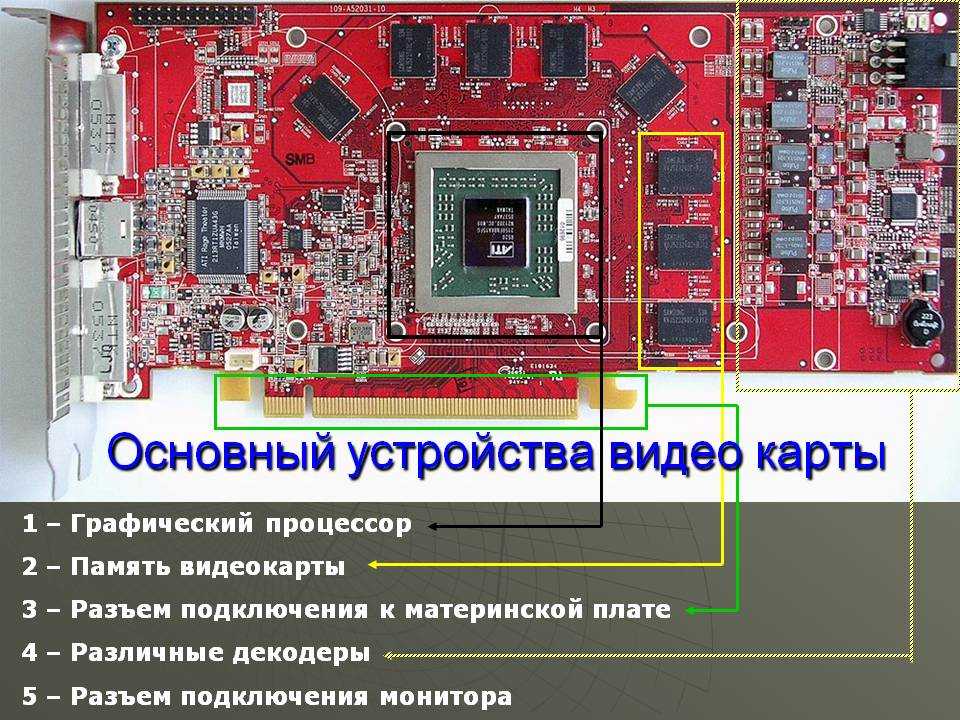

Современная видеокарта — это самодостаточная система. В ней есть микропроцессор (GPU), выполняющий десятки тысяч операций, для которых нужен собственный запас памяти. Графический адаптер берет на себя часть работы оперативной памяти компьютера относительно передачи изображения на монитор.

Память видеокарты — это ее собственное маленькое хранилище. Графический процессор видеокарты берет данные для обработки прямо из нее.

При выборе внутренней оперативной памяти следует учитывать полный спектр значимых характеристик: тип памяти видеокарты, параметры шины, поколение микропроцессора.

Память видеокарты ничем не отличается от памяти компьютера. Она встроена в карту и в соответствии со спецификой использует быстрые виды оперативки: GDDR5, GDDR5X, GDDR6, HBM2.

Какой объем памяти нужен видеокарте

Этот параметр зависит от сложности выполняемых задач. Самые требовательные компьютерные процессы — игры и графика. Для них нужен большой объем памяти.

https://www. amazon.com

amazon.com

Устройства на 4–6 ГБ памяти уверенно справятся практически с любой современной игрой, но не на максимальных параметрах. Благодаря мощному ядру даже бюджетная видеокарта на базе чипсета GeForce GTX 1660, как в линейке EVGA, подходит для работы с играми и графикой.

Карты с видеопамятью больше 6 ГБ потянут все. Они подойдут для самых требовательных игр, комплексной работы и 3D-моделирования. В коллекции NVIDIA Quadro представлены модели с разным типом и объемом памяти, в линейке Quadro M4000 есть варианты от $400 до $2660, работающие с ультракачественным видеоконтентом.

Производители используют специальную технологию, которая позволяет подключать дополнительную память. Таким образом, можно расширить объем графического адаптера за счет оперативной памяти компьютера. У ATI эта технология называется HyperMemory, а у NVIDIA — TurboCache.

AMD Radeon или NVIDIA GeForce

Постоянные конкуренты современного рынка видеокарт — торговая марка Radeon с AMD и бренд GeForce с NVIDIA.

У каждого производителя есть свои фавориты, открытия, удачные и неудачные модели, сопоставимые по ценам и параметрам. Выпуск новинок у этих брендов часто происходит в одном временном промежутке. Выпускаемая марками продукция отличается высоким уровнем качества, поэтому однозначного лидера среди них нет.

Советы по выбору и обзор цен на видеокарты

Выбирая видеокарту, нужно определиться с типом наиболее часто используемых на компьютере приложений. Если вы не занимаетесь графическим дизайном профессионально и не планируете играть в требовательные к системе игры, вполне подойдет недорогая офисная видеокарта.

Топ бюджетных видеокарт

- Aiposen ATI Rage XL — $22

- MSI Geforce 210 — $39

- ZOTAC GeForce GT 710 — $42

Тем, кто нуждается в видеокарте для игр, но платить слишком много не готов, стоит отдать предпочтение мультимедийным моделям. Главное — учесть производительность чипа.

Максимизировать возможности своей компьютерной системы и не переплатить позволит MSI Gaming GeForce GT 710.

https://www.amazon.com

Высокой частотой при разрешении 1080р может похвастаться GTX 1660 Super — отличный вариант модернизировать компьютер за приемлемые деньги.

Продвинутым геймерам стоит обратить внимание на модель GTX 1080 Ti. Производитель предлагает инновационные разработки и функцию поддержки лучевой трассировки.

Лучшая бюджетная видеокарта, гарантирующая длительный срок работы и высокую производительность — мощная и проверенная Radeon RX 570.

Важно помнить, что самостоятельно хорошие результаты видеоадаптер не покажет. Это возможно исключительно в симбиозе с другими компонентами системы. Поэтому важно подбирать видеокарту, соответствующую объему памяти, мощности процессора и другим компонентам вашего ПК.

Даже недорогая видеокарта вполне способна выдать неплохие результаты, если настроить игровую графику.

GeForce RTX 3070 ($950) подойдет для игр в разрешении 1080р и 1440р. В некоторых случаях, если скрутить настройки до минимума, вытянет даже нагрузку в 4К, благодаря чему можно добиться плавной игровой кадровой частоты. Это карта «холодного» типа, высокопроизводительная, но тихая, с хорошим потенциалом для разгона и низким энергопотреблением.

Возможности современных графических адаптеров расширяются в геометрической прогрессии. Модель RTX 3080 за $1500 — лучшее тому доказательство. Она признана экспертами лучшей в соотношении стоимости и возможностей в премиальном сегменте. Видеоадаптер демонстрирует следующую ступень производительности. Модель создана для комфортной игры с плавной графикой, без рывков и задержек. Для оптимальной работы этой энергоемкой видеокарты придется подобрать блок питания подходящей мощности.

https://www.amazon.com

В комплекте с графической картой ASUS TUF Gaming GeForce RTX 3080 OC идет мощный кулер. Охлаждение обеспечивают три вентилятора. Продуктивность видеоадаптера обусловлена 10 ГБ памяти GDDR6X и высокочастотной работой со скоростью 14 ГГц/с. Именно это позволяет разогнать до максимума потенциал игрового дисплея в 1440р. Качественное охлаждение выполняют вентиляторы со сдвоенными шарикоподшипниками. Инженеры ASUS тонко настроили систему охлаждения видеокарты: вентиляторы автоматически прекращают работу, опустив температуру ниже 55°С.

Охлаждение обеспечивают три вентилятора. Продуктивность видеоадаптера обусловлена 10 ГБ памяти GDDR6X и высокочастотной работой со скоростью 14 ГГц/с. Именно это позволяет разогнать до максимума потенциал игрового дисплея в 1440р. Качественное охлаждение выполняют вентиляторы со сдвоенными шарикоподшипниками. Инженеры ASUS тонко настроили систему охлаждения видеокарты: вентиляторы автоматически прекращают работу, опустив температуру ниже 55°С.

При выборе видеокарты нужно учитывать сопоставимость и совместимость с процессором. Если вы фанат конкретной игры — сначала изучите тестовые сравнения видеокарт по ней. В некоторых случаях имеет смысл купить модель, выпущенную в прошлом году и ранее. Это реальная возможность приобрести мощный видеоадаптер, не выкладывая на него целое состояние.

Отличный способ купить хорошую видеокарту — дождаться большой распродажи. В зарубежных интернет-магазинах отмечают все крупные праздники. После Черной Пятницы и Киберпонедельника стартует сезон скидок, когда приобрести видеокарту можно по особенно приятной цене. Отслеживайте лучшие акционные предложения онлайн-магазинов, изучайте отзывы и заказывайте товары с доставкой от NP Shopping.

Отслеживайте лучшие акционные предложения онлайн-магазинов, изучайте отзывы и заказывайте товары с доставкой от NP Shopping.

P.S: обратите внимание, что указанные в статье цены актуальны по состоянию на конец ноября 2020 года.

Установка разрешения и частоты обновления монитора

Windows 7 Enterprise Windows 7 Home Basic Windows 7 Home Premium Windows 7 Professional Windows 7 Ultimate Еще…Меньше

Это — статья с пошаговым руководством.

Проблема

Если вы используете монитор DVI или HDMI, существует вероятность, что вы не сможете выбрать оптимальное разрешение для вашего оборудования из-за проблем с контроллером, поэтому вам понадобится установить разрешение самостоятельно.

Например, если ваш экран совместим с разрешением HD (1280 x 720 пикселей) или FullHD (1920 x 1080 пикселей), которые не входят в список допущенных разрешений, выберите решение, соответствующее вашей видеокарте.

Примечание: Использование индивидуального разрешения или частоты обновления, которая приводит к неправильному отображению на вашем мониторе, может повлиять на стабильность системы и срок службы набора микросхем, а также повредить экран или другое аппаратное обеспечение.

Решение

Из Панели управления Windows 7

Видеокарта Intel

Видеокарта NVIDIA

Видеокарта ATI

Из Панели управления Windows 7

вне зависимости от модели используемой видеокарты рекомендуется сначала испытать параметры, предложенные на Панели управления Windows. Вероятно, вы не найдете то же количество параметров конфигурации, что в оборудовании вашей видеокарты, но можете найти более легкое, быстрое и надежное решение вашей проблемы.

Щелкните правой кнопкой мыши по рабочему столу и выберите Разрешение экрана.

Выберите в развернутом меню Разрешение, появится список рекомендуемых разрешений для вашего экрана.

Если не найдено желаемое разрешение среди рекомендуемых, щелкните Дополнительные параметры.

На вкладке Адаптер, щелкните Список всех режимов.

Появится список всех режимов, совместимых с видеокартой, которую вы используете. Выберите предпочтительный режим, совместимый с вашим экраном, и нажмите OK.

В начало

Видеокарта Intel

-

Щелкните правой кнопкой мыши по рабочему столу и выберите Графические характеристики.

-

В меню Дисплей щелкните Пользовательские разрешения.

org/ListItem»>

-

Укажите требуемое разрешение и частоту обновления.

-

Если вы хотите сохранить индивидуальное разрешение, щелкните Добавить.

-

По завершении выберите OK.

Внимательно просмотрите справку и щелкните Да.

В начало

Видеокарта NVIDIA

Щелкните правой кнопкой мыши по рабочему столу и выберите Панель управления NVIDIA.

Нажмите Изменение разрешения.

Теперь щелкните Настройка…

Выберите Создать пользовательское разрешение.

Впишите требуемые величины. Для получения других параметров нажмите Синхронизация, затем в развернутом меню Авто и далее выберите Вручную, чтобы иметь возможность редактировать величины.

Для получения других параметров нажмите Синхронизация, затем в развернутом меню Авто и далее выберите Вручную, чтобы иметь возможность редактировать величины.

В завершение нажмите Тест.

Ваша конфигурация пользователя создана; нажмите OK, чтобы она была введена в действие.

Нажмите Да для сохранения изменений.

Ваша новая конфигурация пользователя появится на первоначальном экране Панели управления NVIDIA.

В начало

Видеокарта ATI

Видеокарты ATI не оснащены параметром создания пользовательских разрешений, но существует возможность включить большее количество имеющихся разрешений и частот обновления. Для этого выполните следующие шаги:

-

Щелкните правой кнопкой мыши по рабочему столу и выберите Catalyst Control Center.

-

Нажмите Мои VGA-экраны или Мои плоские цифровые панели в соответствии с используемым портом.

-

В развернутом меню выберите Свойства.

-

Снимите галочку с Использовать EDID (расширенные данные идентификации дисплея) или настройки драйвера по умолчанию.

-

Выберите в развернутом меню Максимальное разрешение, появится полный список имеющихся разрешений.

-

Нажмите в развернутом меню Максимальная частота обновления, появится полный список имеющихся частот.

-

Выберите совместимые с вашим экраном Разрешение и Частоту обновления, которые хотите применять, и нажмите Применить.

В начало

Нас интересует ваше мнение! Мы ждем ваших отзывов по данным статьям; их можно ввести в поле для комментариев в нижней части страницы. Ваши отзывы помогают нам повышать качество контента. Заранее спасибо!

MSI Россия

{{blogList.tagContent}}

{{blogList.blogTitle}}

By {{blogList.blogAuthor}} | {{blogList.date}}

Вы любите поиграть в свободное время? Нет проблем! Достаточно хорошо вложиться в игровое оборудование и получить приемлемое значение FPS, радующее глаз. Существует очень хороший шанс, что ваша видеокарта будет легко справляться со всеми современными играми без особых проблем. Однако не секрет, что современные игры до предела напичканы новыми визуальными эффектами и текстурами высокого разрешения для работы на разрешениях до 4К или при выводе изображения на несколько мониторов. Возникает вопрос, каким образом можно получить хотя бы незначительный прирост FPS от вашей видеокарты MSI, чтобы больше улучшить изображение?

Существует очень хороший шанс, что ваша видеокарта будет легко справляться со всеми современными играми без особых проблем. Однако не секрет, что современные игры до предела напичканы новыми визуальными эффектами и текстурами высокого разрешения для работы на разрешениях до 4К или при выводе изображения на несколько мониторов. Возникает вопрос, каким образом можно получить хотя бы незначительный прирост FPS от вашей видеокарты MSI, чтобы больше улучшить изображение?

Самый простой и быстрый способ разгона видеокарты MSI серии GAMING — это приложение MSI GAMING App, в котором имеется предустановленный режим OC Mode, позволяющий увеличить производительность видеокарты. Используя этот способ, вы можете увеличить производительность в один клик мыши без риска повредить ваше оборудование. Если у вас еще нет нашей видеокарты серии GAMING, и вы, в тоже время, хотите иметь высокопроизводительное решение для вывода графики, вам придется заняться оверклокингом и потратить на это немало времени. |

Приложение MSI Gaming App — это решение, позволяющее разогнать видеокарту MSI GAMING в один клик. |

Возможно, вы уже слышали, что такое разгон и даже успели удивиться результатам мировых рекордов в оверклокинге, установленных профессионалами с использованием систем охлаждения на жидком азоте. Это правда, что результаты оверклокинга могут быть существенными, однако необходимо помнить, что любой разгон вы всегда осуществляете на свой страх и риск. Как результат, увеличение частот и напряжений приводит к дополнительному разогреву видеокарты. Для того чтобы видеокарта оставалась холодной и в то же время демонстрировала высокую производительность, тепло, выделяемое при ее работе, необходимо эффективно отводить и рассеивать. Это осуществляется при помощи системы охлаждения видеокарты. Заметьте, что не все видеокарты имеют систему охлаждения, способную эффективно работать при разгоне. Поэтому убедитесь в том, что вы понимаете то, что вы делаете, до того как начнете разгонять.

Поэтому убедитесь в том, что вы понимаете то, что вы делаете, до того как начнете разгонять.

| Оверклокинг 101 Перед тем как вы броситесь во все тяжкие, вот несколько простых советов, чтобы увеличить шансы на положительный результат. Как вы уже поняли, очень важно держать температуру максимально низкой при попытке достичь большей производительности. Это может показаться очевидным, но тем не менее убедитесь, что ваш компьютер не находиться поблизости с другими источниками тепла, например батареей центрального отопления. Хорошая вентиляция корпуса ПК помогает снизить температуру его компонентов, т.к. компьютеру также необходимо избавляться от тепла, вырабатываемого его компонентами. |

Главным образом, это определяется эффективностью системы охлаждения видеокарты. Охлаждается ли видеокарта воздухом, одним или несколькими вентиляторами, либо система охлаждения является жидкостной, способной продемонстрировать колоссальную разницу по сравнению с воздушной системой охлаждения. Для того чтобы определить способность видеокарты безопасно разгоняться вам потребуется использовать тестовое программное обеспечение, а также MSI Afterburner, чтобы получить детальную информацию о системе.

Также отличным бесплатным инструментом для тестирования является Unigine Valley

Для того чтобы определить способность видеокарты безопасно разгоняться вам потребуется использовать тестовое программное обеспечение, а также MSI Afterburner, чтобы получить детальную информацию о системе.

Также отличным бесплатным инструментом для тестирования является Unigine Valley

| MSI Afterburner — программное обеспечение для оверклокинга | Unigine Valley — бесплатное ПО для тестирования |

Перед тем как вы запустите тест, установите скорость вращения вентилятора в программе Afterburner на 100% . Это обеспечит максимальное охлаждение. Это в свою очередь увеличит уровень шума, идущего от вентиляторов. Но такова цена дополнительного прироста мощности видеокарты. Тест Unigine Valley как следует нагрузит вашу видеокарту, тем самым показав, насколько поднимется ее температура и насколько громко будут шуметь вентиляторы. Дайте программе поработать порядка 15 мин, чтобы прогреть графический процессор до максимальной установившейся температуры.

Установите скорости вращения вентиляторов на 100% во время тестирования и внимательно следите за температурой GPU.

Максимальная безопасная рабочая температура, при которой видеокарта может нормально функционировать варьируется в зависимости от модели и производителя, но, тем не менее, опытные оверклокеры едины во мнении, что 90 градусов Цельсия это максимальная безопасная температура для большинства видеокарт. Разница между максимальной температурой вашей графической карты и температурой в 90 градусов Цельсия составляет как раз тот запас, который можно использовать для оверклокинга. Проще говоря, разница в температурах показывает, какой запас имеет видеокарта для разгона. Если вы являетесь счастливым пользователем одной из видеокарт MSI с системой охлаждения Twin Frozr, значит ваша видеокарта пригодна для разгона.

Дайте программе поработать порядка 15 мин, чтобы прогреть графический процессор до максимальной установившейся температуры.

Установите скорости вращения вентиляторов на 100% во время тестирования и внимательно следите за температурой GPU.

Максимальная безопасная рабочая температура, при которой видеокарта может нормально функционировать варьируется в зависимости от модели и производителя, но, тем не менее, опытные оверклокеры едины во мнении, что 90 градусов Цельсия это максимальная безопасная температура для большинства видеокарт. Разница между максимальной температурой вашей графической карты и температурой в 90 градусов Цельсия составляет как раз тот запас, который можно использовать для оверклокинга. Проще говоря, разница в температурах показывает, какой запас имеет видеокарта для разгона. Если вы являетесь счастливым пользователем одной из видеокарт MSI с системой охлаждения Twin Frozr, значит ваша видеокарта пригодна для разгона.

Если вы уверены в том, что запас по температуре достаточно большой, вы можете начинать разгонять вашу видеокарту. В первую очередь запустите MSI Afterburner и освойтесь с интерфейсом программы и различными опциями. С левой стороны окна программы присутствуют несколько иконок. Здесь вы можете поменять частоты, напряжения и скорости вращения вентиляторов. В правой части окна вы можете найти Hardware Monitor (аппаратный мониторинг), где отображается информация в реальном времени о таких параметрах как температура, нагрузка, скорости вентиляторов и напряжения. Используя прокрутку, вы можете с легкостью просматривать значения параметров, либо вывести их в отдельное окно для удобства работы. MSI Afterburner позволяет настраивать, какие из параметров необходимо отображать в окне, и в каком порядке. Здесь вы можете найти основные функции MSI Afterburner

Процесс разгона в большей степени напоминает испытание, где вы пытаетесь найти оптимальные режимы работы оборудования для максимальной производительности, и в тоже время, сохраняя температуру в безопасном интервале значений.Чтобы определить максимальную производительность вашей видеокарты вы должны сначала превзойти это значение. И что бы не случилось на пути, не расстраивайтесь! Дорога к успешному оверклокингу устлана черными экранами, «синими экранами смерти» BSoD и другими ошибками.

Начните с Settings (настройки) и поставьте галочки в таких параметрах как, “Unlock voltage control” и “Unlock voltage monitoring”. Это позволит увеличивать напряжение на ядре видеокарты. Затем увеличьте значение Core Clock (частота ядра) на 10 и кликните по кнопке Apply (применить) в нижней правой части окна. Теперь GPU вашей видеокарты будет работать с новой частотой по умолчанию. Это можно наблюдать в Hardware Monitor.

| Активация функции управления напряжением | Немного увеличьте Core Clockspeed (частота ядра) |

Теперь пришло время проверить останется ли ваша видеокарта холодной или нет. Тест Unigine Valley поможет вам в этом. Не паникуйте, если экран внезапно станет черным или отобразиться ошибка. Такое происходит, если видеокарта работает нестабильно или имеет место ее перегрев под большой нагрузкой в тестах. Расслабьтесь. Благодаря встроенной защите ваша видеокарта вряд ли пострадает. Однако ее параметры будут сброшены до заводских значений по умолчанию. Если такое случиться, мы рекомендуем перезагрузить ваш компьютер. Это поможет видео драйверу заработать в нормальном режиме до того как вы продолжите.

Ошибки при овеклокинге могут случаться по разным причинам. Основная из них это либо выбранная частота не может быть достигнута на данном напряжении, либо работа GPU становиться нестабильной от избыточного разгона. Первая причина легко устраняется небольшим поднятием напряжения Core Voltage. Это в свою очередь приведет к большему тепловыделению на GPU. Таким образом, поднимайте напряжение только в том случае, если вы уверены, что имеется запас по максимальной безопасной температуре.

Тест Unigine Valley поможет вам в этом. Не паникуйте, если экран внезапно станет черным или отобразиться ошибка. Такое происходит, если видеокарта работает нестабильно или имеет место ее перегрев под большой нагрузкой в тестах. Расслабьтесь. Благодаря встроенной защите ваша видеокарта вряд ли пострадает. Однако ее параметры будут сброшены до заводских значений по умолчанию. Если такое случиться, мы рекомендуем перезагрузить ваш компьютер. Это поможет видео драйверу заработать в нормальном режиме до того как вы продолжите.

Ошибки при овеклокинге могут случаться по разным причинам. Основная из них это либо выбранная частота не может быть достигнута на данном напряжении, либо работа GPU становиться нестабильной от избыточного разгона. Первая причина легко устраняется небольшим поднятием напряжения Core Voltage. Это в свою очередь приведет к большему тепловыделению на GPU. Таким образом, поднимайте напряжение только в том случае, если вы уверены, что имеется запас по максимальной безопасной температуре. Вторая причина является, как правило, следствием перегрева либо неспособностью видеокарты работать на более высоких частотах. Запомните, что каждая видеокарта имеет индивидуальные параметры, кроме того, удача здесь играет далеко не последнюю роль.

Увеличение напряжения на ядре (Core Voltage) и ограничение мощности (Power Limit)

Как только вы начнете разгонять видеокарту, будьте готовы к появлению ошибок и нестабильному поведению до тех пор, пока не найдете оптимальные параметры. Afterburner позволяет сохранить настройки в соответствующий профиль в любой момент. Это позволит вам легко переключаться между заводскими настройками и новыми высокопроизводительными настройками для игр, тогда, когда вам это потребуется.

При помощи программы MSI Afterburner вы можете выжать из вашей видеокарты все, на что она действительно способна. Смотрите видео по основам разгона:

Вторая причина является, как правило, следствием перегрева либо неспособностью видеокарты работать на более высоких частотах. Запомните, что каждая видеокарта имеет индивидуальные параметры, кроме того, удача здесь играет далеко не последнюю роль.

Увеличение напряжения на ядре (Core Voltage) и ограничение мощности (Power Limit)

Как только вы начнете разгонять видеокарту, будьте готовы к появлению ошибок и нестабильному поведению до тех пор, пока не найдете оптимальные параметры. Afterburner позволяет сохранить настройки в соответствующий профиль в любой момент. Это позволит вам легко переключаться между заводскими настройками и новыми высокопроизводительными настройками для игр, тогда, когда вам это потребуется.

При помощи программы MSI Afterburner вы можете выжать из вашей видеокарты все, на что она действительно способна. Смотрите видео по основам разгона:

Удачной охоты за производительностью!

Дисклеймер: Обратите внимание, что MSI не несет ответственности за прямые или косвенные убытки в результате использования MSI Afterburner, MSI Kombustor или любого другого стороннего программного обеспечения.

: убедитесь в мощности

Аппаратный вердикт Тома

Asus берет GeForce RTX 3090 Ti и доводит ее до еще более высокого уровня производительности с помощью заводского разгона. На данный момент это самая быстрая видеокарта, которую мы тестировали, но мы приближаемся к окну запуска графических процессоров следующего поколения. Это, а также высокая цена и энергопотребление делают эту карту весьма сомнительным выбором.

Плюсы

- +

+ Самый быстрый GPU на данный момент

- +

+ Достойный заводской разгон

- +

+ 21 Гбит/с GDDR6X с улучшенным охлаждением видеопамяти

- +

+ Высокая скорость для рабочих нагрузок по созданию контента

Лучшие предложения Asus GeForce RTX 3090 Ti на сегодняшний день GeForce RTX 3090 Ti была выпущена две недели назад, и мы наконец-то закончили тестирование и оценку. Теперь он правит как король графических карт, превзойдя свои 3090 до 10 % — при условии, что вы тестируете в разрешении 4K. Но за эту производительность приходится платить, и не только в долларах. RTX 3090 Ti также занимает первое место как самый энергоемкий графический процессор, который мы когда-либо тестировали (не считая решений с двумя графическими процессорами, таких как Titan Z 2014 года), раздвигая границы того, сколько сока может потреблять видеокарта.

Но за эту производительность приходится платить, и не только в долларах. RTX 3090 Ti также занимает первое место как самый энергоемкий графический процессор, который мы когда-либо тестировали (не считая решений с двумя графическими процессорами, таких как Titan Z 2014 года), раздвигая границы того, сколько сока может потреблять видеокарта.

Если все, что вам нужно, это самый быстрый графический процессор, к черту эффективность, теперь это лучшая видеокарта и лучшее решение в нашей Тесты графического процессора Иерархия. Но так же, как энтузиасты спортивных автомобилей могут смотреть на Ferrari или Lamborghini, не собираясь их покупать, большинство геймеров на ПК захотят придерживаться RTX 3080 или RTX 3080 Ti и откажутся от этого.

Как и в случае с недавним RTX 3080 12 ГБ , Nvidia решила не выбирать рецензентов напрямую для RTX 3090 Ti. Он предложил обратиться к партнерам AIC (карты расширения), и Asus предоставила нам свою RTX 3090 Ti TUF Gaming OC. Возможно, отчасти причина, по которой Nvidia не взяла образец, заключается в том, что модели партнеров по плате, как правило, работают лучше благодаря заводскому разгону и могут даже работать тише из-за более крупных кулеров. Вот посмотрите на характеристики различных карт, которые, по крайней мере, правдоподобно конкурируют с 309.0 Ти.

Возможно, отчасти причина, по которой Nvidia не взяла образец, заключается в том, что модели партнеров по плате, как правило, работают лучше благодаря заводскому разгону и могут даже работать тише из-за более крупных кулеров. Вот посмотрите на характеристики различных карт, которые, по крайней мере, правдоподобно конкурируют с 309.0 Ти.

| Graphics Card | RTX 3090 Ti Asus | RTX 3090 Ti | RTX 3090 | RTX 3080 Ti | RTX 3080 | RX 6900 XT | ||

|---|---|---|---|---|---|---|---|---|

| Architecture | GA102 | GA102 | GA102 | GA102 | GA102 | Navi 21 | ||

| Технологический процесс | Samsung 8N | Samsung 8N 92) | 628.4 | 628.4 | 628.4 | 628.4 | 628.4 | 519 |

| SMs / CUs | 84 | 84 | 82 | 80 | 68 | 80 | ||

| GPU Cores | 10752 | 10752 | 10496 | 10240 | 8704 | 5120 | ||

| Tensor Cores | 336 | 336 | 328 | 320 | 272 | N/A | ||

| RT Cores | 84 | 84 | 82 | 80 | 68 | 80 | ||

| Boost Clock (MHz) | 1950 (OC mode) | 1860 | 1695 | 1665 | 1710 | 2250 | ||

| VRAM Speed (Gbps) | 21 | 21 | 19. 5 5 | 19 | 19 | 16 | ||

| VRAM (GB) | 24 | 24 | 24 | 12 | 10 | 16 | ||

| VRAM Bus Width | 384 | 384 | 384 | 384 | 320 | 256 | ||

| ROPs | 112 | 112 | 112 | 112 | 96 | 128 | ||

| TMUs | 336 | 336 | 328 | 320 | 272 | 320 | ||

| TFLOPS FP32 (Boost) | 41.9 | 40 | 35.6 | 34.1 | 29.8 | 23 | ||

| TFLOPS FP16 (Tensor) | 168 (335) | 160 (320) | 142 (285) | 136 (273) | 119 (238) | N/A | ||

| RT TFLOPS | 81.9 | 78.1 | 69.5 | 66.6 | 58.1 | N/A | ||

| Пропускная способность (Гбит/с) | 1008 | 1008 | 936 | 912 | 760 | 512 | ||

| TDP (watts) | 480 | 450 | 350 | 350 | 320 | 300 | ||

| Launch Date | Mar 2022 | Mar 2022 | Sep 2020 | Jun 2021 | Sep 2020 | Dec 2020 | ||

| MSRP | $2,099 | $1,999 | $1,499 | $1,199 | $699 | $999 | ||

| Online Price | $2,149 | $2,008 | $1,919 | $1,299 | $969 | $1,149 |

The RTX 3090 Ti represents the culmination of Nvidia’s Ampere architecture , с полностью включенным графическим процессором GA102. Это тот же графический процессор в 3090, 3080 Ti и обоих вариантах 3080, только с двумя дополнительными SM по сравнению с GeForce RTX 309.0 , который был запущен еще в сентябре 2020 года. 19 месяцев спустя мы получаем незначительное увеличение количества ядер, скромное повышение тактовой частоты — как на графическом процессоре, так и на памяти GDDR6X — и довольно большой удар под дых. к цене и энергопотреблению.

Это тот же графический процессор в 3090, 3080 Ti и обоих вариантах 3080, только с двумя дополнительными SM по сравнению с GeForce RTX 309.0 , который был запущен еще в сентябре 2020 года. 19 месяцев спустя мы получаем незначительное увеличение количества ядер, скромное повышение тактовой частоты — как на графическом процессоре, так и на памяти GDDR6X — и довольно большой удар под дых. к цене и энергопотреблению.

Последнее немного интересно. Недавно мы сообщали о некоторых тестах лаборатории Игоря, где он ограничил 3090 Ti до 300 Вт. Он снизил производительность до уровня RTX 3080 Ti, но с меньшим энергопотреблением, чем RTX 3080 и даже AMD RX 6800 XT (с использованием нереференсных карт). Nvidia фактически ушла как можно дальше вправо по кривой напряжения, мощности и частоты, выжав последние несколько унций производительности. Затем Asus идет еще дальше и сжимает еще 9.0 МГц вне чипа.

Мы должны задаться вопросом, сколько энергии уходит на память GDDR6X, которая печально известна тем, что потребляет энергию и выделяет тепло. Nvidia переключилась на 16-гигабитные модули с пропускной способностью 21 Гбит/с для 3090 Ti, поэтому вся память может быть на одной стороне печатной платы и, таким образом, выигрывает от улучшенного охлаждения — и мы также видели это в наших тестах, когда карта Asus никогда не превышала 100C на GDDR6X независимо от рабочей нагрузки. Мы даже разогнали память до 23 Гбит/с и по-прежнему не превышали 100°C во время тестирования майнинга, но выдержали только 124 MH/s для Ethereum, что всего на 2 MH/с выше, чем у хорошей RTX 309.0, несмотря на разницу в скорости памяти.

Nvidia переключилась на 16-гигабитные модули с пропускной способностью 21 Гбит/с для 3090 Ti, поэтому вся память может быть на одной стороне печатной платы и, таким образом, выигрывает от улучшенного охлаждения — и мы также видели это в наших тестах, когда карта Asus никогда не превышала 100C на GDDR6X независимо от рабочей нагрузки. Мы даже разогнали память до 23 Гбит/с и по-прежнему не превышали 100°C во время тестирования майнинга, но выдержали только 124 MH/s для Ethereum, что всего на 2 MH/с выше, чем у хорошей RTX 309.0, несмотря на разницу в скорости памяти.

На бумаге RTX 3090 Ti на 12 % быстрее, чем 3090, на вычислениях и имеет на 8 % большую пропускную способность памяти. Работая в режиме OC (а не в игровом режиме по умолчанию), Asus увеличивает тактовую частоту ядра на 5%, что означает, что теоретически карта может быть на 18% быстрее, чем эталонная RTX 3090. На практике это будет немного меньше, чем что, как мы скоро увидим.

Asus GeForce RTX 3090 Ti TUF Gaming OC

Изображение 1 из 13

(Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware) Аппаратное обеспечение) (Изображение предоставлено: Аппаратное обеспечение Тома) (Изображение предоставлено: Аппаратное обеспечение Тома) (Изображение предоставлено: Аппаратное обеспечение Тома) (Изображение предоставлено: Аппаратное обеспечение Тома) (Изображение предоставлено: Аппаратное обеспечение Тома) (Изображение предоставлено: Аппаратное обеспечение Тома) (Изображение предоставлено: Аппаратное обеспечение Тома) ) (Изображение предоставлено Tom’s Hardware) Компания Asus предоставила для этого обзора свою GeForce RTX 3090 Ti TUF Gaming OC , большую карту с относительно обычными (для экстремального графического процессора) тройными вентиляторами и занимающую 3,2 слота. Он не такой массивный, как RTX 3090 Ti Founders Edition, который немного тоньше, но весит 2189 г (по крайней мере, столько же весил 3090 FE) и имеет размеры 313x138x57 мм. Карта Asus весит «всего» 1676 г, что практически легковесно! Но его размеры 326x104x63 мм. Это физически впечатляющая карта, что немного само собой разумеющееся, учитывая кремний и его потребности в охлаждении.

Он не такой массивный, как RTX 3090 Ti Founders Edition, который немного тоньше, но весит 2189 г (по крайней мере, столько же весил 3090 FE) и имеет размеры 313x138x57 мм. Карта Asus весит «всего» 1676 г, что практически легковесно! Но его размеры 326x104x63 мм. Это физически впечатляющая карта, что немного само собой разумеющееся, учитывая кремний и его потребности в охлаждении.

Не менее внушительная упаковка: длинная коробка, состоящая из чехла поверх немного необычной внутренней коробки со срезанными углами. Выглядит довольно круто, но на самом деле открыть его было довольно сложно. Для чего-то, что просто окажется на полке или в центре утилизации, Asus, вероятно, мог бы остановиться на традиционной коробке.

Asus RTX 3090 Ti TUF включает в себя три выхода DisplayPort 1.4 и два выхода HDMI 2.1, что немного необычно, поскольку большинство карт в наши дни имеют только до четырех выходов. Кронштейн ввода-вывода по-прежнему имеет ширину всего два слота, что кажется немного странным, учитывая, что карта занимает более трех слотов. Более широкий кронштейн обеспечил бы дополнительную поддержку, и в отличие от Привязка графического процессора EVGA , Asus не включает в комплект ничего дополнительного для решения проблемы провисания карты.

Более широкий кронштейн обеспечил бы дополнительную поддержку, и в отличие от Привязка графического процессора EVGA , Asus не включает в комплект ничего дополнительного для решения проблемы провисания карты.

Питание подается через новый 16-контактный разъем PCIe 5.0, который также совместим с 12-контактным разъемом Nvidia. В комплект входит адаптер, который использует три 8-контактных входа для управления 12-контактным выходом, обеспечивая теоретическую (в спецификации) подачу питания до 450 Вт, а также еще 75 Вт от слота PCIe. Хотя мы обычно не разбираем графические процессоры, стоит отметить, что у Asus есть специальный радиатор VRAM, предназначенный для отвода тепла от памяти. Как мы увидим позже, это определенно работает, и температура памяти не была проблемой во время тестирования.

В отличие от линейки Asus ROG Strix более высокого уровня, количество RGB-подсветки на TUF Gaming относительно приглушено. Подсвечивается только маленький трапециевидный логотип TUF в верхней части карты — ни на вентиляторах, ни на остальной части кожуха подсветки нет. Те, кто любит много побрякушек, вероятно, захотят посмотреть на другие альтернативы, но если вы предпочитаете более сдержанный вид, TUF Gaming работает хорошо и имеет все, что вам нужно.

Те, кто любит много побрякушек, вероятно, захотят посмотреть на другие альтернативы, но если вы предпочитаете более сдержанный вид, TUF Gaming работает хорошо и имеет все, что вам нужно.

Тестовая установка для GeForce RTX 3090 Ti

(Изображение предоставлено Tom’s Hardware)TOM’S HARDWARE 2022 GPU TEST PC

Intel Core i9-12900K (открывается в новой вкладке)

MSI Pro Z690-A WiFi DDR4 (открывается в новой вкладке)

Corsair 2x16GB DDR4-3600 CL16 (открывается в новой вкладке)

Crucial P5 Плюс 2 ТБ (открывается в новой вкладке)

Cooler Master MWE 1250 V2 Gold (открывается в новой вкладке)

Cooler Master PL360 Flux (открывается в новой вкладке)

Cooler Master HAF500

Windows 11 Pro, 64-разрядная

Наш тестовый ПК с графическим процессором и игровой пакет был обновлен в начале 2022 года. Сейчас мы используем Core i9Процессор -12900K , материнская плата MSI Pro Z690-A DDR4 WiFi и память DDR4-3600 (с включенным XMP). Мы также обновили до Windows 11 , чтобы получить максимальную отдачу от Alder Lake . Остальное оборудование вы можете увидеть на коробке.

Мы также обновили до Windows 11 , чтобы получить максимальную отдачу от Alder Lake . Остальное оборудование вы можете увидеть на коробке.

Наши игровые тесты состоят из «стандартного» набора из восьми игр без включенной трассировки лучей (даже если игра ее поддерживает) и отдельного набора из шести игр с «трассировкой лучей», в каждой из которых используется несколько эффектов RT. В этом обзоре мы будем тестировать 4K, 1440p и 1080p с «ультра» настройками, что обычно означает максимальные настройки, за исключением без SSAA, если это возможно. Мы также включаем режим качества DLSS в играх, которые его поддерживают, включая весь набор трассировки лучей и три игры из стандартного набора.

Помимо игровых тестов, у нас также есть набор профессиональных тестов и тестов для создания контента, которые могут использовать GPU. Мы используем SPECviewperf 2020 v3 , Blender 3.10 , OTOY Octane и Vray . Последние три сосредоточены на 3D-рендеринге и поддерживают графические процессоры RTX от Nvidia; только Blender 3. 10 в настоящее время обеспечивает ускорение рендеринга с помощью графического процессора на картах AMD RX 6000. SPECviewperf состоит из набора профессиональных приложений, включая CAD/CAM, медицинские и 3D-рендеринг.

10 в настоящее время обеспечивает ускорение рендеринга с помощью графического процессора на картах AMD RX 6000. SPECviewperf состоит из набора профессиональных приложений, включая CAD/CAM, медицинские и 3D-рендеринг.

Asus GeForce RTX 3090 Ti: производительность в играх 4K

Изображение 1 из 9

Tom’s Hardware) (Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware)В настоящее время это самая быстрая и самая дорогая видеокарта, поэтому 4K Ultra имеет смысл — и Nvidia даже продвигает игры 8K в качестве опции, хотя обычно для достижения разумной частоты кадров требуется поддержка DLSS. Мы не можем протестировать 8K, так как у нас нет монитора 8K, но результаты 4K должны, по крайней мере, дать вам представление о том, чего ожидать, когда вы пытаетесь отобразить в четыре раза больше пикселей.

Имея в виду, что мы имеем дело с картой, разогнанной на заводе, по сравнению с несколькими эталонными моделями с тактовой частотой, мы все равно приятно удивлены, увидев солидный прирост производительности на 10% при сравнении Asus RTX 3090 Ti TUF Gaming OC. против RTX 3090 Founders Edition. Это может показаться не таким уж большим, учитывая (теоретическое) увеличение цены на 500 долларов, но давайте просто укажем на 3090 и 3080 Ti: в этом случае на 300 долларов больше вы получите только на 3,4% больше производительности. Еще одно интересное сравнение, конечно же, — это RTX 3080 Ti с оригинальной 3080 10 ГБ, где дополнительные 500 долларов также принесли на 10% больше производительности. Против RTX 3080, которая остается нашим выбором для лучшая видеокарта , даже при цене ближе к 1000 долларов, чем ее официальная рекомендованная розничная цена в 699 долларов, RTX 3090 Ti обеспечивает общую производительность на 25% выше.

против RTX 3090 Founders Edition. Это может показаться не таким уж большим, учитывая (теоретическое) увеличение цены на 500 долларов, но давайте просто укажем на 3090 и 3080 Ti: в этом случае на 300 долларов больше вы получите только на 3,4% больше производительности. Еще одно интересное сравнение, конечно же, — это RTX 3080 Ti с оригинальной 3080 10 ГБ, где дополнительные 500 долларов также принесли на 10% больше производительности. Против RTX 3080, которая остается нашим выбором для лучшая видеокарта , даже при цене ближе к 1000 долларов, чем ее официальная рекомендованная розничная цена в 699 долларов, RTX 3090 Ti обеспечивает общую производительность на 25% выше.

Не будем сбрасывать со счетов и AMD. Хотя нет никаких сомнений в том, что RTX 3090 Ti быстрее, чем AMD RX 6900 XT, в среднем в нашем стандартном наборе тестов разница составляет всего 18%. Это в лучшем случае для графического процессора Nvidia при тестировании в разрешении 4K Ultra. Есть даже такие игры, как Forza Horizon 5 , где 6900 XT по-прежнему выходит вперед, хотя и с небольшим отрывом в 4%. Вообще говоря, Nvidia может победить с помощью грубой силы, но она потребляет примерно на 50% больше энергии и стоит примерно в два раза больше, чем лучшее предложение AMD.

Вообще говоря, Nvidia может победить с помощью грубой силы, но она потребляет примерно на 50% больше энергии и стоит примерно в два раза больше, чем лучшее предложение AMD.

Nvidia также любит продвигать DLSS не только как решение для игр с трассировкой лучей, но и для любой игры . Используя режим «Качество», который в разрешении 4K выглядит почти так же, как и в обычном режиме, давайте проверим три игры, поддерживающие DLSS. Horizon Zero Dawn повышает производительность на 30%, Watch Dogs Legion — на 35%… а Red Dead Redemption 2 — только на 15%. Не все игровые движки созданы одинаковыми, и, по-видимому, способ, которым DLSS был встроен в RDR2 — более 18 месяцев после запуска, не меньше — доказывает это. Прирост еще меньше при более низких разрешениях.

Изображение 1 из 7

(Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) ( Изображение предоставлено Tom’s Hardware) Если вернуться к нашему набору тестов трассировки лучей, история DLSS полностью изменится. DLSS может быть хорошим дополнением к такой карте, как Asus RTX 309.0 Ti в традиционных играх, но если вы хотите использовать максимальные настройки трассировки лучей, это становится абсолютно необходимым при разрешении 4K. 3090 Ti с трудом преодолевает отметку в 30 кадров в секунду в исходном режиме, и половина игр не дотягивают до этой отметки. Включите DLSS, и производительность увеличится почти вдвое, с 32 до 60 кадров в секунду.

DLSS может быть хорошим дополнением к такой карте, как Asus RTX 309.0 Ti в традиционных играх, но если вы хотите использовать максимальные настройки трассировки лучей, это становится абсолютно необходимым при разрешении 4K. 3090 Ti с трудом преодолевает отметку в 30 кадров в секунду в исходном режиме, и половина игр не дотягивают до этой отметки. Включите DLSS, и производительность увеличится почти вдвое, с 32 до 60 кадров в секунду.

У нас нет результатов DLSS для всех карт в наших диаграммах только потому, что они начинают переполняться, поэтому мы просто сосредоточимся на собственной производительности для оставшихся сравнений. Интересно посмотреть на Asus 3090 Ti опережает эталонную RTX 3090 в целом на 14%, что близко к теоретическому максимуму. Карта Asus имеет тактовую частоту 1950 МГц в режиме OC, тогда как RTX 3090 Founders Edition имеет тактовую частоту 1695 МГц, что дает максимальную разницу в 15%.

Хотя разрыв в 14% может показаться не таким уж большим, еще раз взгляните на другие карты. 3090 всего на 3% быстрее, чем 3080 Ti, что на 16% быстрее, чем карта 3080 10 ГБ. Также обратите внимание, что разогнанный MSI 3080 12 ГБ на 12% быстрее, чем 3080 Founders Edition, почти сравнявшись с 3080 Ti, поэтому пропускная способность памяти, безусловно, является важным фактором в общей производительности при разрешении 4K. Асус 3090 Ti по-прежнему превосходит RTX 3080 только на 37%, так что это в значительной степени случай убывающей отдачи. Между тем, он на 88% быстрее, чем лучший процессор AMD, и на 250% быстрее, если мы включим DLSS.

3090 всего на 3% быстрее, чем 3080 Ti, что на 16% быстрее, чем карта 3080 10 ГБ. Также обратите внимание, что разогнанный MSI 3080 12 ГБ на 12% быстрее, чем 3080 Founders Edition, почти сравнявшись с 3080 Ti, поэтому пропускная способность памяти, безусловно, является важным фактором в общей производительности при разрешении 4K. Асус 3090 Ti по-прежнему превосходит RTX 3080 только на 37%, так что это в значительной степени случай убывающей отдачи. Между тем, он на 88% быстрее, чем лучший процессор AMD, и на 250% быстрее, если мы включим DLSS.

Будет интересно посмотреть, какой будет популярность процессора AMD FSR 2.0 после того, как он будет выпущен для широкой публики в ближайшие пару месяцев. Также будет интересно посмотреть, начнет ли AMD оснащать свои будущие графические процессоры матричным оборудованием (то есть тензорными ядрами), что делает и Intel со своими 9 процессорами.0043 Видеокарты Arc . Учитывая, что Intel XeSS является скорее прямым конкурентом DLSS, и он также будет работать на графических процессорах других производителей, возможно, AMD присоединится к Intel в борьбе с DLSS в будущем. Конечно, было бы неплохо, если бы у нас было одно универсальное решение для апскейлинга, за которым могли бы стоять все три компании, но я съем свою шляпу с GPU, если это произойдет.

Конечно, было бы неплохо, если бы у нас было одно универсальное решение для апскейлинга, за которым могли бы стоять все три компании, но я съем свою шляпу с GPU, если это произойдет.

Asus GeForce RTX 3090 Ti: игровая производительность 1440p

Изображение 1 из 9

Оборудование Тома) (Изображение предоставлено: Оборудование Тома) (Изображение предоставлено: Оборудование Тома) (Изображение предоставлено: Оборудование Тома) (Изображение предоставлено: Оборудование Тома)При понижении до 1440p преимущество 3090 Ti над конкурентами немного сокращается. Теперь он всего на 7% быстрее, чем RTX 3090, на 20% быстрее, чем RTX 3080 10 ГБ, и на 6% быстрее, чем RX 6900 XT. Без более быстрого ЦП, передающего данные на видеокарты, мы уже начинаем видеть узкие места ЦП — Far Cry 6 , Flight Simulator и Horizon Zero Dawn явно выдыхаются.

Режим качества DLSS еще раз подтверждает это. Накладные расходы, связанные с DLSS, означают, что в некоторых случаях производительность повышается лишь незначительно. Watch Dogs Legion по-прежнему имеет рост на 17%, но производительность в Horizon Zero Dawn и Red Dead Redemption 2 выросла только примерно на 7%. Покупка карты, такой как RTX 3090 Ti, для традиционных игр, даже с максимальными настройками, не имеет особого смысла, если у вас нет монитора 4K или, возможно, сверхширокого монитора 1440p.

Watch Dogs Legion по-прежнему имеет рост на 17%, но производительность в Horizon Zero Dawn и Red Dead Redemption 2 выросла только примерно на 7%. Покупка карты, такой как RTX 3090 Ti, для традиционных игр, даже с максимальными настройками, не имеет особого смысла, если у вас нет монитора 4K или, возможно, сверхширокого монитора 1440p.

Изображение 1 из 7

(Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) ( Изображение предоставлено: Аппаратное обеспечение Тома) Но, если вам действительно нравятся эффекты трассировки лучей и самые требовательные игры, родное 1440p может очень сильно использовать более быстрый графический процессор. Например, Asus 3090 Ti по-прежнему превосходит ванильный 3090 в среднем на 13%. Кроме того, она была на 30% быстрее, чем 3080 10 ГБ, и на 75% быстрее, чем AMD RX 6900 XT — и снова включение DLSS приносит огромные дивиденды, улучшая результаты карты Asus на 60% в целом.

Глядя на отдельные диаграммы, Asus 3090 Ti едва достигает средней скорости 60 кадров в секунду в наших шести играх DXR, но в трех играх он падает ниже 50 кадров в секунду. С включенным DLSS все шесть игр комфортно переходят отметку в 60 кадров в секунду, и если у вас есть дисплей с высокой частотой обновления G-Sync (или совместимый с G-Sync), вы можете получить очень плавный игровой процесс.

Но кого мы обманываем? Эта карта является избыточной для большинства геймеров. Вам лучше дождаться графических процессоров следующего поколения в конце этого года, чем тратить две тысячи только на видеокарту сейчас.

Asus GeForce RTX 3090 Ti: игровая производительность 1080p

Изображение 1 из 9

Оборудование Тома) (Изображение предоставлено: Оборудование Тома) (Изображение предоставлено: Оборудование Тома) (Изображение предоставлено: Оборудование Тома) (Изображение предоставлено: Оборудование Тома) Ладно, мы видим, как ты закатываешь глаза. Да, игры в разрешении 1080p на RTX 3090 Ti представляют собой очень несбалансированную рабочую нагрузку. Это все еще на 5% быстрее, чем старая RTX 3090, но вы могли бы получить большую часть этого с картой 3090, разогнанной на заводе 18 месяцев назад. Почти втрое превышающая теоретическую цену, RTX 3090 Ti лишь примерно на 15% быстрее, чем RTX 3080 при разрешении 1080p. Он также в основном связан с RX 6900 XT, который теперь претендует на победы в половине игр в нашем тестовом наборе.

Это все еще на 5% быстрее, чем старая RTX 3090, но вы могли бы получить большую часть этого с картой 3090, разогнанной на заводе 18 месяцев назад. Почти втрое превышающая теоретическую цену, RTX 3090 Ti лишь примерно на 15% быстрее, чем RTX 3080 при разрешении 1080p. Он также в основном связан с RX 6900 XT, который теперь претендует на победы в половине игр в нашем тестовом наборе.

Неудивительно, что DLSS здесь тоже мало что может. Лучший результат был в Red Dead Redemption 2 , где производительность улучшилась на 4%. Не то чтобы вам действительно нужен DLSS в 1080p с таким графическим процессором, но узкие места процессора присутствуют почти во всех играх. Flight Simulator особенно плох, его производительность лишь немного выше, чем при 1440p, а это означает, что он почти полностью ограничен процессором.

Изображение 1 из 14

(Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) ( Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено кредит: оборудование Тома) Однако наш тестовый набор DXR по-прежнему довольно требователен. Все игры могут разогнаться до 60 кадров в секунду, но 3090 Ti по-прежнему имеет в среднем на 11% более высокую производительность, чем эталонная RTX 3090, и на 27% лучшую производительность, чем RTX 3080. AMD RX 6900 XT по-прежнему отстает на 40%, и это не может даже усреднить 60 кадров в секунду в четырех из шести протестированных нами игр. Включите DLSS, и преимущество Nvidia возрастет еще больше.

Все игры могут разогнаться до 60 кадров в секунду, но 3090 Ti по-прежнему имеет в среднем на 11% более высокую производительность, чем эталонная RTX 3090, и на 27% лучшую производительность, чем RTX 3080. AMD RX 6900 XT по-прежнему отстает на 40%, и это не может даже усреднить 60 кадров в секунду в четырех из шести протестированных нами игр. Включите DLSS, и преимущество Nvidia возрастет еще больше.

Судя по тому, что нам известно об аппаратном обеспечении, ускорители лучей AMD примерно в два раза медленнее ядер RT в графических процессорах Nvidia Ampere. На самом деле все еще хуже, учитывая, что частота графического процессора AMD при тестировании составляет более 2,3 ГГц, а у Asus 3090 Ti ближе к 2 ГГц. Таким образом, 84 ядра RT против 80 ускорителей лучей, и даже в разрешении 1080p Ultra графический процессор Nvidia в среднем на 66% быстрее.

Также интересно взглянуть на графические процессоры Nvidia Turing предыдущего поколения. RTX 2080 Ti имеет 68 ядер RT, работающих на частоте около 1,7 ГГц, и все еще находится на расстоянии вытянутой руки от AMD RX 6900 XT. 2080 Ti была быстрее в Cyberpunk 2077 и Minecraft , в то время как карта AMD вышла вперед в других играх. Насколько AMD улучшит производительность RT с помощью RDNA3, и найдет ли Nvidia новые способы повышения производительности с помощью Ada? Мы узнаем позже в этом году.

2080 Ti была быстрее в Cyberpunk 2077 и Minecraft , в то время как карта AMD вышла вперед в других играх. Насколько AMD улучшит производительность RT с помощью RDNA3, и найдет ли Nvidia новые способы повышения производительности с помощью Ada? Мы узнаем позже в этом году.

Asus GeForce RTX 3090 Ti: профессиональная производительность и производительность при создании контента

Графические процессорыпредназначены не только для игр, их можно использовать для профессиональных рабочих нагрузок, обучения искусственного интеллекта и получения логических выводов и многого другого. Мы стремимся расширить некоторые из наших тестов графических процессоров, особенно для экстремальных графических процессоров, таких как RTX 3090 Ti. На данный момент у нас есть несколько приложений для 3D-рендеринга, использующих оборудование для трассировки лучей, а также набор тестов SPECviewperf 2020 v3. Мы начнем там.

Изображение 1 из 9

(Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) ( Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware) SPECviewperf 2020 состоит из восьми различных тестов. Мы также включили «общую» диаграмму, которая использует среднее геометрическое восьми результатов для получения совокупного балла. Обратите внимание, что это не официальная оценка, но она дает равный вес отдельным тестам и обеспечивает общий обзор производительности. Однако немногие профессионалы используют все этих программ, поэтому, как правило, более важно смотреть на результаты для приложений, которые вы планируете использовать.

Мы также включили «общую» диаграмму, которая использует среднее геометрическое восьми результатов для получения совокупного балла. Обратите внимание, что это не официальная оценка, но она дает равный вес отдельным тестам и обеспечивает общий обзор производительности. Однако немногие профессионалы используют все этих программ, поэтому, как правило, более важно смотреть на результаты для приложений, которые вы планируете использовать.

Что сразу интересно, так это то, насколько далеко впереди других графических процессоров находится Titan RTX. Это связано с тем, что Nvidia предоставляет некоторые улучшения на уровне драйверов для своих карт Titan, и, несмотря на цену Titan-esque, RTX 3090 Ti не получает такого же обращения. Просматривая результаты отдельных тестов, в основном благодаря огромному лидерству в тесте snx-04 (Siemens NX) Titan RTX получает общее лидерство, хотя он также занимает первое место в тестах catia-06 и creo-03.

RTX 3090 Ti также одержала несколько побед, получив высшие оценки в 3dsmax-07, Energy-03, Maya-06 и SolidWorks-07. В то же время графические процессоры AMD показывают смешанные результаты. Они находятся в нижней половине диаграмм 3dsmax, catia, creo и maya, но RX 6900 XT занимает второе место в наборе энергетических тестов, получает высший результат в медицинском-03, а карты AMD более чем в три раза быстрее, чем карты GeForce в snx-04 — только Titan RTX превосходит их еще в 4 раза. .

В то же время графические процессоры AMD показывают смешанные результаты. Они находятся в нижней половине диаграмм 3dsmax, catia, creo и maya, но RX 6900 XT занимает второе место в наборе энергетических тестов, получает высший результат в медицинском-03, а карты AMD более чем в три раза быстрее, чем карты GeForce в snx-04 — только Titan RTX превосходит их еще в 4 раза. .

Изображение 1 из 4

(Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware) снимать полнометражные фильмы. Мы используем последнюю версию Blender Benchmark, в которой используется Blender 3.10 и три теста. Blender 3.10 включает в себя новый движок Cycles X, который использует аппаратное обеспечение трассировки лучей на графических процессорах AMD и Nvidia. Как и в случае с набором игровых тестов DXR, графические процессоры AMD сильно отстают от предложений Nvidia, когда речь идет об аппаратном обеспечении RT, по крайней мере, о чем свидетельствует Blender. В целом, RTX 3090 Ti обеспечивает более чем в три раза более высокую производительность, чем RX 6900 XT.

В целом, RTX 3090 Ti обеспечивает более чем в три раза более высокую производительность, чем RX 6900 XT.

Мы также обнаружили ошибку с текущими драйверами AMD, из-за которой включение PCIe Resizable BAR сильно повлияло на производительность рендеринга Blender 3.10. Это должно быть исправлено в будущем выпуске драйвера, но если вы используете Blender на графическом процессоре AMD прямо сейчас, вам нужно отключить ReBAR в BIOS.

Изображение 1 из 7

(Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) (Изображение предоставлено: Tom’s Hardware) ( Изображение предоставлено Tom’s Hardware) OTOY Octane — еще один популярный движок рендеринга, но, в отличие от Blender, он не поддерживает графические процессоры AMD серии RX 6000. Таким образом, мы ограничили наши диаграммы графическими процессорами Nvidia, где RTX 3090 Ti, что неудивительно, занимает первое место, обеспечивая на 6% более высокую производительность, чем стандартная RTX 309. 0. Скорее всего, эти приложения рендеринга больше зависят от пропускной способности памяти, чем от вычислений графического процессора, поэтому все три в итоге работают примерно на 6% быстрее с 3090 Ti.

0. Скорее всего, эти приложения рендеринга больше зависят от пропускной способности памяти, чем от вычислений графического процессора, поэтому все три в итоге работают примерно на 6% быстрее с 3090 Ti.

Nvidia также отмечает, что существуют рабочие нагрузки рендеринга, с которыми может справиться RTX 3090 Ti (а также 3090 и Titan RTX), которые просто не работают на графических процессорах, у которых не так много видеопамяти. Это правда, и именно поэтому настоящие профессиональные графические процессоры, такие как Nvidia RTX A6000, поставляются с колоссальными 48 ГБ видеопамяти. Однако сравнительные тесты становятся бессмысленными, если вы даже не можете запустить тест на большинстве видеокарт.

Изображение 1 из 2

(Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware) Как и Octane, Chaos V-ray в настоящее время также не поддерживает графические процессоры AMD, поэтому мы тестировали только карты Nvidia RTX. Как и в Octane, у него более старый путь рендеринга CUDA, а также поддержка нового пути RTX, в котором используются ядра Nvidia RT. Режим RTX повышает производительность примерно на 30% на новых графических процессорах Ampere, в то время как Titan RTX работает на 40% быстрее.

Режим RTX повышает производительность примерно на 30% на новых графических процессорах Ampere, в то время как Titan RTX работает на 40% быстрее.

[Примечание: мы все еще ищем хороший эталонный тест ИИ/машинного обучения, «хороший» означает, что его легко запустить, предпочтительно в системах Windows, и что результаты актуальны. Нам не нужно что-то, что работает только на графических процессорах Nvidia или AMD или требует тензорных ядер. В идеале он будет использовать тензорные ядра, если они доступны (Nvidia RTX и Intel Arc), или ядра графического процессора, если нет (графические процессоры GTX и текущая потребительская линейка AMD). Если у вас есть какие-либо предложения, пожалуйста, свяжитесь со мной — напишите мне на форуме или отправьте мне электронное письмо. Спасибо!]

Asus GeForce RTX 3090 Ti: мощность, температура, шум и т. д.

(Изображение предоставлено Tom’s Hardware) высокая. Теперь пришло время испытать резину на дороге, поскольку мы проверяем реальное энергопотребление, используя наше тестовое оборудование и программное обеспечение Powenetics . Мы фиксируем встроенное энергопотребление графического процессора путем сбора данных во время зацикливания Metro Exodus в разрешении 1440p Ultra, а также во время стресс-теста FurMark в разрешении 1600×900. Наш тестовый ПК для тестирования питания остается тем же самым старым Core i9-9900K, который мы использовали ранее, чтобы результаты оставались стабильными. Мы протестировали карту Asus во всех трех стандартных режимах: по умолчанию (игровой), OC и без звука. Эти режимы можно выбрать в утилите Asus GPU Tweak II (откроется в новой вкладке).

Мы фиксируем встроенное энергопотребление графического процессора путем сбора данных во время зацикливания Metro Exodus в разрешении 1440p Ultra, а также во время стресс-теста FurMark в разрешении 1600×900. Наш тестовый ПК для тестирования питания остается тем же самым старым Core i9-9900K, который мы использовали ранее, чтобы результаты оставались стабильными. Мы протестировали карту Asus во всех трех стандартных режимах: по умолчанию (игровой), OC и без звука. Эти режимы можно выбрать в утилите Asus GPU Tweak II (откроется в новой вкладке).

Изображение 1 из 4

(Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware) Вот это интересно. Начиная с результатов Metro Exodus , мы, вероятно, сталкиваемся с узкими местами ЦП. Пиковое энергопотребление составило «всего» 438 Вт как в режиме по умолчанию, так и в модели OC. Бесшумный режим немного снизил энергопотребление, но, к сожалению, похоже, что нам может потребоваться обновить нашу методологию тестирования для таких карт.

Бесшумный режим немного снизил энергопотребление, но, к сожалению, похоже, что нам может потребоваться обновить нашу методологию тестирования для таких карт.

Переходя к FurMark , по крайней мере, мы получили некоторое разделение, и это, вероятно, ближе к ограничениям, налагаемым прошивкой карты. В режиме по умолчанию мы увидели среднее энергопотребление около 470 Вт, в режиме OC оно увеличилось до более чем 49 Вт.0 Вт, а в режиме без звука карта потребляет чуть более 440 Вт. Это самое высокое энергопотребление графического процессора, которое мы видели за последние годы без разгона конечным пользователем, примерно на 80 Вт. Возможно, есть некоторые пользовательские карты RTX 3090 или RX 6900 XT, которые приблизились к этому уровню, но мы не использовали их для тестирования.

В этих результатах нет ничего удивительного. Больше ядер графического процессора при гораздо более высоких тактовых частотах, а также память GDDR6X с более высокими тактовыми частотами в совокупности значительно увеличивают энергопотребление. Раньше я думал, что ранние слухи о 600-ваттной RTX 4090 карт позже в этом году были смехотворны. Теперь такие разговоры больше похожи на ощущение неизбежности.

Раньше я думал, что ранние слухи о 600-ваттной RTX 4090 карт позже в этом году были смехотворны. Теперь такие разговоры больше похожи на ощущение неизбежности.

Изображение 1 из 4

(Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware)Тестирование Metro проводилось на частоте 2 ГГц, а в режиме OC частота увеличилась до 2074 МГц. Мы видели гораздо более высокие тактовые частоты графических процессоров AMD RX 6000, но они спроектированы для работы на более высоких скоростях и, как правило, не настолько прожорливы. Если перейти от 3090 с частотой 1850 МГц для 3090 Ti с частотой 2074 МГц требует на 75 Вт больше энергии, только представьте, сколько энергии потребуется графическому процессору Ampere с частотой 2,5 ГГц! Или нет — мы, вероятно, узнаем с Адой.

Тактовые частоты в FurMark были немного медленнее, как и ожидалось. В отличие от игры, FurMark оказывает большую нагрузку на графический процессор и, как правило, потребляет больше энергии за такт, чем любая другая рабочая нагрузка. Тактовая частота здесь в среднем составляла чуть более 1,6 ГГц с профилем OC, 1,44 ГГц с игровым профилем по умолчанию и упала до 1,23 ГГц в беззвучном режиме.

Тактовая частота здесь в среднем составляла чуть более 1,6 ГГц с профилем OC, 1,44 ГГц с игровым профилем по умолчанию и упала до 1,23 ГГц в беззвучном режиме.

Изображение 1 из 4

(Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware)Изображение 1 из 4

(Изображение предоставлено Tom’s Hardware) (Изображение кредит: Tom’s Hardware) (Изображение предоставлено Tom’s Hardware) (Изображение предоставлено Tom’s Hardware)Asus отлично справляется с охлаждением графического процессора 3090 Ti со средней температурой 65 ° C во всех трех профилях производительности при работе Metro . FurMark как всегда поднажал, но только до 67С в режиме разгона. Скорость вращения вентилятора в основном следовала за температурой. И в играх и в FurMark разница между режимами Silent и OC составила всего 100 об/мин.

Мы также измерили уровень шума на расстоянии 10 см с помощью измерителя SPL (уровня звукового давления). SPL был направлен прямо на вентиляторы графического процессора, чтобы свести к минимуму влияние других вентиляторов, например, на процессорный кулер. Уровень шума нашей тестовой среды и оборудования составляет 33 дБ(А). Поскольку мы использовали игровую нагрузку для тестирования шума, разница между режимами была меньше. Примерно через 15 минут беззвучный режим стабилизировался на отметке 48,9.дБ(А), в то время как в режимах Gaming и OC звук был чуть громче — 49,1 дБ(А). GPU Tweak II сообщил о скорости вентилятора 74%, что означает, что не было тонны доступного запаса, но уровни шума и температуры в целом были очень хорошими.

SPL был направлен прямо на вентиляторы графического процессора, чтобы свести к минимуму влияние других вентиляторов, например, на процессорный кулер. Уровень шума нашей тестовой среды и оборудования составляет 33 дБ(А). Поскольку мы использовали игровую нагрузку для тестирования шума, разница между режимами была меньше. Примерно через 15 минут беззвучный режим стабилизировался на отметке 48,9.дБ(А), в то время как в режимах Gaming и OC звук был чуть громче — 49,1 дБ(А). GPU Tweak II сообщил о скорости вентилятора 74%, что означает, что не было тонны доступного запаса, но уровни шума и температуры в целом были очень хорошими.

Asus GeForce RTX 3090 Ti: да здравствует король

(Изображение предоставлено Tom’s Hardware) Есть много способов взглянуть на GeForce RTX 3090 Ti. Это карта для создания контента для профессиональных пользователей, которая лишь немного быстрее своей предшественницы по еще более высокой цене. Это также самая быстрая видеокарта для игр, доступная в настоящее время, по-прежнему по неприлично высокой цене. Одна вещь, которой это не является полной заменой Titan RTX, и мы можем только догадываться, что у Nvidia было слишком много людей, покупающих сравнительно недорогие карты Titan и отказывающихся от бывших Quadro и текущих линеек A-серии, которые могут стоить вдвое дороже.

Одна вещь, которой это не является полной заменой Titan RTX, и мы можем только догадываться, что у Nvidia было слишком много людей, покупающих сравнительно недорогие карты Titan и отказывающихся от бывших Quadro и текущих линеек A-серии, которые могут стоить вдвое дороже.

Нет никаких сомнений в том, что RTX 3090 Ti представляет собой хорошую цену. С точки зрения FPS на потраченный доллар, из 57 видеокарт, протестированных нами в нашей иерархии тестов GPU , RTX 3090 Ti занимает 56-е место — только Radeon VII представляет худшее значение. В то же время мы должны смотреть на вещи в перспективе. Если у вас есть деньги и вам нужно самое быстрое оборудование, RTX 3090 Ti действительно повышает производительность примерно на 10% по сравнению с RTX 3090, которая по-прежнему стоит 1,9 доллара.00 на момент написания. Опять же, не то чтобы вы должны покупать такой графический процессор, но по этому показателю вы можете утверждать, что он стоит дополнительных 100 долларов.

Настоящая проблема с RTX 3090 Ti заключается не в ее производительности или цене, а в том, что она так поздно появляется на вечеринке Ampere. RTX 3090 была выпущена в сентябре 2020 года, 19 месяцев назад, и все указывает на то, что в сентябре мы получим графические процессоры Ada следующего поколения. Мы понятия не имеем, сколько они будут стоить, но практически нет шансов, что гипотетическая RTX 4090 не будет быстрее, чем RTX 3090 Ti, и может даже стоить дешевле.

RTX 3090 была выпущена в сентябре 2020 года, 19 месяцев назад, и все указывает на то, что в сентябре мы получим графические процессоры Ada следующего поколения. Мы понятия не имеем, сколько они будут стоить, но практически нет шансов, что гипотетическая RTX 4090 не будет быстрее, чем RTX 3090 Ti, и может даже стоить дешевле.

Если Nvidia сохранит свою недавнюю модель запуска графических процессоров, то RTX 4090 должна вызывать у вас меньше всего беспокойства. Мы, вероятно, также получим RTX 4080, которая обеспечивает на 30–40% больше производительности, чем RTX 3090 Ti, по цене 999 долларов или меньше. Есть также тот факт, что цены на GPU в этом году, наконец, имеют тенденцию к снижению и упали более чем на 35% с начала года. Мы ожидаем, что эта тенденция продолжится, и есть даже сообщения о том, что AMD и Nvidia входят в состояние избыточного предложения.

Как бы вы ни смотрели на вещи, тратить деньги на недолговечного царя горы для нас не имеет особого смысла. Но если у вас полно денег или вы выполняете такую работу, когда обновляете видеокарту за 2000 долларов, которая всего на 5–10% быстрее, чем ваша текущая карта, окупит себя за несколько месяцев, это карта для вас. Раскаяние покупателя может проявиться, как только появятся детали следующего поколения, но затем вы можете продать 3090 Ti (с убытком) и снова обновиться, гарантируя, что вы останетесь на вершине иерархии графического процессора.

Но если у вас полно денег или вы выполняете такую работу, когда обновляете видеокарту за 2000 долларов, которая всего на 5–10% быстрее, чем ваша текущая карта, окупит себя за несколько месяцев, это карта для вас. Раскаяние покупателя может проявиться, как только появятся детали следующего поколения, но затем вы можете продать 3090 Ti (с убытком) и снова обновиться, гарантируя, что вы останетесь на вершине иерархии графического процессора.

- Подробнее: Лучшие видеосадочные карты

- Подробнее: .

Джарред Уолтон — старший редактор Tom’s Hardware, специализирующийся на GPU. Он работает техническим журналистом с 2004 года, пишет для AnandTech, Maximum PC и PC Gamer. От первых «3D-замедлителей» S3 Virge до современных графических процессоров — Джарред следит за всеми последними графическими тенденциями и всегда задает вопросы о производительности игр.

MSI GeForce RTX 3080 12GB Suprim X Обзор: Ti Fighter

Аппаратный вердикт Тома

MSI GeForce RTX 3080 12 ГБ Suprim X удалось эффективно сравняться с производительностью RTX 3080 Ti в большинстве ситуаций благодаря отличному заводскому разгону.

К сожалению, розничные цены выглядят столь же высокими, что устраняет один потенциальный недостаток. В итоге он становится еще одной моделью RTX 30-й серии в уже переполненном ландшафте по все еще завышенной цене.

К сожалению, розничные цены выглядят столь же высокими, что устраняет один потенциальный недостаток. В итоге он становится еще одной моделью RTX 30-й серии в уже переполненном ландшафте по все еще завышенной цене.Плюсы

- +

+ 384-битный интерфейс памяти

- +

+ Большой заводской разгон

- +

+ Соответствует 3080 Ti по производительности