Какие бывают видеокарты для компьютера, 3 типа 💻

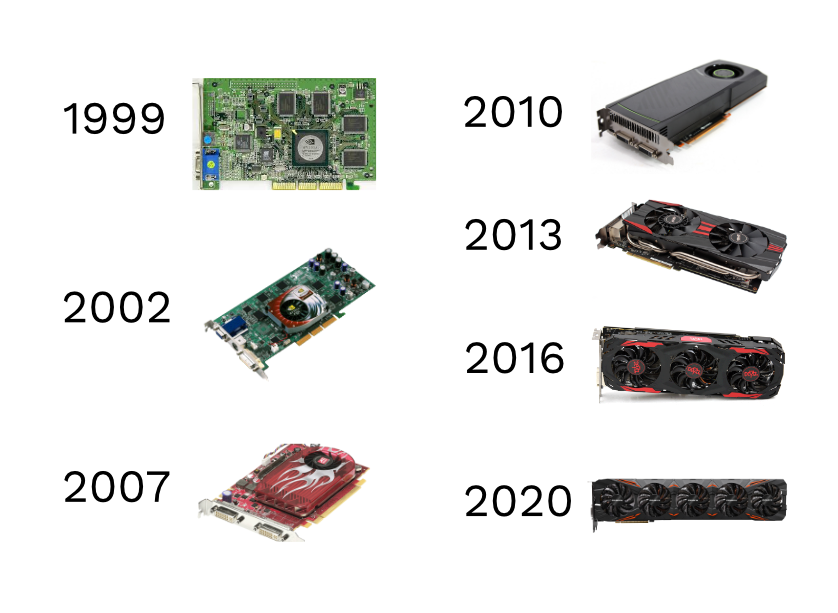

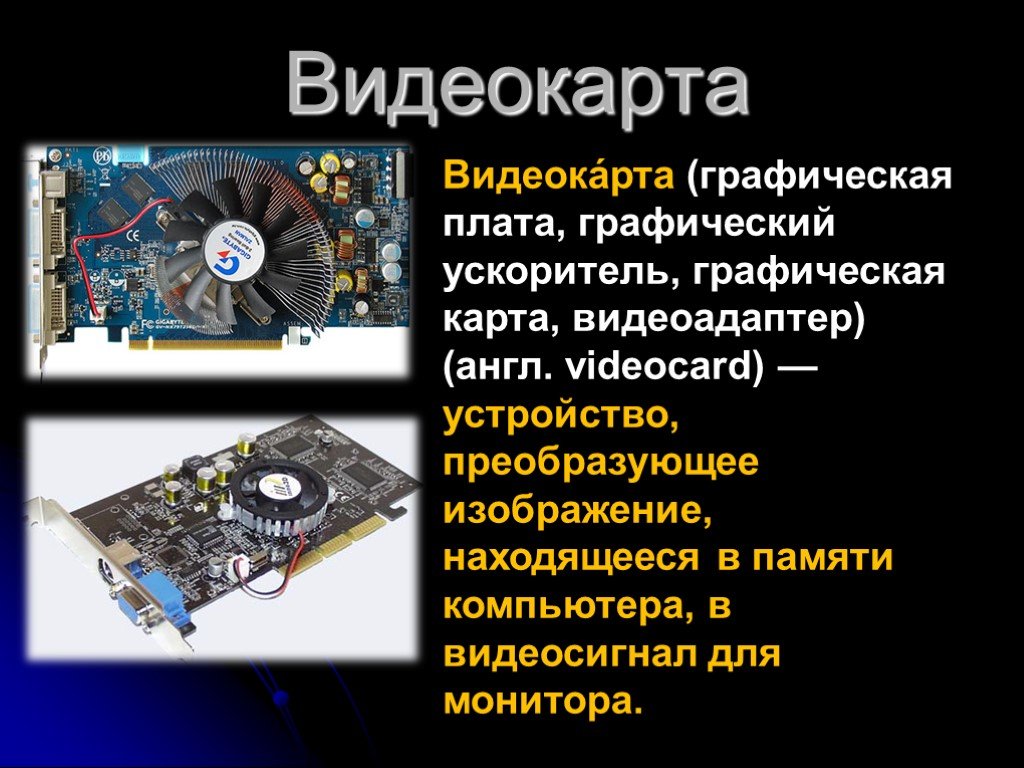

Исторически так сложилось, что видеокарты для компьютера разделились на дискретные (внешние) и интегрированные (встроенные). Каждый вариант конечно же имеет право на жизнь. Сегодня понятие «видеокарта» стало синонимом «графического ускорителя». А ведь раньше видеокартой считалось любое устройство способное выводить изображение с компьютера на монитор.

Тогда видеокарты были чёрно-белые и цветные 🙂 Потом цветные стали разделяться по количеству максимально отображаемых цветов и максимально поддерживаемому разрешению экрана. Сначала были четырёхцветные карточки CGA с разрешением 320×200, потом появились продвинутые EGA с 16 цветами и максимальным разрешением 640×350, и уж потом прославленные VGA с 256 цветами. Причём после смены каждой видеокарты необходимо было менять монитор!

Первые 3D-игры для компьютера не знали что такое графический ускоритель, со всеми вычислениями успешно справлялся центральный процессор и сопроцессор. Чтобы игры лучше шли, надо было просто поменять процессор, а от видеокарты почти ничего не зависело. Потом уже появились стандарты OpenGL и DirectX, который стали поддерживать видеокарты и игры. И сегодня любая видеокарта умеет работать с 3D графикой, а не только выводить картинку на экран.

Чтобы игры лучше шли, надо было просто поменять процессор, а от видеокарты почти ничего не зависело. Потом уже появились стандарты OpenGL и DirectX, который стали поддерживать видеокарты и игры. И сегодня любая видеокарта умеет работать с 3D графикой, а не только выводить картинку на экран.

Небольшой экскурс в историю закончен, аж полегчало 🙂

Содержание

Что такое интегрированная видеокарта

Интегрированный – значит собранный воедино, без возможности разъединения. Интегрированные видеокарты раньше встраивались в чипсеты материнских, а теперь — в центральные процессоры. Они не имеют собственной памяти, а используют общую оперативную память. Прежде всего хочу отметить, что встроенные решения, видеокартой называть в принципе некорректно. И не потому что они медленные, а потому что карточки как таковой нет, это просто набор логики встроенной в центральный процессор, но так уж повелось.

Самая популярная интегрированная видеокарта — Intel HD, хорошо знакома владельцам компактных домашних кинотеатров на базе ПК, и обладателям ноутбуков и нетбуков. У интегрированной графики есть бесспорные преимущества:

У интегрированной графики есть бесспорные преимущества:

- цена! стоимость встроенного графического решения в разы меньше, чем дискретной видеокарты

- компактность, ведь она вовсе не занимает дополнительное место в компьютере

- низкое энергопотребление, что немаловажно для портативных компьютеров

- достаточная производительность в офисных приложениях

- тишина в работе, поскольку отсутствуют собственные вентиляторы

Наряду с достоинствами, естественно есть недостатки:

- низкая производительность в 3D-графике

- качество изображения может хромать

- использует оперативную память

- используется общая система охлаждения, поэтому сильнее нагревается процессор

Замечу, что низкая производительность касается новых игр. Всё относительно, ведь на современной встроенной видеокарте можно поиграть в игрушку, которую тянула дорогая внешняя видеокарта несколько лет назад. Современные интегрированные графические решения встроенные в процессоры архитектур Intel Sandy/Ivy Bridge и AMD Fusion могут потягаться с бюджетными видеокартами.

Что такое дискретная видеокарта и зачем она нужна

В электронике слово «дискретный» означает устройство, имеющее раздельные компоненты. То есть, это отдельное устройство, имеющее в своём личном распоряжении всё необходимое для работы, и может быть заменено на другое устройство с подходящими параметрами. Таким образом, дискретная видеокарта это отдельная внешняя карточка, которую можно достать и заменить на другую подходящую карту.

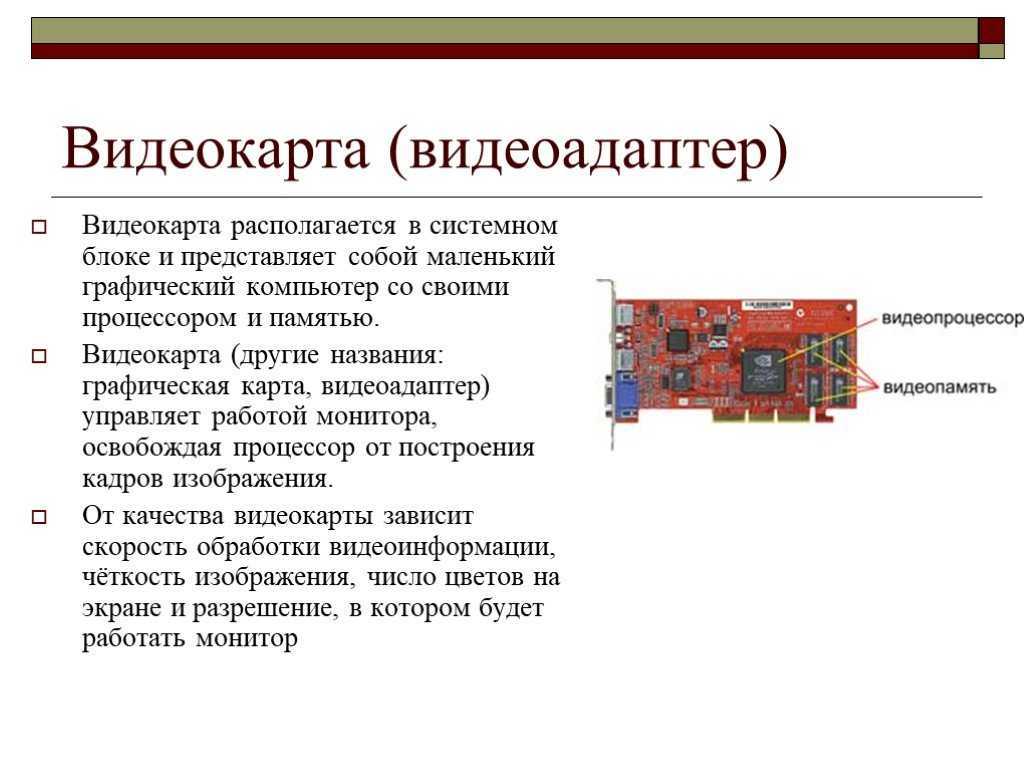

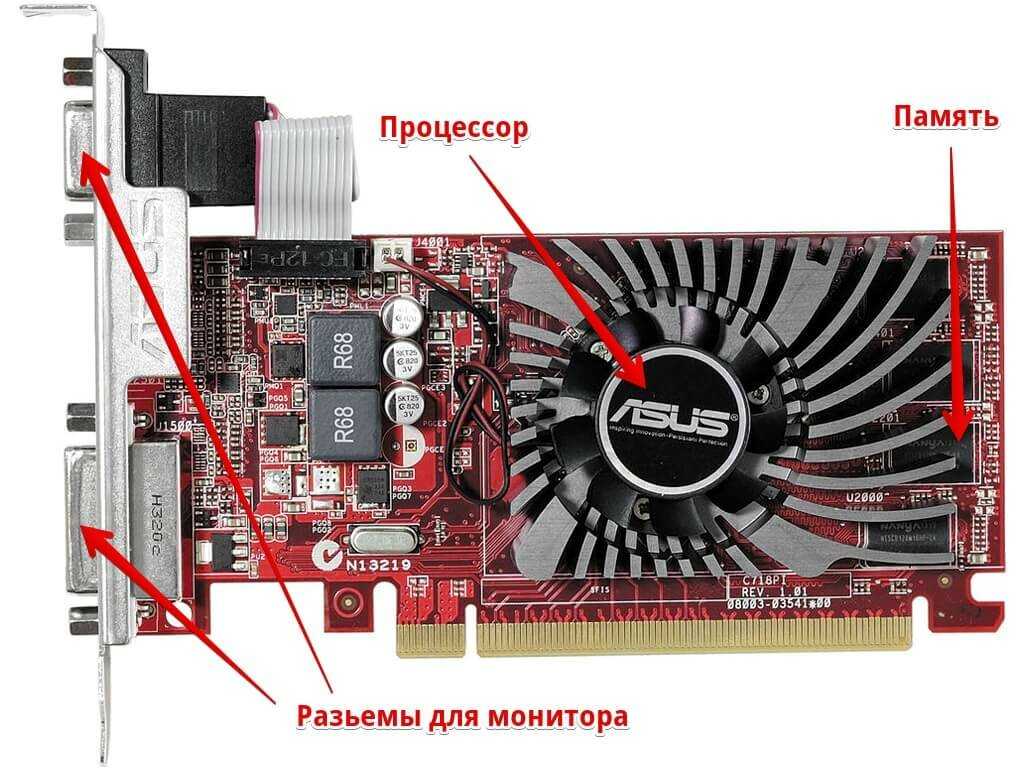

Дискретная видеокарта несёт на себе собственный графический процессор, видеопамять, систему охлаждения и преобразователь цифрового потока в реальный сигнал, который способен принять монитор. Дискретные видеокарты берут, чтобы нормально играть в игры или когда интегрированной видеокарты нет. Если вы не играете в игры, и всё общение с компьютером сводится к сёрфингу в интернете и работой с офисными приложениями, то вам не нужна отдельная видеокарта.

Самые известные производители видеокарт: NVidia и AMD. Для геймеров дискретная видеокарта обладает неоспоримыми преимуществами перед интегрированными решениями, это:

Для геймеров дискретная видеокарта обладает неоспоримыми преимуществами перед интегрированными решениями, это:

- высокая производительность в играх, зависит от модели

- более высокое качество картинки

- поддержка актуальных версий DirectX и OpenGL

- наличие нескольких интерфейсов для подключения двух и более мониторов

- возможность лёгкой модернизации, путём замены (не забудьте правильно удалить драйвер видеокарты)

- технологии NVidia CUDA и AMD STREAM позволяют использовать видеопроцессор для решения ресурсоёмких задач в помощь к основному процессору (GPU+CPU)

- используются для майнинга криптовалют

И конечно же недостатки:

- высокое энергопотребление

- шум вентилятора, если он есть

- большой нагрев и перегрев, если охлаждение пассивное

- цена, даже бюджетного видеоадаптера, может сравняться с ценой материнской платы

- дополнительное место в системном блоке

USB видеокарта для ноутбуков

Когда в ноутбуке сгорает видеокарта, то дешевле заменить её на видеокарту с USB-подключением, чем менять или ремонтировать материнскую плату. Также подходит, когда нужно подключить ещё один монитор.

Также подходит, когда нужно подключить ещё один монитор.

Из преимуществ у ЮСБ-видеокарты — только лёгкая установка. Для игр она не подходит, т.к. у интерфейса USB очень низкая скорость для таких задач, но с офисными задачами справится. Кстати, вы легко можете узнать какая видеокарта установлена на вашем компьютере.

Посмотрите видео по теме:

Посмотреть это видео на YouTube

Как выбрать видеокарту для игрового ПК — HYPERPC на DTF

Коротко ответить не получится, ведь видеокарта — это, по сути, специализированный компьютер, который на основе данных от центрального процессора в реальном времени строит картинку, которую вы видите на экране. На то, как он справляется с этой задачей, влияет множество характеристик.

1602 просмотров

Если вы знаете, как обозначаются поколения карт GeForce и Radeon, чем технология DLSS отличается от FSR и что такое «бутылочное горлышко» в контексте взаимодействия процессора и видеочипа, то переходите сразу к разделу «Критерии выбора» (впрочем, зачем вам тогда статьи об этом?)

Для тех же, кому интересно разобраться и узнать больше, мы начнём «от печки» и расскажем, какие технические характеристики указаны прямо в названии видеокарты.

Если вы не поняли шутку, это хорошо — значит, мы делали эту статью именно для вас. Попробуйте ещё раз, когда дочитаете 😉

Что скрывает название

Для примера возьмем видеокарты с высоким рейтингом на Яндекс.Маркете — GIGABYTE GeForce RTX 3070 Ti GAMING OC 8G и MSI Radeon RX 6700 XT MECH 2X 12G.

В этой табличке мы просто разделили названия на отдельные параметры, чтобы их было удобнее рассматривать каждый более подробно.

Производитель

Главный компонент видеокарты — графический процессор, или видеочип. Если вам нужна карта, которая работает с трёхмерной графикой и подходит для игр, выбирать придётся из двух брендов, которые разрабатывают видеочипы: Nvidia и AMD. Уже несколько десятков лет «зелёные» и «красные» соревнуются между собой, а пользователи поддерживают это противостояние неутихающим холиваром (кстати, если у вас есть убеждения на этот счёт, расскажите о них в комментариях 😉)

Пока то один, то другой производитель выпускает очередную модель, потребитель выигрывает — флагманы стоят дорого, но автоматически снижают цены на предыдущие модели.

И NVIDIA, и AMD выпускают видеокарты под своими брендами, но их основная задача — спроектировать графический процессор, а производство они делегируют партнёрам, например, таким промышленным гигантам как Samsung и TMSC.

Сборка готовых видеокарт чаще всего происходит уже под другими брендами. Хорошо зарекомендовали себя видеокарты от Gygabyte, MSI, Asus, Palit. Обычно именно эти компании выпускают карты топового уровня. Другие — Zotac, Powercolor — насыщают рынок более доступными решениями.

Семейство

В зависимости от основной задачи видеокарты объединяются в семейства.

Например, такие семейства NVIDIA как TITAN, Quadro, Tesla, NVS, предназначены для специальных задач вроде быстрых и мощных математических вычислений. В семейство GeForce «зелёные» включают устройства и для игровых, и для бытовых, и для мобильных компьютеров. К нему относится большая часть видеокарт с чипом, разработанным NVIDIA.

Индекс процессора

Индекс видеокарт с чипом NVIDIA расшифровывается так:

· GT – это простые видеокарты для повседневной работы, которые не могут похвастаться поддержкой передовых технологий.

· GTX – видеокарты, которые ставят в основном для работы с фото и видео. Новые игры на них не «взлетят», а в старые поиграть можно.

·RTX – карты, которые подходят для современных игр и профессионального видеомонтажа или рендеринга. Им по плечу быстрая отрисовка сложного изображения в высоком разрешении со всеми примамбасами типа трассировки лучей и сглаживания.

У семейства Radeon от AMD свои индексы:

· R – обычная карта для повседневных задач, например, кино посмотреть или в интернете посёрфить;

· RX – игровая и графическая серия.

Поколение и модель

Каждое последующее поколение мощнее предыдущего за счёт применения новых технологий. Как правило, постепенные эволюционные изменения происходят почти каждый год, а раз в 3—6 лет производители создают революционные, качественно новые решения, которые будут оставаться актуальными до следующего технологического скачка.

Номер поколения увеличивается последовательно. У карты NVIDIA GeForce RTX 3070 его обозначают первые две цифры, 30, у Radeon RX 6700 — одна первая цифра, а номер поколения будет 6000.

Остальные цифры — это модель. Чем больше число, тем выше производительность. У «зелёных» в каждом поколении девяностая серия — самая мощная. «Красные» используют аналогичный принцип, только маркировка модели — трёхзначная. Она отличается от поколения к поколению, поэтому просто скажем, что у тех моделей, которые достаточно производительны для игр, номер больше 500.

Суффикс производительности

Следующим идёт суффикс производительности. Если он есть, это специализированная видеокарта, которая лучше справляется с особыми задачами. Чаще всего геймерам стоит обращать внимание именно на такие устройства.

Если он есть, это специализированная видеокарта, которая лучше справляется с особыми задачами. Чаще всего геймерам стоит обращать внимание именно на такие устройства.

В случае с NVIDIA суффикс Ti (от Titan) обозначает, что перед нами более мощная карта по сравнению с «собратом» аналогичного поколения и модели. Аналогично обозначают экстремально производительные карты и AMD, но у них для этого есть два суффикса: XT (eXTreme) и XTX, в порядке возрастания мощности их лапищ.

Конструктивные особенности

В этой части названия может быть добавлено несколько нюансов.

Для приведённой карты «зелёных» слово GAMING в расшифровке не нуждается, а суффикс OC обозначает Overclocking — разгон: в конструкцию этой карты производитель заложил возможность ещё больше увеличить её производительность. У видеокарты с такой маркировкой будет более продвинутая конструкция охлаждения.

У «красной» видеокарты, которую мы взяли для примера, обозначение MECH 2X говорит о том, что она имеет меньшие размеры, чем другие карты той же модели. Мощные видеокарты часто занимают несколько слотов в корпусе, поэтому меньший размер позволяет и место сэкономить, и при необходимости поставить вторую карту.

Мощные видеокарты часто занимают несколько слотов в корпусе, поэтому меньший размер позволяет и место сэкономить, и при необходимости поставить вторую карту.

У некоторых производителей встречаются специальные обозначения количества вентиляторов, наличия подсветки и других деталей. Пытаться разобраться в них всех нет особого смысла, достаточно понимать, какого рода информация может быть с этой части названия и гуглить, если у интересующей вас карты там написано что-то необычное.

Объем видеопамяти

В первую очередь, к памяти требовательны текстуры с высоким разрешением и эффекты, которые нужно быстро просчитывать, вроде сложного освещения, тумана или следов на снегу.

Этот параметр обычно вызывает самые жаркие споры. С одной стороны, чем больше памяти, тем, кажется, лучше. С другой — если в максимальных требованиях игры указано меньше гигабайт, чем у видеокарты, то «лишний» объём окажется бесполезным.

Помимо требований игр, есть ещё один важный фактор, от которого нужно отталкиваться, решая, какой объём памяти вам нужен: разрешение дисплея. Другими словами, то, сколько пикселей будет содержать кадр. Сейчас стандарт — FullHD, но появляется всё больше игр с разрешением 4К и даже 8К. А если мониторов ещё и два…

Другими словами, то, сколько пикселей будет содержать кадр. Сейчас стандарт — FullHD, но появляется всё больше игр с разрешением 4К и даже 8К. А если мониторов ещё и два…

Для FullHD, то есть дисплея с разрешением 1980 на 1080 точек, 4—6 гигабайт памяти будет «впритык» для хорошего FPS. Лучше — 8 гигабайт. Если монитор тащит разрешение 4К (в 4 раза больше), присмотритесь к видеокарте с 24 гигабайтами памяти на борту.

Кстати, в отличие от оперативки, видеопамять нельзя нарастить, то есть если потребности вырастут, придётся покупать новую карту. Давайте будем реалистами — они обязательно вырастут… так что, возможно, стоит рассчитывать объём памяти «про запас».

От чего зависит производительность

Производительность видеокарты зависит от огромного количества параметров: количества ядер, частоты графического процессора, объема памяти, шины и многого другого. Рассматривать их по отдельности нет смысла, но одновременно учесть всё сложно.

Удобнее всего оценивать производительность карты с помощью бенчмаркинга — тестирования, которое позволяет оценить, как устройство справляется с теми или иными задачами. Как вариант, можно воспользоваться сервисом UserBenchmark. Он собирает результаты тестов видеокарт, анализирует и выдаёт среднее значение. Можно ориентироваться на это, а можно — на пользовательский рейтинг в том же сервисе.

Как вариант, можно воспользоваться сервисом UserBenchmark. Он собирает результаты тестов видеокарт, анализирует и выдаёт среднее значение. Можно ориентироваться на это, а можно — на пользовательский рейтинг в том же сервисе.

В результатах бенчмаркинга заинтересовавшей вас карты в первую очередь обращайте внимание на FPS. Чем он выше, тем картинка будет более плавной, без рывков. Рекомендуемое значение для современных игр — 60 FPS и выше.

Как взаимосвязаны процессор и видеокарта

Процессор «скармливает» видеокарте данные, нужные для рендеринга, видеокарта просчитывает изображение и выводит его на экран. Чтобы картинка получилась плавной и приятной для глаза, этот процесс должен быть очень быстрым: для 30 FPS вся цепочка операций должна быть выполнена примерно за 33 миллисекунды.

Центральный процессор в начале кадра производит расчёты и отправляет графическому процессору, который на их основе рендерит следующий кадр. Если ЦП в какой-то момент слишком долго создаёт команду рендеринга, то графический процессор начнёт работать с запозданием, и в нужный момент новый кадр окажется не готов. В результате FPS упадёт, а на экране появится мерцание или зависание.

В результате FPS упадёт, а на экране появится мерцание или зависание.

Процессор отвечает за такие составляющие игрового процесса:

- отрисовка вершин 3D-моделей;

- поведение объектов при соприкосновении;

- траектория частиц вроде снега, брызг, пылинок, искр;

- расчёты числовых характеристик — скорости, расстояния, урона и так далее;

- поведение NPC.

Видеокарта занимается такими вычислениями:

- наложение текстур на 3D-модели;

- глобальное и локальное освещение;

- тени и затенения;

- дополнительная детализация объектов;

- эффекты постобработки — отражения, глубина резкости, фильтры;

- сглаживание.

Создатели игровых движков реализуют разные решения для улучшения совместной работы процессора и видеокарты и стабильной частоты кадров. Одни из них больше задействуют процессор, другие видеокарту, всё это может быть лучше или хуже сбалансировано, но общий принцип простой:

Одни из них больше задействуют процессор, другие видеокарту, всё это может быть лучше или хуже сбалансировано, но общий принцип простой:

мощная видеокарта не вытянет работу слабого процессора, и наоборот.

Даже если видеокарта, согласно тестам, способна обеспечить высокий FPS при 4k разрешении на ультра-настройках графики, она упрётся в возможности процессора. Бывает и наоборот — когда процессор мог бы многое, но упирается в потолок производительности видеокарты. Это явление называют «бутылочным горлышком».

Чтобы избежать его, нужно смотреть на работу процессора и видеокарты в связке. Для этого надо искать тесты совместимости или тестировать сборку в конфигураторе. Слава интернету, если ввести в поисковую строку YouTube названия процессора и видеокарты, чаще всего находится обзор того, как устройства будут работать вместе.

Ещё мы подготовили таблицу с оптимальными сочетаниями.

Какие технологии важны для реалистичности изображения

Качество изображения в играх постоянно растёт за счёт увеличения разрешения картинки с одной стороны и за счёт применения более совершенных визуальных эффектов с другой.

Здесь есть проблема, потому что именно эффекты больше всего нагружают графический процессор и уменьшают значение FPS. Это решается более совершенными технологиями рендеринга.

Трассировка лучей

Трассировка лучей — это метод рендеринга, при котором каждый луч света рассчитывается как отдельный объект, для которого можно просчитать движение и влияние на разные точки в пространстве. Для карт предыдущих поколений такая вычислительная нагрузка была почти непосильной. С современными видеокартами всё, что связано с освещением и отражениями, выходит на новый уровень реализма.

В картах NVIDIA с индексом RTX реализована аппаратная поддержка трассировки лучей, так что они справляются с ней если не играючи, то очень достойно. Здесь «зелёные» обходят «красных» конкурентов: поддерживающих эту технологию карт от AMD меньше.

Ролик от NVIDIA, который демонстрирует, как выглядит трассировка лучей в реальном времени на примере движка Northlight от Remedy Entertainment. На модернизированной версии этого движка делают Alan Wake 2

На модернизированной версии этого движка делают Alan Wake 2

Важно учитывать, что трассировка лучей реализуется в API, и пока игр, в которых улучшение картинки будет заметно с применением этой технологии, сравнительно немного — несколько десятков. В их числе, например, Icarus, God of War и нашумевшая Atomic Heart.

Масштабирование

Чтобы на экранах с разным разрешением картинка оставалась приятной, приходится искать способы её масштабировать без потери качества. Методы, которые обычно используются для видео, не подходят для 3D-игр: изображение получится нечетким.

Один вариант получить красивую картинку — наращивать мощность видеокарты и считать каждый пиксель «по-честному». Второй вариант — использовать сложную комбинацию аппаратно-программных методов рендеринга.

Видеокарты от NVIDIA, начиная с 2019 года, поддерживают технологию глубокого обучающегося суперсэмплирования, более известную как DLSS. Суть её в том, что видеочип часть своих ресурсов резервирует на машинное обучение, с помощью которого может дорисовать детали картинки при изменении размера и разрешения изображения.

DLSS работает только с картами «зелёных» и только с теми, которые имеют индекс RTX. Ещё одно ограничение — технология должна поддерживаться игровым движком. Сейчас списке около 250 игр, включая, например, Battlefield V, Fortnite, Final Fantasy XV.

«Красные» в долгу не остались и, пусть и задержавшись на год, представили свою технологию улучшения изображения — FSR (FidelityFX Super Resolution).

В отличие от конкурентов, AMD реализовали свою технологию, не меняя аппаратную часть, то есть улучшение изображения доступно даже на старых картах. Более того: FSR гораздо проще интегрируется в игровой движок, позволяя комфортно играть в те игры, которые раньше подтормаживали.

Ролик с наглядным сравнением DLSS, FSR и нативного изображения, когда разрешение исходника и устройства совпадают, на примере God of War

Если попытаться кратко сформулировать отличия технологий, получится, что DLSS может сделать изображение детальнее исходного, а FSR скорее удалит мелочи второго плана. Получается, DLSS предпочтительнее для неторопливых атмосферных проектов, где важна каждая подробность, а для динамичного геймплея больше подойдёт FSR.

Получается, DLSS предпочтительнее для неторопливых атмосферных проектов, где важна каждая подробность, а для динамичного геймплея больше подойдёт FSR.

Какие физические свойства карты нужно учитывать

До этого момента мы говорили о видеокарте словно об абстрактном устройстве, игнорируя тот факт, что это вполне реальная «железка» с конкретными физическими характеристиками.

Питание. Видеокарта — самый энергоемкий компонент компьютера. Чем выше её мощность, тем острее стоит этот вопрос. Современные видеокарты требуют блок питания минимум на 400 Вт, а некоторые сборки — на 1000—1200 Вт.

Разъёмы. Видеокарта работает в связке с монитором, поэтому нужно смотреть, разъёмы каких типов и в каком количестве она имеет. Ещё важно проверить, какие разъемы питания требует ваша видеокарта.

Охлаждение. И видеопроцессор, и видеопамять нуждаются в организации эффективного охлаждения, воздушного или жидкостного. Особенно остро этот вопрос стоит для тех устройств, которые планируется разгонять.

Размер и вес. Когда вы планируете свою сборку, важно учитывать размер устройства, потому что впихнуть в корпус «невпихуемое», увы, не получится. Чем больше разъёмов на видеокарте, тем больше становится её задняя панель. Система охлаждения тоже влияет на физические размеры карты.

Карта запросто может весить 2—3 килограмма, так что для того, чтобы со временем из-за её тяжести ничего не сломалось, понадобится специальная подставка или кронштейн.

Критерии выбора

Итак, соберём всё, о чём говорили выше и сформулируем критерии выбора игровой видеокарты.

Бюджет. С одной стороны, не стоит экономить на таком важном для игрового компьютера компоненте, с другой — нет смысла переплачивать за то, что не соответствует вашим потребностям или не добавит производительности.

Память. Исходите из общего разрешения используемых мониторов. Например, если играете на одном экране с FullHD, может хватить 6 или 8 Гб. Закладывайте запас примерно на 20%. Ясное дело, чем более нового поколения будет память, тем лучше. Самый современный вариант — GDDR6X.

Ясное дело, чем более нового поколения будет память, тем лучше. Самый современный вариант — GDDR6X.

Совместимость с процессором. Мощная карта сама по себе не обеспечит хорошую картинку: либо подбирайте её под имеющий процессор, либо рассматривайте его замену.

Совместимость с материнской платой. Скорость обмена данными будет на том уровне, какой обеспечивает материнская плата.

Физические характеристики. Сравните рекомендуемую производителем видеокарты мощность блока питания с мощностью вашего. Лучше, чтобы и здесь был небольшой запас.

Обратите внимание на коннекторы, по которым подается питание: есть ли они у вашего блока?

Прикиньте размеры карты, встанет ли она в ваш корпус, и можно ли будет добавить другие устройства при необходимости или желании.

Посмотрите на систему охлаждения: если вы используете СВО, выбирайте модели с поддержкой этой системы охлаждения.

Требования и возможности игр, которые вы предпочитаете. Покупать карту с поддержкой трассировки лучей для игры в CS:GO особого смысла не имеет. А вот для Battlefield V — более чем!

Покупать карту с поддержкой трассировки лучей для игры в CS:GO особого смысла не имеет. А вот для Battlefield V — более чем!

Вендор видеочипа и семейство. Это во многом религиозный вопрос, но всё же традиционно соотношение сторонников «зелёных» и «красных» оценивают как 5:1. «Красные» часто оказываются в положении догоняющих, но предлагают более доступные решения.

не всё так однозначно

Производитель карты. Продукция топовых компаний более надёжна и отличается вниманием к деталям, в частности, продумана система охлаждения и дополнительный разъём питания.

Индекс видеочипа. Здесь просто: для игр подойдут только видеокарты с индексами RTX или RX.

Поколение и модель. Последняя флагманская модель зачастую стоит неадекватно производительности, и можно взять вариант помладше.

Суффиксы. Тут тоже просто: у моделей, предназначенных именно для игр, в названии есть специальные отметки: у NVIDIA — Ti, а у AMD — XT или XTX. Кстати, у NVIDIA тоже были карты суффиксом XT, но это обозначение использовалось, наоборот, для удешевлённых и замедленных моделей.

Кстати, у NVIDIA тоже были карты суффиксом XT, но это обозначение использовалось, наоборот, для удешевлённых и замедленных моделей.

Конструктивные особенности. Если хотите иметь запас для разгона — ищите обозначение OC. Если пространство для установки в корпусе ограничено, выбирайте более компактные версии (MECH 2X).

Бонус для особо внимательных читателей

Вы дочитали статью до конца! Специально для таких внимательных читателей HYPERPC подготовил особый подарок: переходите на сайт и участвуйте в розыгрыше мощного игрового ПК

История видеокарт Nvidia

Компания Nvidia была основана в 1993 году, но только в 1995 году компания выпустила свой первый графический продукт — NV1.

С тех пор многое изменилось, и теперь мы избалованы трассировкой лучей, DLSS и другими замечательными технологиями, которые делают наши игровые возможности еще более приятными.

Мы оглядываемся на историю видеокарт Nvidia и на то, как эти устройства выглядели на протяжении многих лет.

Nvidia NV1

Swaaye/WikipediaNvidia NV1 была выпущена в 1995 году и могла обрабатывать как 2D, так и 3D видео. Он продавался как «Diamond Edge 3D» и даже имел порт для джойстика, совместимый с Sega Saturn.

Некоторые игры Sega Saturn были перенесены на ПК, включая Panzer Dragoon и Virtua Fighter Remix. Одних этих функций было недостаточно, чтобы привлечь рынок, поскольку Saturn изо всех сил пытался конкурировать с оригинальной PlayStation.

У NV1 был тяжелый старт, который усугубился выпуском Microsoft DirectX, который был несовместим с графическим процессором, и многие игры не запускались.

Nvidia RIVA 128

Матиас Табо/ВикипедияВ 1997 году Nvidia выпустила NV3, также известную как Riva 128, Riva расшифровывалась как «Интерактивное видео и анимация в реальном времени». Эта видеокарта использовала как 2D-, так и 3D-ускорение, а также наложение полигональных текстур.

В то время конкурент Nvidia, 3dfx, доминировал на рынке, но NV3 имел тактовую частоту ядра/памяти 100 МГц и, по существу, удвоил характеристики 3dfx Voodoo 1.

Было два варианта NV3: Riva 128 и Рива 128ZX. Последний был более мощным с 8 МБ видеопамяти и тактовой частотой 250 МГц.

NV3 оказался гораздо более успешным, чем первый GPU компании, и помог Nvidia завоевать широкую популярность.

Nvidia NV4

Tors/WikipediaВ 1998 году Nvidia выпустила NV4, также известную как Riva TNT. Эта видеокарта улучшена по сравнению с предыдущими моделями за счет поддержки 32-битного True Colour. NV4 также имел больше оперативной памяти с 16 МБ SDR SDRAM, что также означало более высокую производительность.

Примерно в это же время Nvidia начала предпринимать шаги по регулярному обновлению графических драйверов, чтобы обеспечить хорошую производительность и совместимость для конечного пользователя, чем компания занимается и по сей день.

Riva TNT от Nvidia в то время была более доступной, чем Vodoo2 от 3dfx, хотя и немного медленнее с точки зрения производительности. Поддержка драйверов была ключом к успеху NV4.

Nvidia NV5

Uwe Hermann/WikipediaВ 1999 году Nvidia последовала за NV4, выпустив RIVA TNT2. NV5, как она называлась, приобрела ряд обновлений, включая поддержку 32-битного Z-буфера/трафарета, до 32 МБ видеопамяти и поддержку текстур 2048 x 2048.

Что еще более важно, эта видеокарта имеет улучшенную тактовую частоту (до 150+ МГц), что дает прирост производительности на 17% по сравнению с предыдущей моделью.

Эта карта была прямым конкурентом 3dfx Voodoo3 и обе были невероятно популярны.

Nvidia GeForce 256

Hyins/WikipediaВ конце 1999 года Nvidia выпустила «первый в мире графический процессор» — Nvidia GeForce 256.

Это был умный маркетинговый ход со стороны Nvidia и начало любовь к графическим картам GeForce на долгие годы.

Он был улучшен по сравнению с предыдущими картами RIVA за счет увеличения пиксельных конвейеров, но также обеспечил значительный скачок в производительности для компьютерных игр.

Эта карта поддерживает до 64 МБ DDR SDRAM и работает на частоте до 166 МГц. Таким образом, он был на 50 процентов быстрее, чем NV5.

Таким образом, он был на 50 процентов быстрее, чем NV5.

Что еще более важно, GeForce 256 также полностью поддерживала Direct3D 7, что означало, что на нем можно было запускать многие из лучших игр для ПК, доступных в то время.

Вскоре после этого запуска 3dfx обанкротилась, и основным конкурентом Nvidia стала ATI.

Nvidia GeForce2

Hyins/WikipediaNvidia последовала за первым в мире графическим процессором с метко названным GeForce2.

Этот графический процессор выпускался в нескольких различных вариантах, включая модели Ti, Pro, GTS и Ultra. По сути это были карты NV11, 15 и 16. В выпусках 2000 и 2001 годов наблюдалось увеличение конвейеров и более высокая тактовая частота.

Что сделало GeForce2 интересным, так это начало поддержки мультимониторных установок.

Примерно в это же время Nvidia приобрела 3dfx.

Nvidia GeForce3

Hyins/Wikipedia Вскоре после GeForce2 появилась GeForce3. Эта серия видеокарт под кодовым названием NV20 представляла собой первые графические процессоры Nvidia, совместимые с DirectX 8.

Было три версии — GeForce3, GeForce3 Ti 200 и GeForce3 Ti 500. В этом следующем графическом процессоре GeForce были добавлены программируемые пиксельные и вершинные шейдеры, а также мультисэмпловое сглаживание.

Версия GeForce3, именуемая NV2A, использовалась в оригинальной консоли Xbox.

Серия Nvidia GeForce FX

Hyins/WikipediaСкачок вперед на пару поколений, и в 2003 году мы выпускаем серию Nvidia GeForce FX.

Это были видеокарты GeForce пятого поколения с поддержкой Direct3D 9.а также ряд новых технологий памяти. К ним относятся DDR2, GDDR2 и GDDR3, а также первая попытка Nvidia использовать шину данных памяти шире 128 бит.

Между тем, GeForce FX 5800 произвела фурор, став первым графическим процессором, оснащенным большим кулером. Один такой большой, что его часто называли «пылесборником» из-за большого количества шума вентилятора.

Серия Nvidia GeForce 6

Hyins/Wikipedia Вскоре после выпуска серии GeForce FX появилась серия 6 (она же NV40). GeForce 6 стала началом продвижения Nvidia технологии SLI, позволяющей людям комбинировать более одной видеокарты для большей мощности.

GeForce 6 стала началом продвижения Nvidia технологии SLI, позволяющей людям комбинировать более одной видеокарты для большей мощности.

Флагманом этой линейки была GeForce 6800 Ultra, видеокарта с 222 миллионами транзисторов, 16-пиксельными суперскалярными конвейерами и шестью вершинными шейдерами. Он имел поддержку Shader Model 3.0 и был совместим как с Microsoft DirectX 9.0c, так и с OpenGL 2.0.

В этой серии также использовалась технология Nvidia PureVideo, и она могла декодировать видео H.264, VC-1, WMV и MPEG-2 с меньшим использованием ЦП.

В результате всего этого серия GeForce 6 стала очень успешной.

Серия Nvidia GeForce7

FxJ/WikipediaВ 2005 году вышла серия GeForce7, включая 7800 GTX.

Одна только эта карта была настоящей электростанцией для того времени, и благодаря умному охлаждению Nvidia смогла увеличить тактовую частоту до 550 МГц. При этом компании также удалось уменьшить латентность и увеличить шину до 512 бит.

Интересно, что версия серии 7 была разработана как синтезатор реальности RSX, который был проприетарным процессором, созданным совместно Nvidia и Sony для PlayStation 3.

Серия Nvidia GeForce8

Shooke/WikipediaВ 2006 году Nvidia выпустила серию GeForce8 и представила свою микроархитектуру Tesla. Это был первый унифицированный дизайн шейдеров компании, и он также станет одной из наиболее часто используемых архитектур в будущих картах.

Популярная Nvidia GeForce 8800 GTX была флагманом линейки и пользовалась невероятной популярностью. Он имел 681 миллион транзисторов, 768 МБ памяти GDDR3 и 128 шейдеров с тактовой частотой 575 МГц.

Наиболее важно то, что эта видеокарта могла запускать Crysis, а это было всем, чего хотели компьютерные геймеры в то время.

В 2006 году ситуация также накалялась, когда AMD купила ATI за 5,4 миллиарда долларов и стала занозой в боку Nvidia на долгие годы.

Серия Nvidia GeForce9

Sk/WikipediaВ начале 2008 года Nvidia выпустила серию GeForce9. Эти карты продолжали использовать архитектуру Tesla, но также добавили поддержку PCIe 2.0, улучшенный цвет и z-сжатие.

К этому времени Nvidia подняла производительность на ступеньку выше, тактовая частота достигла 675 МГц, при этом энергопотребление также снизилось.

Серия Nvidia GeForce 400

AmazonСледующее значительное обновление произошло в 2010 году, когда Nvidia выпустила серию GeForce 4000. Именно тогда Nvidia представила микроархитектуру Fermi, которая стала следующей крупной архитектурой компании.

Эта серия также имела поддержку OpenGL 4.0 и Direct3D 11 и была прямым конкурентом серии Radeon HD 5000.

Однако серию подвели высокие рабочие температуры и энергопотребление, что вызвало много недовольства пользователей.

Серия Nvidia GeForce 600

HanyNARСерия GeForce 600 представила архитектуру Nvidia Kepler, которая была разработана для увеличения производительности на ватт, а также улучшения производительности предыдущей микроархитектуры Fermi.

С помощью Kepler Nvidia удалось увеличить тактовую частоту памяти до 6 ГГц. Он также добавил GPU Boost, который гарантировал, что GPU сможет работать на минимальной тактовой частоте, а также повышать производительность при необходимости, пока не будет достигнуто заранее определенное целевое значение мощности.

Этот диапазон также поддерживал как Direct3D 11, так и Direct3D 12. Он также представил новый метод сглаживания, известный как TXAA.

Серия Nvidia GeForce 700

Маркус БернсВ 2013 году Nvidia подняла ситуацию на новый уровень, выпустив серию 700, которая была дополнена безумной высококлассной картой GTX Titan для энтузиастов.

Эта серия была обновлением микроархитектуры Kepler, но некоторые более поздние карты также имели архитектуры Femi и Maxwell.

GTX Titan может похвастаться 2688 ядрами CUDA, 224 TMU и 6 ГБ оперативной памяти. К этому времени Nvidia удалось втиснуть в свои графические процессоры целых семь миллиардов транзисторов.

Серия GeForce 700 была разработана для обеспечения максимальной энергоэффективности, но также включала другие функции, такие как аппаратное кодирование H.264, интерфейс PCI Express 3.0, поддержку DisplayPort 1.2 и HDMI 1.4a 4K x 2K для вывода видео, а также GPU-Boost 2.0. .

Серия Nvidia GeForce 900

Маркус Бернс В 2014 году Nvidia, казалось бы, пропустила поколение и сразу приступила к серии GeForce 900. Это было введение в микроархитектуру Maxwell, которая предлагала улучшенные графические возможности, а также лучшую энергоэффективность.

Это было введение в микроархитектуру Maxwell, которая предлагала улучшенные графические возможности, а также лучшую энергоэффективность.

Изначально флагманом этой серии была GeForce GTX 980, за которой позже последовали 980 Ti и GeForce GTX TITAN X в самом конце.

Для этой серии также был улучшен NVENC и появилась поддержка Direct3D 12_1, OpenGL 4.6, OpenCL 3.0 и Vulkan 1.3.

Серия Nvidia GeForce10

Маркус БернсВ 2014 году Nvidia представила серию GeForce10, основанную на микроархитектуре Pascal. GTX 1080 Ti, пожалуй, самый известный из графических процессоров этой серии и закрепил за собой историю как, пожалуй, одна из самых значительных карт, выпущенных Nvidia.

Эта графическая карта доминировала на рынке и предлагала такую превосходную производительность и энергоэффективность по сравнению с ценой, что ее часто будут упоминать при сравнении с будущими графическими процессорами.

Серия 10 также включает новые функции, такие как GPU Boost 3. 0, система планирования динамической балансировки нагрузки, тройная буферизация и поддержка DisplayPort 1.4 и HDMI 2.0b.

0, система планирования динамической балансировки нагрузки, тройная буферизация и поддержка DisplayPort 1.4 и HDMI 2.0b.

Серия Nvidia GeForce20

Маркус БернсСерия GeForce 20 была выпущена в 2018 году и представила миру микроархитектуру Turing.

Примечательно, что эти видеокарты были картами RTX первого поколения, и Nvidia продвигала трассировку лучей в качестве основного преимущества.

Использование тензорных ядер и других усовершенствований помогло этим картам совершить огромный скачок в графическом совершенстве. Результатом является реалистичное освещение и убедительные эффекты отражения в игре.

Однако за улучшения пришлось заплатить: RTX 2080 Ti продавалась по невероятной цене 1199 долларов (по сравнению с 699 долларов за 1080 Ti).

Nvidia GeForce30 серии

Pocket-lint Серия GeForce30 пришла на смену серии 20 в 2020 году и, к сожалению, стала наиболее известной из-за того, что ее было просто невозможно достать из-за нехватки силикона.

Тем не менее, Nvidia RTX 3080 должна была продаваться по цене 699 долларов, что делало ее намного более доступной, чем флагманы предыдущих поколений, и серия также получила значительные улучшения.

Флагманская видеокарта GeForce RTX 3090 Ti, анонсированная в марте 2022 года, содержит 10 752 ядра CUDA, 78 RT-TFLOP, 40 Shader-TFLOP и 320 Tensor-TFLOP мощности. Этот мощный зверь также был отмечен как энергоемкий, требующий не менее 850 Вт мощности, а это означает, что для его работы вам, вероятно, понадобится блок питания мощностью 1000 Вт.

Nvidia GeForce 40-й серии

NvidiaNvidia постоянно пытается раздвинуть границы с каждой итерацией. С RTX 40-й серии один пользователь доказал, что можно запускать игры с разрешением 13K.

Это была первая серия графических процессоров, в которой использовался разъем 12VHPWR, что приводило к некоторым проблемам, но в остальном в основном имело восторженные отзывы.

Флагманская карта этого диапазона, RTX 4090, имела 24 ГБ памяти GDDR6X, 16384 ядра Cuda и неплохую вычислительную мощность. С этими картами Nvidia также представила DLSS 3.9.0003

С этими картами Nvidia также представила DLSS 3.9.0003

Как сбросить настройки видеокарты в Windows

Ваш ПК с Windows испытывает трудности с приложениями и играми, интенсивно использующими графику? Возможно, вам потребуется сбросить настройки видеокарты в Windows. Это руководство объяснит, как это сделать.

Графическая карта вашего компьютера или графический процессор — это основной компонент вашего ПК, загружающий содержимое на ваш дисплей и обрабатывающий графическую нагрузку от игр и других приложений, интенсивно использующих графический процессор. Являетесь ли вы хардкорным геймером, художником-графиком или обычным пользователем, которому нужно видео в HD-качестве, видеокарта должна работать должным образом.

Однако бывают случаи, когда видеокарта не работает должным образом. Например, вы можете получить ошибку 43, ошибку BSOD или Windows может просто зависнуть, потому что ваш графический процессор не справляется с нагрузкой.

В этом случае вам может понадобиться узнать, как сбросить настройки видеокарты в Windows 11 или 10.

Как сбросить настройки видеокарты в Windows

попробуйте сначала перезагрузить. Вместо перезагрузки системы вы можете использовать следующую комбинацию клавиш, чтобы перезапустить только графический процессор.

Чтобы перезагрузить видеокарту, нажмите комбинацию клавиш Windows + Ctrl + Shift + B на клавиатуре.

Ваш экран ненадолго станет черным, и вы услышите звуковой сигнал. После того, как карта завершит процесс перезагрузки, ваш интерфейс Windows снова появится в обычном режиме. Ни одно из ваших приложений не закроется, и вы не потеряете несохраненные данные.

Тем не менее, перед выполнением каких-либо действий по обслуживанию или устранению неполадок на компьютере всегда необходимо сохранять данные. Также важно отметить, что это будет работать с любой имеющейся у вас видеокартой, будь то NVIDIA, AMD, Intel и т. д.

Как отключить и включить графическую карту в Windows

Другой способ перезапустить графическую карту в Windows — отключить и снова включить графические драйверы.

Чтобы снова включить видеокарту в Windows:

- Откройте меню «Пуск» .

- Введите Диспетчер устройств и выберите верхний элемент в списке.

- Когда запустится Диспетчер устройств , прокрутите вниз и разверните раздел Видеоадаптеры .

- Щелкните правой кнопкой мыши графическую карту и выберите Удалить устройство в появившемся меню.

- Когда процесс удаления завершится, убедитесь, что все важные данные сохранены, и перезагрузите компьютер.

- Драйвер видеокарты будет переустановлен при перезагрузке ПК.

Сброс графической карты или графического процессора

Вы можете использовать термины графического процессора и графической карты взаимозаменяемо. Например, это относится к устройству, которое выполняет графические вычисления, чтобы ЦП мог обрабатывать все остальное. Даже если у вас в ноутбуке дискретная видеокарта (впаяна на материнскую плату), она может зависнуть.