ТОЛ-35 трансформаторы тока опорные. Описание. Цена. Заказ.

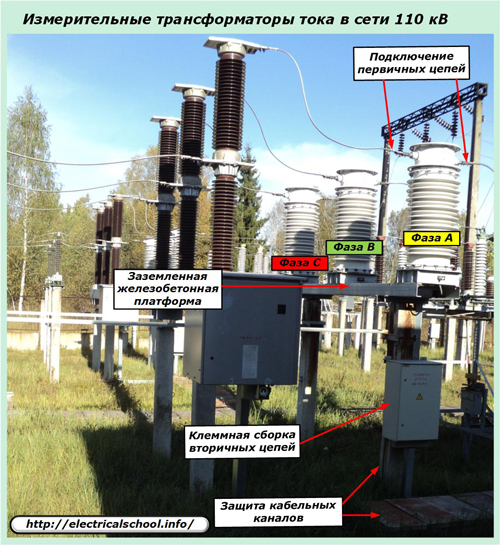

Трансформаторы ТОЛ-35-III-II, ТОЛ-35-III-III, ТОЛ-35-III-V и ТОЛ-35-III-7.2 устанавливаются в открытых распределительных устройствах (ОРУ) класса напряжения 35 кВ.

Является аналогом трансформатора напряжения ТГМ-35.

Трансформаторы тока ТОЛ-35 предназначены для передачи сигнала измерительной информации измерительным приборам, устройствам защиты, автоматики, сигнализации и управления, а также для изолирования цепей вторичных соединений от высокого напряжения в электрических цепях переменного тока частотой 50 Гц.

Измерительные трансформаторы серии ТОЛ-35 имеют климатическое исполнение УХЛ1 и работают в следующих условиях:

- Высота установки над уровнем моря — не более 1000 м.

- Температура окружающего воздуха при эксплуатации:-60…+50°С.

- Окружающая среда невзрывоопасная, не содержащая пыли, агрессивных газов и паров в концентрациях, разрушающих покрытия, металлы и изоляцию.

Технические характеристики

Наименование параметра | Значение для конструктивного исполнения ТОЛ-35 | |||||||||

III-II; | III-III; | III-V-4; | III-V-5; | III-7.2 | ||||||

Номинальное напряжение, кВ | 35 | |||||||||

Наибольшее рабочее напряжение, кВ | 40,5 | |||||||||

Номинальная частота переменного тока, Гц | 50 | |||||||||

Количество вторичных обмоток: | ||||||||||

— для измерений | 1 | 1 | или | 2 | 2 | 1; 2; 3 или 4 | ||||

— для защиты | 2 | 3 | 2 | 3 | 1; 2 или 3 | |||||

Класс точности вторичных обмоток | ||||||||||

— для измерений | 0,2S; 0,2; 0,5S; 0,5 | |||||||||

— для защиты | 5Р; 10Р | |||||||||

Номинальный вторичный ток, А | 1 или 5 | |||||||||

Номинальная вторичная нагрузка вторичных обмоток с индуктивно-активным коэффициентом мощности cos φ=0,8, В∙А | ||||||||||

— для измерений | 30 | 15 | 3; 5; 10; 15 | |||||||

— для защиты | 30 | 50 | 30 | 20 | 3; 5; 10; 15; 20; 25; 30 | |||||

Номинальная предельная кратность вторичной обмотки для защиты, не менее | 20 | 10 | ||||||||

Номинальный коэффициент безопасности приборов вторичной обмотки для измерений, не более, при номинальном первичном токе, А: | 6 | |||||||||

15 — 1500 | 5; 6* | 6 | ||||||||

2000 | 5 | 7 | ||||||||

3000 | — | 5 | ||||||||

4000 | 5 | — | 5 | |||||||

*Для трансформаторов тока ТОЛ-35 III-II на первичные токи 15, 20, 30, 40, 50, 75, 100, 150, 200, 300 и 600 А классов точности 0,2S.

Количество вторичных обмоток, классы точности, значения номинальных вторичных нагрузок, номинального вторичного тока, номинальной предельной кратности вторичной обмотки для защиты и номинального коэффициента безопасности приборов вторичной обмотки для измерений уточняются в заказе.

Стандартный комплект поставки

- ТОЛ-35 трансформатор тока опорные.

- Паспорт.

2.5.3 Выбор трансформаторов тока в ячейке ору

2.5.3.1 Выбираем трансформатор тока ТФНД-110М

2.5.3.2 Определяем номинальный ток данного трансформатора

Iном = 600 А, [6], таблица 31.10, стр. 204

2.5.3.3 Определяем номинальное напряжение и напряжение установки данного трансформатора

Uном = 110 кВ, [6], таблица 31.10, стр. 204

Uуст = 110 кВ

2.5.3.4 Определяем ток динамического действия и ток ударный

iдин =

90 кА,

[6], таблица 31. 10, стр. 204

10, стр. 204

iу = 31,11 кА

2.5.3.5 Определяем расчетный предельный ток термической стойкости

(2.5.4)

2.5.2.6 Сводим данные расчета в таблицу 2.5.3 для сравнения

Таблица 2.5.3

Расчетные данные | Каталожные данные |

Iрас = 183,7 А < | Iном = 1000 А |

Uуст = 110 кВ = | Uном = 110 кВ |

iу = 31,11 кА < | iдин = 90 кА |

It=3 = 2,9 кА < | It=3 = 26 кА |

Так

как расчетные данные не превышают

каталожные, то трансформатор тока выбран

верно.

ТФНД-110М – трансформатор тока для наружной установки с фарфоровой изоляцией, модернизированный, с сердечником для дифференциальной защиты, с номинальным напряжением 110 кВ.

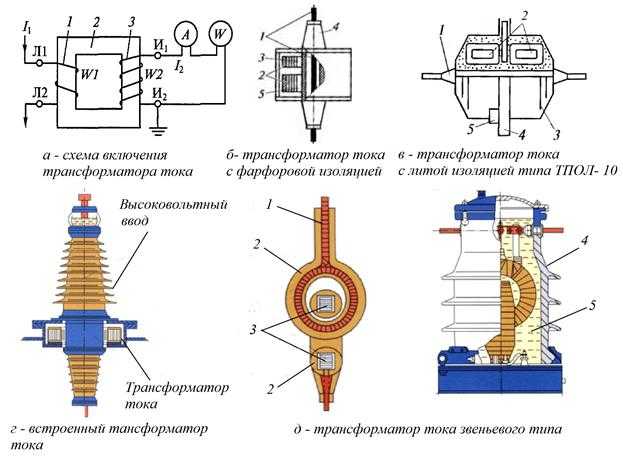

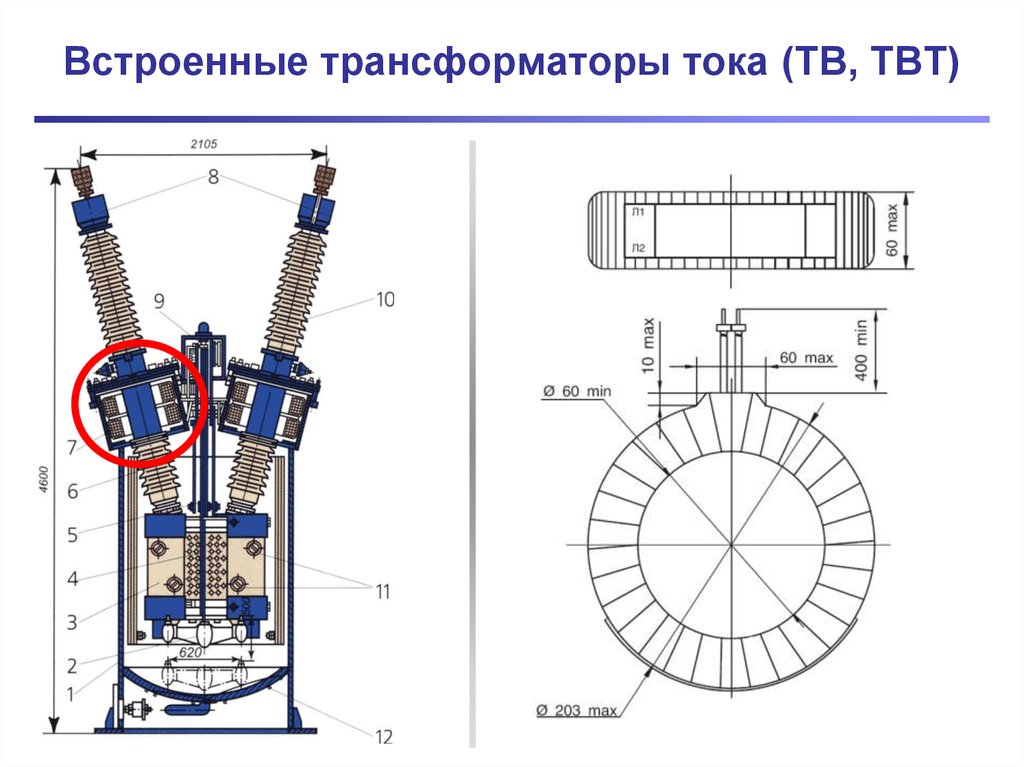

Трансформатор тока типа ТФН

Рисунок 2.5.3

Трансформаторы тока для наружных установок имеют бумажно-масляную изоляцию. Для обеспечения необходимого уровня изоляции все части, магнитопровод и обмотки трансформатора погружают в фарфоровый корпус 6, который заполнен трансформаторным маслом. Конструктивно первичная 3 и вторичная 7 обмотки напоминают два звена цепи. Выводы первичной обмотки

2.5.4.1 Выбираем трансформатор напряжения НКФ-110-58У1

2.5. 4.2

Проверяем выбранный трансформатор по

условию

4.2

Проверяем выбранный трансформатор по

условию

U

(2.5.5)

уст ≤ Uном

110 кВ = 110 кВ

Так как условие выполняется, то трансформатор выбран верно.

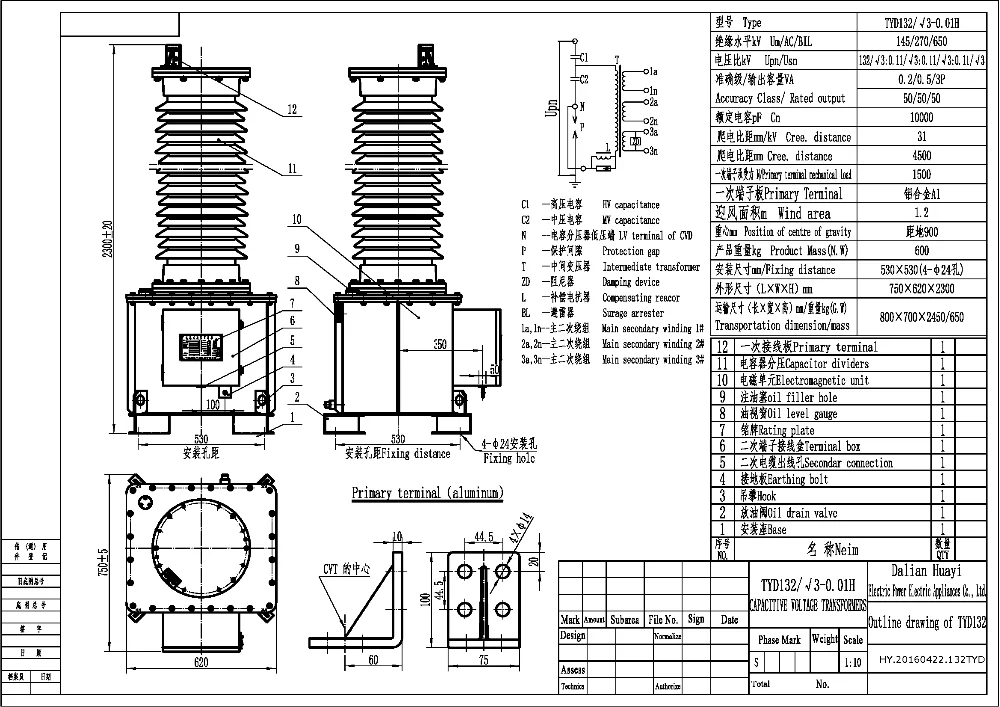

Масляные каскадные трансформаторы напряжения НКФ-110 состоят из одного блока (рис. 2.5.4).

Блок

состоит из стержневого магнитопровода

с двумя обмоточными стержнями. Первичная

обмотка (ВН) равномерно распределена

по всему стержню магнитопровода. Обе

вторичные обмотки (НН) – основная и

дополнительная расположены на нижнем

стержне нижнего магнитопровода,

имеющего наименьший потенциал по

отношению к земле (один конец первичной

обмотки заземляется).

Магнитопроводы шихтованные, собраны из пластин электротехнической стали марки Э320 или Э330. Пластины изолированы лаковой пленкой.

Обмотки слоевые, намотаны круглым или прямоугольным обмоточным проводом на бакелитовых цилиндрах. Сначала намотана первичная обмотка и на нее электростатический экран. Вторичные обмотки намотаны поверх электростатического экрана.

Блок состоит из активной части (магнитопровода с обмотками), установленной на основании. На активную часть надета фарфоровая покрышка, наполненная трансформаторным маслом и закрытая маслорасширителем.

Линейный конец обмотки ВН находится на крышке маслорасширителя, а заземляемый конец и концы вторичных обмоток подведены к доске зажимов, расположенной в коробке внутри нижнего основания.

Трансформатор напряжения НКФ-110-58

Рисунок 2.5.4

Elettronica Lucense Electromechanics Archives — Страница 5 из 8

Поиск:

Показано 97–120 из 186 результатов

Сортировка по умолчаниюСортировать по популярностиСортировать по новизнеСортировать по цене: от низкой к высокойСортировать по цене: от высокой к низкой

SIRIO 150155-0223 ТРАНСФОРМАТОР ТОКА TA 800/04

Цена: 34,16 € с учетом НДС В корзинуСделать предложениеFACON FAC-1847003301 ЭЛЕКТРОЛИТИЧЕСКИЙ КОНДЕНСАТОР 3300 мкФ 450 В постоянного тока -40+85°C

Цена: 30,50 € с учетом НДС В корзинуСделать предложениеFRER FR-AT63 ТРАНСФОРМАТОР ТОКА ТИПА AT63 1000/5A KV0.

72-3 HZ40-60 Цена: 30,00 € с учетом НДС В корзинуСделать предложение

72-3 HZ40-60 Цена: 30,00 € с учетом НДС В корзинуСделать предложениеOMRON D4B-117IN ПЕРЕКЛЮЧАТЕЛЬ

Цена: 29,00 € с учетом НДС В корзинуСделать предложениеESAM-UNICENTER E04A-150A ТРАНСФОРМАТОР ТОКА ТИПА E04A-150/1A KV0,72-3 Гц 40-60

Цена: 27,00 € с учетом НДС В корзинуСделать предложениеFRER FR-AC51 ТРАНСФОРМАТОР ТОКА ТИПА AC51 600/1A KV 0,72-3 HZ40-60

Цена: 27,00 € с учетом НДС В корзинуСделать предложение- Распродажа!

S-L-C-E 039-SP ЭЛЕКТРОЛИТИЧЕСКИЙ КОНДЕНСАТОР 2200 мкФ 400 В постоянного тока 7,9 А 85°

Цена :31,96€/26,84€ С НДС В корзинуСделать предложение - Распродажа!

ITELCOND AYX-HR ЭЛЕКТРОЛИТИЧЕСКИЙ КОНДЕНСАТОР 2200 мкФ 450 В постоянного тока 9929

Цена :31,96€/26,84€ С НДС В корзинуСделать предложение ESAM-UNICENTER E015S-8005A ТРАНСФОРМАТОР ТОКА ТИПА E015S-800/5A KV0,72/3 HZ40/60 БАР ПРОХОД 80X10

Цена: 26,84 € с учетом НДС В корзинуСделать предложениеGHISALBA GHT-130 ТАЙМЕР 110-127В 50Гц 12МИН.

Цена: 26,60 € с учетом НДС В корзинуСделать предложение

Цена: 26,60 € с учетом НДС В корзинуСделать предложениеESAM-UNICENTER E04A-100A ТРАНСФОРМАТОР ТОКА ТИПА E04A-100/1A KV 0,72/3 HZ50-60

Цена: 26,00 € с учетом НДС В корзинуСделать предложениеАББ Н003650500х2 ТРАНСФОРМАТОРЫ ТОКА ТИПА H&B-603 50-60Гц 0,6/3кВт 500-5А

Цена: 25,00 € с учетом НДС В корзинуСделать предложениеSIRIO 151008-0109 ТРАНСФОРМАТОР ТОКА TA 200/0,2A 400/0,4A

Цена: 24,40 € с учетом НДС В корзинуСделать предложениеTELEMECANIQUE TELKNA03SF4 СОЕДИНИТЕЛЬНАЯ КОРОБКА CANALIS KN

Цена: 24,40 € с учетом НДС В корзинуСделать предложениеFEDI-FERNANDO COD-50-01A ТРАНСФОРМАТОР ТОКА TA 50/0.1A

Цена: 24,40 € с учетом НДС В корзинуСделать предложениеWEIDMULLER WEI-1028700000-WFF-300 БОЛТОВЫЕ ВИНТОВЫЕ КЛЕММЫ СЕРИИ W, ПРОХОДНАЯ КЛЕММА, НОМИНАЛЬНОЕ СЕЧЕНИЕ: 300 ММ², РЕЗЬБОВОЕ СОЕДИНЕНИЕ

Цена: 23,70 € с учетом НДС В корзинуСделать предложениеESAM-UNICENTER E03B-200-5 ТРАНСФОРМАТОР ТОКА ТИПА TA 200/5 6 ВА 50 Гц 0,72 кВ/3 ДЛЯ БАР 25X10

Цена: 22,00 € с учетом НДС В корзинуСделать предложениеIME IME-RQ96M ПРОСМОТР НА РУЧНЫЕ ВЕСЫ 0–10 В

Цена: 22,00 € с учетом НДС В корзинуСделать предложениеCELSA-EQ96S-400-1A ПРОСМОТР A HAND 400-1A

Цена: 22,00 € с учетом НДС В корзинуСделать предложениеIME RQ96E-1A СРЕДСТВА ПРОСМОТРА A РУЧНЫЕ ВЕСЫ 0-1A

Цена: 22,00 € с учетом НДС В корзинуСделать предложениеPANTEC CDE96 ПРОСМОТР A РУЧНОЙ 600/1A

Цена: 22,00 € с учетом НДС В корзинуСделать предложениеESAM-UNICENTER E04A-601A ТРАНСФОРМАТОР ТОКА ТИПА E04A-60/1A KV0,72/3 HZ40/60 БАР ПРОХОД 30X10

Цена: 21,47 € с учетом НДС В корзинуСделать предложениеMEAN-WELL SD-15B-05 ПРЕОБРАЗОВАТЕЛЬ ПОСТОЯННОГО ТОКА ОБЩЕГО НАЗНАЧЕНИЯ 15 Вт ВХОД 18/36 В пост.

тока 1,3 А ВЫХОД + 5 В-3 А Цена: 21,00 € с учетом НДС В корзинуСделать предложение

тока 1,3 А ВЫХОД + 5 В-3 А Цена: 21,00 € с учетом НДС В корзинуСделать предложениеSIRIO 151110-9051 ТРАНСФОРМАТОР ТОКА ТА 25-50-100/0,2А

Цена: 20,74 € с учетом НДС В корзинуСделать предложение

© Copyright 2023 Elettronica Lucense

bigscience/bloom · Hugging Face

Bigscience Большой открытой науки с открытым доступом многоязычной языковой модели

Версия 1.3 / 6 июля 2022 г.

Текущая контрольная точка: Обучающая итерация 95000

Ссылка на бумагу: здесь

. представляет собой авторегрессивную модель большого языка (LLM), обученную для продолжения текста из подсказки на огромных объемах текстовых данных с использованием вычислительных ресурсов промышленного масштаба. Таким образом, он может выводить связный текст на 46 языках и 13 языках программирования, который трудно отличить от текста, написанного людьми. BLOOM также можно поручить выполнять текстовые задачи, для которых он явно не обучен, путем преобразования их в задачи генерации текста.

Основы

В этом разделе содержится информация о типе модели, версии, лицензии, спонсорах, дате выпуска, разработчиках и контактная информация. Это полезно для всех, кто хочет сослаться на модель.

Нажмите, чтобы развернутьРазработчик: BigScience (веб-сайт)

Все сотрудники либо являются добровольцами, либо имеют соглашение со своим работодателем. (Дополнительная разбивка участников ожидается.)

Тип модели: Языковая модель на основе преобразователя

Формат чекпоинтов: трансформаторы (формат Megatron-DeepSpeed доступен здесь)

Версия: 1.0.0

Языки: Несколько; см. тренировочные данные

Лицензия: RAIL License v1.0 (ссылка/статья и FAQ)

Предполагаемая дата выпуска: Понедельник, 11 июля 2022 г.

Отправляйте вопросы по адресу: bigscience-contact@googlegroups. com

com

Цитировать как: BigScience, BigScience Language Многоязычная модель открытого доступа (BLOOM) . Международный, май 2021 г. – май 2022 г.

Финансируется:

Правительство Франции.

Обнимающее лицо (веб-сайт).

Организации вкладчиков. (Предстоит дальнейшая разбивка по организациям.)

Технические характеристики

В этом разделе содержится подробная информация о цели и архитектуре модели, а также о вычислительной инфраструктуре. Полезно для людей, интересующихся разработкой моделей.

Нажмите, чтобы развернутьПолную информацию о воспроизведении обучения см. в файле README обучения BLOOM.

Архитектура модели и цель

Изменено из Megatron-LM GPT2 (см. документ, код BLOOM Megatron):

Архитектура только с декодером

Нормализация слоя применена к слою встраивания слов (

StableEmbedding; см. код, документ)

код, документ)Позиционные кодировки ALiBI (см. статью) с функциями активации GeLU

176 247 271 424 параметры:

3 596 615 680 параметры встраивания

70 слоев, 112 головок внимания

Скрытые слои имеют размерность 14336

Длина последовательности из 2048 использованных токенов (см. токенизатор BLOOM, описание токенизатора)

Целевая функция: Перекрестная энтропия с уменьшением среднего (см. документацию по API).

Вычислительная инфраструктура

Общественный суперкомпьютер Jean Zay, предоставленный французским правительством (см. объявление).

Аппаратное обеспечение

384 GPU A100 80 ГБ (48 узлов)

Дополнительные 32 графических процессора A100 80 ГБ (4 узла) в резерве

8 графических процессоров на узел Использование NVLink 4 соединения между графическими процессорами, 4 соединения OmniPath

ЦП: AMD

Память ЦП: 512 ГБ на узел

Память графического процессора: 640 ГБ на узел

Соединение между узлами: архитектура Omni-Path (OPA)

Сеть связи NCCL: полностью выделенная подсеть

Сеть дискового ввода-вывода: общая сеть с другими типами узлов

Программное обеспечение

Megatron-DeepSpeed (ссылка на Github)

DeepSpeed (ссылка на Github)

PyTorch (pytorch-1.

11 с CUDA-11.5; см. ссылку на Github)

11 с CUDA-11.5; см. ссылку на Github)вершина (ссылка на Github)

В этом разделе содержится информация о данных обучения, скорости и размере элементов обучения, а также о воздействии обучения на окружающую среду. Это полезно для людей, которые хотят узнать больше о входных данных модели и тренировочном следе.

Нажмите, чтобы развернутьТренировочные данные

В этом разделе представлен общий обзор обучающих данных. Это актуально для всех, кто хочет знать основы того, что изучает модель.

Подробная информация о каждом наборе данных представлена в отдельных карточках данных, а размеры каждого из их вкладов в агрегированные обучающие данные представлены на интерактивной карте корпуса.

Учебные данные включают:

46 естественных языков

13 языков программирования

1,6 ТБ предварительно обработанного текста, преобразованного в 350 млрд уникальных токенов (дополнительную информацию см.

в разделе о токенизаторе).

в разделе о токенизаторе).

Языки

На круговой диаграмме показано распределение языков в обучающих данных.

В следующих таблицах показано дальнейшее распределение нигерско-конголезских и индийских языков и языков программирования в обучающих данных.

Распространение Нигер Конго и индейских языков.

| Нигер Конго | Процент | Индивидуальный | Процент | |

|---|---|---|---|---|

| Чи Тумбука | 0,00002 | Ассамский | 0,01 | |

| Кикую | 0,00004 | Одия | 0,04 | |

| Бамбара | 0,00004 | Гуджарати | 0,04 | |

| Акан | 0,00007 | маратхи | 0,05 | |

| Сицонга | 0,00007 | Пенджаби | 0,05 | |

| Сесото | 0,00007 | Каннада | 0,06 | |

| Чи Чева | 0,0001 | Непальский | 0,07 | |

| Сетсвана | 0,0002 | Телугу | 0,09 | |

| Лингала | 0,0002 | Малаялам | 0,10 | |

| Северный сото | 0,0002 | Урду | 0,10 | |

| Фон | 0,0002 | Тамильский | 0,20 | |

| Кирунди | 0,0003 | Бенгальский | 0,50 | |

| Волоф | 0,0004 | Хинди | 0,70 | |

| Луганда | 0,0004 | |||

| Чи Шона | 0,001 | |||

| Иси Зулу | 0,001 | |||

| Игбо | 0,001 | |||

| коса | 0,001 | |||

| Киньяруанда | 0,003 | |||

| Йоруба | 0,006 | |||

| Суахили | 0,02 |

Распространение языков программирования.

| Расширение | Язык | Количество файлов |

|---|---|---|

| ява | Ява | 5 407 724 |

| PHP | PHP | 4,942 186 |

| cpp | С++ | 2 503 930 |

| ру | Питон | 2 435 072 |

| JS | JavaScript | 1 905 518 |

| кс | С# | 1 577 347 |

| рб | Рубин | 6 78 413 |

| куб.см | С++ | 443 054 |

| л.с. | С++ | 391 048 |

| суа | Луа | 352 317 |

| перейти | ГО | 227 763 |

| тс | TypeScript | 195 254 |

| С | С | 134 537 |

| скала | Скала | 92 052 |

| чч | С++ | 67 161 |

| Н | С++ | 55 899 |

| тсх | TypeScript | 33 107 |

| руб | Ржавчина | 29 693 |

| PHP | 9 702 | |

| С++ | С++ | 1 342 |

| ч++ | С++ | 791 |

| php3 | PHP | 540 |

| фипсов | PHP | 270 |

| PHP5 | PHP | 166 |

| php4 | PHP | 29 |

Предварительная обработка

Токенизация: Токенизатор BLOOM (ссылка), обученный токенизатор подслов, обученный с использованием:

Алгоритм кодирования пар байтов (BPE) на уровне байтов

Простое правило предварительной токенизации, без нормализации

Размер словарного запаса 250 680

Он был обучен на подмножестве предварительной версии корпуса с использованием альфа-взвешивания для каждого языка.

Скорости, размеры, время

Журналы тренировок: ссылка на Tensorboard

Даты:

Запущено 11 марта 2022 г., 11:42 по тихоокеанскому стандартному времени

Предполагаемый срок окончания: 5 июля 2022 г.

Размер контрольной точки:

Производительность обучения: около 150 TFLOP на GPU в секунду

Количество эпох: 1

Ориентировочная стоимость обучения: Эквивалент 2-5 миллионов долларов США в области облачных вычислений (включая предварительные эксперименты)

Место обучения сервера: Иль-де-Франс, Франция

Воздействие на окружающую среду

Учебный суперкомпьютер Jean Zay (веб-сайт) использует в основном ядерную энергию. Вырабатываемое им тепло повторно используется для обогрева жилья кампуса.

Оценка выбросов углерода: (ожидается)

Расчетное потребление электроэнергии: (ожидается)

В этом разделе рассматриваются вопросы, связанные с тем, как предполагается использовать модель, обсуждаются предполагаемые пользователи модели (включая тех, кого модель затрагивает), а также описываются способы использования, которые считаются выходящими за рамки или неправильное использование модели. Это полезно для всех, кто рассматривает возможность использования модели или на кого она влияет.

Это полезно для всех, кто рассматривает возможность использования модели или на кого она влияет.

Как использовать

Эту модель можно легко использовать и развертывать с помощью экосистемы HuggingFace. Для этого необходимо установить трансформаторы и , ускоряющие . Скачать модель можно так:

Использование по назначению

Эта модель создается для проведения общедоступных исследований больших языковых моделей (LLM). LLM предназначены для использования для генерации языка или в качестве предварительно обученной базовой модели, которую можно дополнительно настроить для конкретных задач. Приведенные ниже варианты использования не являются исчерпывающими.

Прямое использование

Использование ниже по течению

- Задачи, использующие языковые модели, включают: извлечение информации, ответы на вопросы, обобщение

Неправильное использование и использование не по назначению

В этом разделе рассказывается о том, что пользователям не следует делать с моделью.

См. Лицензию BLOOM, Приложение A, для получения подробной информации об ограничениях использования. Приведенный ниже список не является исчерпывающим, но перечисляет некоторые легко предсказуемые проблемные варианты использования.

Использование вне области применения

Использование модели в условиях высоких ставок недоступно для этой модели. Модель не предназначена для критических решений и не может быть использована с какими-либо существенными последствиями для средств к существованию или благополучия человека. Модель выводит контент, который кажется фактическим, но может быть неверным.

Использование вне области применения Включает в себя:

Использование в биомедицинских, политических и правовых областях или в области финансов

Использование для оценки или оценки отдельных лиц, например, для трудоустройства, образования или получения кредита

Применение модели для критически важных автоматических решений, генерация фактического контента, создание надежных сводок или генерация прогнозов, которые должны быть правильными

Неправильное использование

Намеренное использование модели для причинения вреда, нарушения прав человека или других злонамеренных действий является неправильным использованием этой модели. В том числе:

В том числе:

Создание спама

Дезинформация и операции влияния

Унижение и диффамация

Домогательства и жестокое обращение

Обман

Самовольное олицетворение и имитация

Наблюдение без согласия

Создание контента без указания модели, как указано в лицензии RAIL, ограничения на использование

Предполагаемые пользователи

Прямые пользователи

Общий номер

Исследователи

Студенты

Педагоги

Инженеры/разработчики

Некоммерческие организации

Общественные защитники, включая группы по правам человека и гражданским правам

Косвенные пользователи

Пользователи производных продуктов, созданных Прямыми пользователями, например, использующие программное обеспечение по назначению

Пользователи производных моделей, как описано в Лицензии

Другие затронутые стороны (Стороны Prenantes)

Люди и группы, на которые ссылается LLM

Люди и группы, подвергающиеся воздействию результатов или решений, основанных на LLM

Люди и группы, чья оригинальная работа включена в LLM

В этом разделе указаны предсказуемый вред и недоразумения.

Модель может:

Чрезмерное представление одних точек зрения и недостаточное представление других

Содержат стереотипы

Содержит личную информацию

Создать:

Выражение ненависти, оскорблений или насилия

Дискриминационные или предвзятые формулировки

Контент, который может не подходить для всех настроек, включая контент сексуального характера

Допускать ошибки, в том числе предоставлять неверную информацию, как будто она соответствует действительности

Создание нерелевантных или повторяющихся выходных данных

Побуждать пользователей приписывать ему человеческие черты, такие как разум или сознание

В этом разделе описываются протоколы оценки и приводятся результаты.

Нажмите, чтобы развернутьМетрики

В этом разделе описываются различные способы расчета производительности и почему.

Включает:

| Метрическая система | Почему выбрали |

|---|---|

| Недоумение | Стандартная метрика для количественной оценки улучшений модели во время обучения |

| Перекрестная потеря энтропии | Стандартная цель для языковых моделей. |

И несколько разных показателей для конкретных задач. (Дополнительные показатели оценки появятся после завершения протокола оценки.)

Факторы

В этом разделе перечислены некоторые аспекты моделей BLOOM. Основное внимание уделяется аспектам, которые могут привести к высокой дисперсии поведения модели.

Язык, например английский или йоруба

Домен, например лента новостей или истории

Демографические характеристики, такие как пол или национальность

Полученные результаты

Результаты основаны на факторах и показателях.

Нулевые оценки:

ПРЕДУПРЕЖДЕНИЕ: Раньше этот раздел содержал гораздо больше результатов, однако они были неправильными, и мы опубликовали их без одобрения рабочей группы по оценке. В настоящее время мы находимся в процессе исправления оценок.

См. этот репозиторий для файлов JSON: https://github.com/bigscience-workshop/evaluation-results

| Задача | Язык | Метрическая система | БЛУМ-176B | ОПТ-175Б* |

|---|---|---|---|---|

| гуманный | питон | проход@1 ↑ | 0,155 | 0,0 |

| гуманный | питон | проход@10 ↑ | 0,328 | 0,0 |

| гуманный | питон | проход@100 ↑ | 0,572 | 0,003 |

Оценка времени поезда:

Конечная контрольная точка после 95 тыс. шагов:

шагов:

Подробнее см.: https://huggingface.co/bigscience/tr11-176B-ml-logs

В этом разделе содержится информация о предупреждениях и возможных мерах по устранению последствий.

Нажмите, чтобы развернутьКосвенные пользователи должны быть уведомлены, когда контент, с которым они работают, создается LLM.

Пользователи должны быть осведомлены о рисках и ограничениях и при необходимости включить соответствующий отказ от ответственности или блокирующий интерфейс.

Модели, обученные или настроенные после BLOOM LM, должны иметь обновленную карточку модели.

Пользователи модели должны предоставить затронутым лицам механизмы для предоставления отзывов, например адрес электронной почты для комментариев.

В этом разделе определяются общие термины и способы расчета показателей.

Нажмите, чтобы развернутьПотери: Расчет разницы между тем, что изучила модель, и тем, что показывают данные («наземная правда»).

Чем меньше потери, тем лучше. Тренировочный процесс направлен на минимизацию потерь.

Чем меньше потери, тем лучше. Тренировочный процесс направлен на минимизацию потерь.Недоумение: Это основано на том, как модель оценивает вероятность появления новых данных. Чем ниже недоумение, тем лучше. Если модель на 100% правильно предсказывает следующий токен, который она увидит, то недоумение равно 1. Математически это вычисляется с использованием энтропии.

Настройки с высокими ставками: Например, те, которые определены как «системы ИИ с высоким риском» и «системы ИИ с неприемлемым риском» в предложенном Европейском союзе Законе об искусственном интеллекте (ИИ).

Критические решения: Такие, как те, которые определены в предложенном Соединенными Штатами законе об алгоритмической ответственности.

Права человека: Включает права, определенные во Всеобщей декларации прав человека.

Персональные данные и личная информация: Персональные данные и информация определяются в нескольких правилах защиты данных, таких как «личные данные» в Общем регламенте ЕС по защите данных; и «личная информация» в Законе о защите личной информации Южно-Африканской Республики, Законе о защите личной информации Китайской Народной Республики.

Конфиденциальные характеристики: Сюда входят особо охраняемые категории в области прав человека (см. UHDR, статья 2) и регулирование личной информации (см. GDPR, статья 9).; Закон о защите личной информации, глава 1)

Обман: Действия, направленные на то, чтобы умышленно ввести людей в заблуждение, чтобы они поверили чему-то ложному, например, путем создания мертвых ботов или чат-ботов в социальных сетях, выдающих себя за реальных людей, или создания текстовых документов без информирования потребителей о том, что текст сгенерирован машиной.

В этом разделе приведены ссылки на материалы по созданию набора данных, технические спецификации, извлеченные уроки и первоначальные результаты.

Нажмите, чтобы развернутьПромежуточные контрольно-пропускные пункты

Для академического (или любого другого) использования мы опубликовали промежуточные контрольные точки, соответствующие состоянию модели на каждые 5000 шагов. Пожалуйста, перейдите по этой ссылке, чтобы получить эти контрольные точки.

Пожалуйста, перейдите по этой ссылке, чтобы получить эти контрольные точки.

Создание набора данных

Сообщение в блоге с подробным описанием вариантов дизайна во время создания набора данных: https://bigscience.huggingface.co/blog/building-a-tb-scale-multilingual-dataset-for-language-modeling

Технические характеристики

Сообщение в блоге, в котором кратко излагаются выбранные архитектура, размер, форма и продолжительность предварительной подготовки: https://bigscience.huggingface.co/blog/what-language-model-to-train-if-you-have-two- миллион GPU-часов

Подробнее об архитектуре/оптимизаторе: https://github.com/bigscience-workshop/bigscience/tree/master/train/tr11-176B-ml

Сообщение в блоге об оборудовании/инженерии: https://bigscience.huggingface.co/blog/what-hardware-to-train-a-176b-parameters-model

Подробная информация о распределенной установке, используемой для обучения: https://github.com/bigscience-workshop/bigscience/tree/master/train/tr11-176B-ml

Tensorboard обновлен во время обучения: https://huggingface. co/bigscience/tr11-176B-ml-logs/tensorboard#scalars&tagFilter=loss

co/bigscience/tr11-176B-ml-logs/tensorboard#scalars&tagFilter=loss

Уроки

Информация о том, как подходить к обучению, отрицательные результаты: https://github.com/bigscience-workshop/bigscience/blob/master/train/lessons-learned.md

Подробности о препятствиях, преодолеваемых при подготовке по инженерной части (нестабильности, оптимизация пропускной способности обучения, очень много технических хитростей и вопросов): https://github.com/bigscience-workshop/bigscience/blob/master/train/tr11 -176B-ml/chronicles.md

Первоначальные результаты

Первоначальные эксперименты с подсказками с использованием промежуточных контрольных точек: https://huggingface.co/spaces/bigscience/bloom-book

Оригинальные КПП

Контрольные точки в этом репозитории соответствуют формату HuggingFace Transformers. Если вы хотите использовать наш форк Megatron-DeepSpeed, с которым была обучена модель, вам лучше использовать этот репозиторий.

72-3 HZ40-60 Цена: 30,00 € с учетом НДС В корзинуСделать предложение

72-3 HZ40-60 Цена: 30,00 € с учетом НДС В корзинуСделать предложение Цена: 26,60 € с учетом НДС В корзинуСделать предложение

Цена: 26,60 € с учетом НДС В корзинуСделать предложение тока 1,3 А ВЫХОД + 5 В-3 А Цена: 21,00 € с учетом НДС В корзинуСделать предложение

тока 1,3 А ВЫХОД + 5 В-3 А Цена: 21,00 € с учетом НДС В корзинуСделать предложение код, документ)

код, документ) 11 с CUDA-11.5; см. ссылку на Github)

11 с CUDA-11.5; см. ссылку на Github) в разделе о токенизаторе).

в разделе о токенизаторе). Чем меньше потери, тем лучше. Тренировочный процесс направлен на минимизацию потерь.

Чем меньше потери, тем лучше. Тренировочный процесс направлен на минимизацию потерь.