Алгебра свободных и скользящих векторов

Алгебра свободных и скользящих векторов

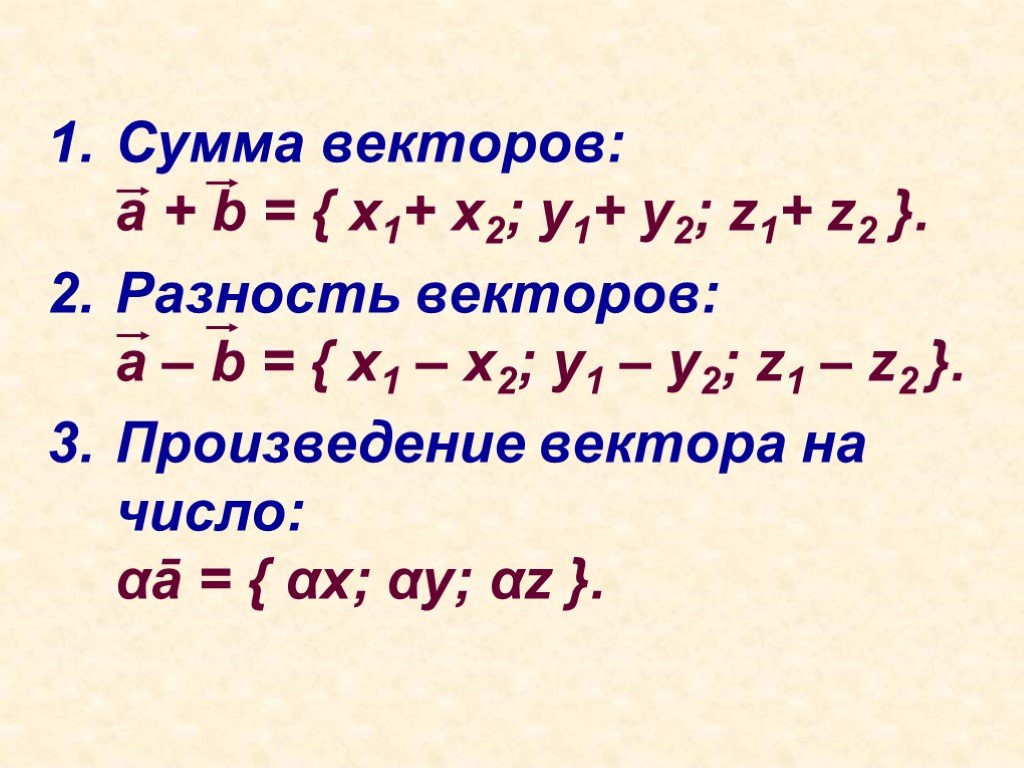

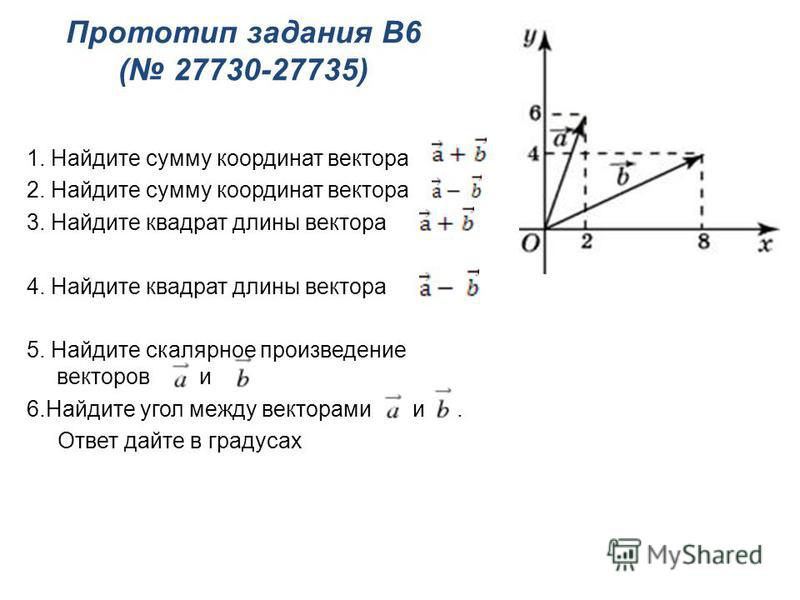

ОглавлениеПРЕДИСЛОВИЕВВЕДЕНИЕ ГЛАВА I. ВЕКТОРНАЯ АЛГЕБРА 2. Определение вектора. 3. Классификация векторов. 4. Равенство векторов. 5. Перенос вектора. 6. Нуль-вектор. 7. Компланарность и коллинеарность векторов. 8. Прямопротивоположные векторы. § 2. СЛОЖЕНИЕ И ВЫЧИТАНИЕ ВЕКТОРОВ 2. Сумма векторов. 3. Свойства суммы векторов. 4. Правила параллелограмма и параллелепипеда. 5. Разность двух векторов. 6. Свойства модуля суммы векторов. 2. Свойства произведения. 3. Деление вектора на число. 4. Единичные векторы. 5. Орт оси. 6. Коллинеарность двух векторов. § 4. РАЗЛОЖЕНИЕ ВЕКТОРОВ 3. Разложение вектора по трем другим векторам.  4. Разложение вектора по ортам базиса. § 5. ЛИНЕЙНАЯ ЗАВИСИМОСТЬ ВЕКТОРОВ 2. Условие коллинеарности двух векторов. 3. Условие компланарности трех векторов. 4. Линейная зависимость четырех векторов. § 6. ПРОЕКЦИИ ВЕКТОРА 2. Свойства составляющих вектора. 3. Проекция вектора на ось. 5. Угол между векторами. 6. Вычисление проекций вектора. 7. Теорема о проекции сумммы векторов. 8. Псевдоскаляры. § 7. СПОСОБЫ ЗАДАНИЯ ВЕКТОРА 2. Естественный способ задания свободного вектора. 3. Задание свободного вектора с помощью его проекций (координатный метод). 4. Связь между естественным и координатным способами задания вектора. 5. Задание несвободного вектора. 6. Задание скользящего вектора. 7. Некоторые приложения. § 8. СКАЛЯРНОЕ ПРОИЗВЕДЕНИЕ ДВУХ ВЕКТОРОВ 2. Свойства скалярного произведения. 3. Выражение скалярного произведения через проекции векторов. 4. Векторные уравнения геометрических мест.  5. Уравнение плоскости. 7. Изменение проекций вектора при преобразовании координат. 8. Другое определение вектора. § 9. ВЕКТОРНОЕ ПРОИЗВЕДЕНИЕ 2. Примеры из физики. 3. Способ Н. Е. Жуковского построения векторного произведения. 4. Свойства векторного произведения. 5. Разложение вектора-произведения по координатным ортам. 6. Условие коллинеарности двух векторов. 7. Тождество Лагранжа. 8. Полярные и аксиальные векторы. § 10. СЛОЖНЫЕ ПРОИЗВЕДЕНИЯ ВЕКТОРОВ 2. Двойное векторное произведение. 3. Разложение вектора по трем другим векторам. 5. Векторное произведение двух векторных произведений. 6. Произведение двух смешанных произведений. 7. Взаимные реперы. § 11. ВЕКТОРНЫЕ УРАВНЕНИЯ ПРЯМОЙ ЛИНИИ 2. Уравнение прямой, проходящей через две заданные точки. 3. Плюкерово уравнение прямой в пространстве. 4. Прямая как пересечение двух плоскостей. § 12. ИНВАРИАНТЫ ОТНОСИТЕЛЬНО ПРЕОБРАЗОВАНИЯ ОСЕЙ ГЛАВА II.  АЛГЕБРА СКОЛЬЗЯЩИХ ВЕКТОРОВ АЛГЕБРА СКОЛЬЗЯЩИХ ВЕКТОРОВ§ 13. МОМЕНТ ВЕКТОРА ОТНОСИТЕЛЬНО ТОЧКИ И ОСИ. ЗАДАНИЕ СКОЛЬЗЯЩЕГО ВЕКТОРА 2. Момент вектора относительно точки. 4. Момент вектора относительно оси. 5. Задание скользящего вектора его проекциями и моментами относительно координатных осей. § 14. ГЛАВНЫЙ ВЕКТОР И ГЛАВНЫЙ МОМЕНТ СИСТЕМЫ ВЕКТОРОВ 2. Главный вектор системы векторов. 3. Главный момент системы векторов. 4. Система двух равнопротивоположных векторов. 5. Первая теорема Вариньона. 6. Изменение главного момента с изменением полюса. 7. Инварианты системы векторов. 8. Минимальный момент и центральная ось системы. 9. Распределение главных моментов в пространстве. 10. Понятие о винте. 11. Винт системы векторов. § 15. ЭКВИВАЛЕНТНЫЕ СИСТЕМЫ ВЕКТОРОВ 2. Основные определения и аксиомы. § 17. ЭКВИВАЛЕНТНЫЕ СИСТЕМЫ СКОЛЬЗЯЩИХ ВЕКТОРОВ 2. Приведение произвольной системы скользящих векторов к системе двух векторов (геометрическое решение).  § 18. УСЛОВИЯ ЭКВИВАЛЕНТНОСТИ ДВУХ СИСТЕМ СКОЛЬЗЯЩИХ ВЕКТОРОВ 2. Условия эквивалентности двух систем скользящих векторов. 3. Преобразование эквивалентных систем. § 19. ТЕОРИЯ ПАР 1. Пара векторов и ее момент. 2. Свойства пар. 3. Винт § 20. ПРИВЕДЕНИЕ СИСТЕМЫ СКОЛЬЗЯЩИХ ВЕКТОРОВ К ПРОСТЕЙШЕМУ ВИДУ 2. Приведение системы скользящих векторов к системе двух векторов (аналитическое решение). 4. Пример из кинематики. 5. Приведение системы скользящих векторов к винту. 6. Примеры. 7. Уравнения равновесия векторов. 8. Вторая теорема Вариньона. § 21. ИССЛЕДОВАНИЕ ЧАСТНЫХ СЛУЧАЕВ 2. Плоская система скользящих векторов. 3. Система параллельных скользящих векторов. 4. Центр системы параллельных векторов. |

| 1 | |

| 00:00:13,210 —> 00:00:18,935 | |

| Мы проиллюстрировали метод наименьших | |

| квадратов для множественной регрессии, | |

когда у нас много регрессоров. | |

| И попутно мы обнаружили следующие факты, | |

| что если в модель включён свободный член, | |

| регрессоры, то есть существует β₁, | |

| то, соответственно, среди столбцов матрицы | |

| X большое будет слева столбик из единичек, | |

| и в этом случае наши | |

| оценки метода наименьших | |

| квадратов будут обладать | |

| следующими свойствами, | |

| а именно: сумма ошибок прогнозов, | |

| сумма ε_i с крышкой будет равняться нулю, | |

| сумма y будет равняться сумме | |

| прогнозных y, или, другими словами, | |

| среднее значение прогноза будет равняться | |

| среднему значению наблюдаемой переменной, | |

| а также будет присутствовать | |

| на рисунке мы увидели это | |

как теорему Пифагора. | |

| Наличие последнего разложения общей | |

| суммы квадратов на две составляющие | |

| RRS плюс ESS позволяет придумать | |

| простой показатель качества модели, | |

| а именно R-квадрат, который умными словами | |

| называется коэффициент детерминации. | |

| Мы знаем, что чем прогнозы точнее | |

| похожи на настоящие Y, | |

| тем меньше будут ошибки прогнозов | |

| ε с крышкой и тем меньше будет сумма | |

квадратов ошибок прогнозов RSS. | |

| Соответственно, отношение ESS к TSS, | |

| или R-квадрат, | |

| будет примерно равно единичке, если RSS, | |

| сумма квадратов ошибок, будет у нуля. | |

| Соответственно, мы получили коэффициент | |

| R-квадрат, коэффициент детерминации, | |

| который всегда лежит от 0 до 1, | |

| и значения, близкие к 0, | |

| означают, что сумма квадратов ошибок, | |

| сумма квадратов остатков очень большая, | |

| а значения R-квадрат, | |

| близкие к 1, говорят о том, | |

| что сумма квадратов остатков, | |

сумма квадратов ошибок прогноза маленькая. | |

| Или, другими словами, | |

| R-квадрат — это есть доля объяснённого | |

| разброса y к общему разбросу, | |

| общей сумме квадратов. | |

| Также этот коэффициент R-квадрат | |

| можно интерпретировать по-другому, | |

| не только как объяснённую долю разброса y, | |

| но и как квадрат выборочной корреляции, | |

| а именно: R-квадрат — это есть квадрат | |

| выборочного коэффициента корреляции, | |

| который равен дроби: в числителе сумма y_i | |

| минус y среднее, помножить на y_i с крышкой | |

| минус y среднее, и в знаменателе корни | |

из TSS помножить на корень из ESS. | |

| Оказывается, доказательство | |

| этого факта очень простое. | |

| Дело в том, что выборочный коэффициент | |

| корреляции — это ни что иное, | |

| как косинус угла между некоторыми двумя | |

| векторами, что мы сейчас и увидим. | |

| А вот теперь как раз нам | |

| потребуется четвёртый факт, | |

| что ESS к TSS — это | |

| косинус квадрат угла φ. | |

| Как мы выяснили, показатель детерминации, | |

| коэффициент — это есть | |

отношение ESS к TSS. | |

| То есть он несёт тот смысл, | |

| что это есть доля объяснённого | |

| разброса переменной y в | |

| общем разбросе переменной y. | |

| Соответственно, из предыдущих формул | |

| следует, что этот показатель лежит от 0 до | |

| 1, и R-квадрат — это | |

| косинус квадрат угла φ. | |

| Но, оказывается, | |

| для косинуса у нас есть и другая формула. | |

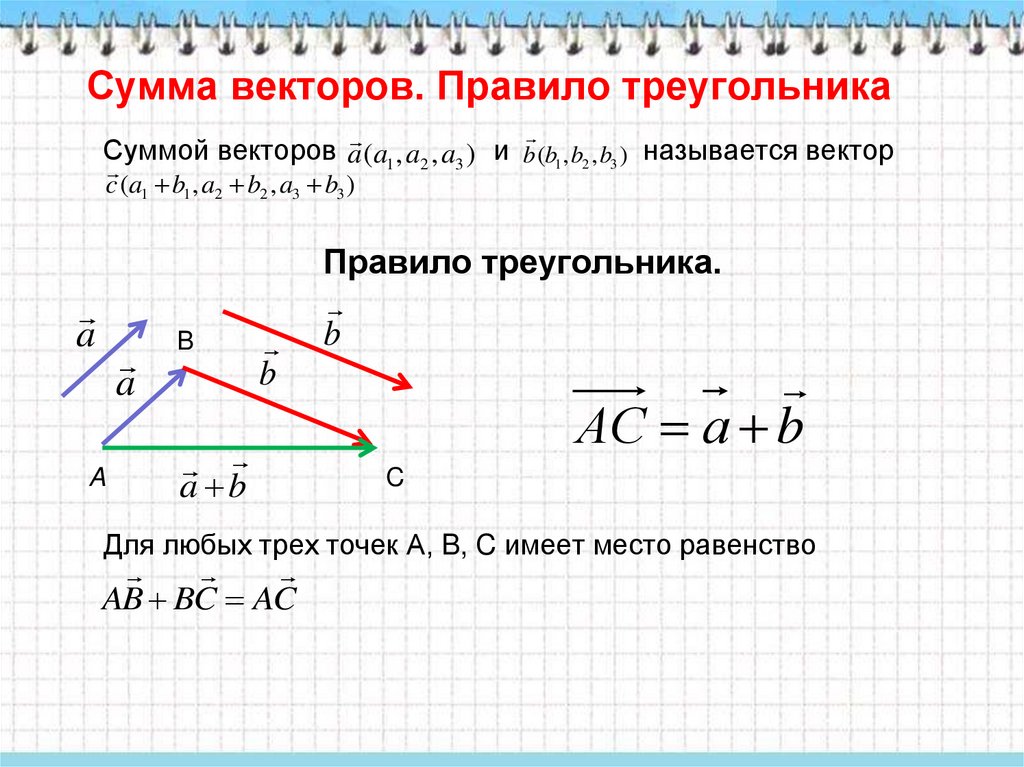

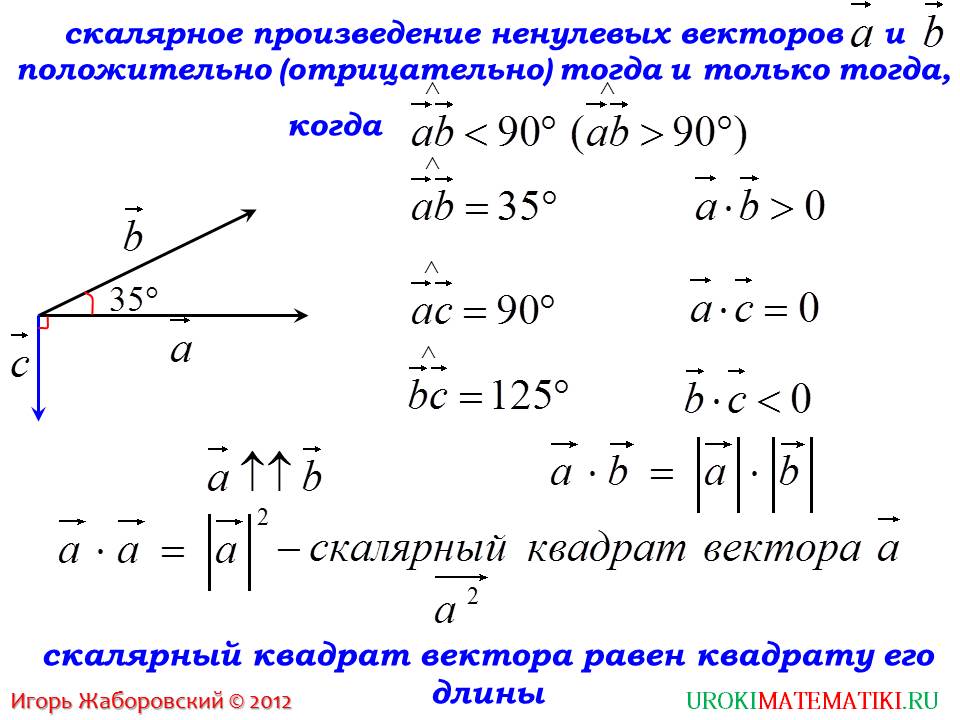

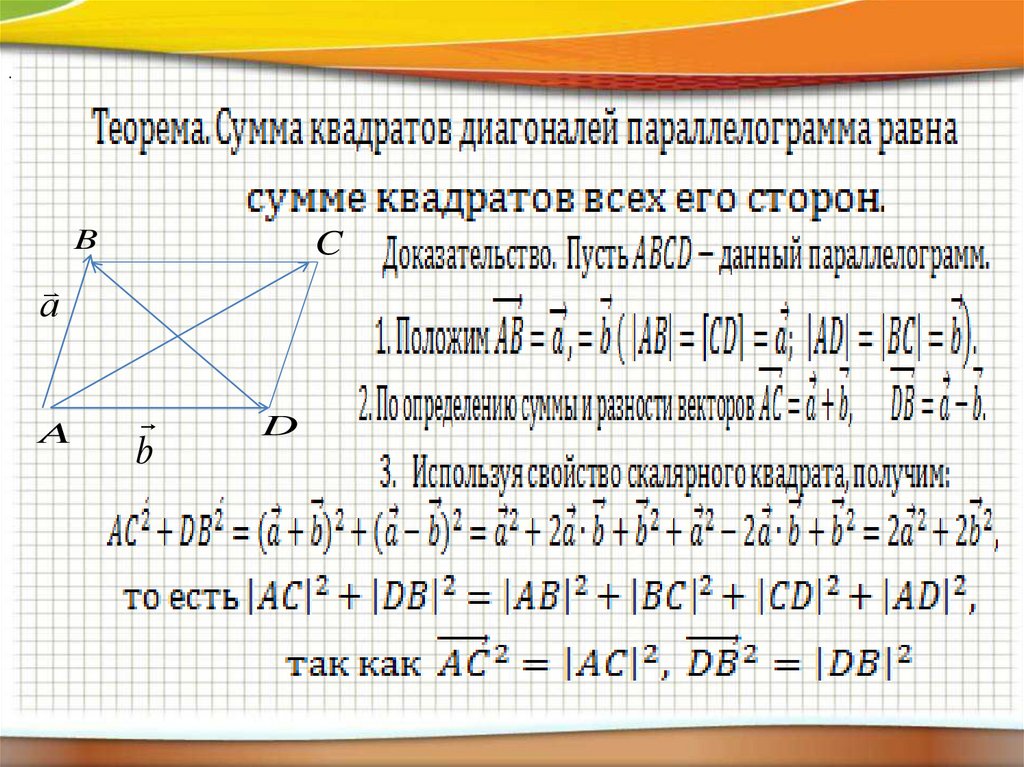

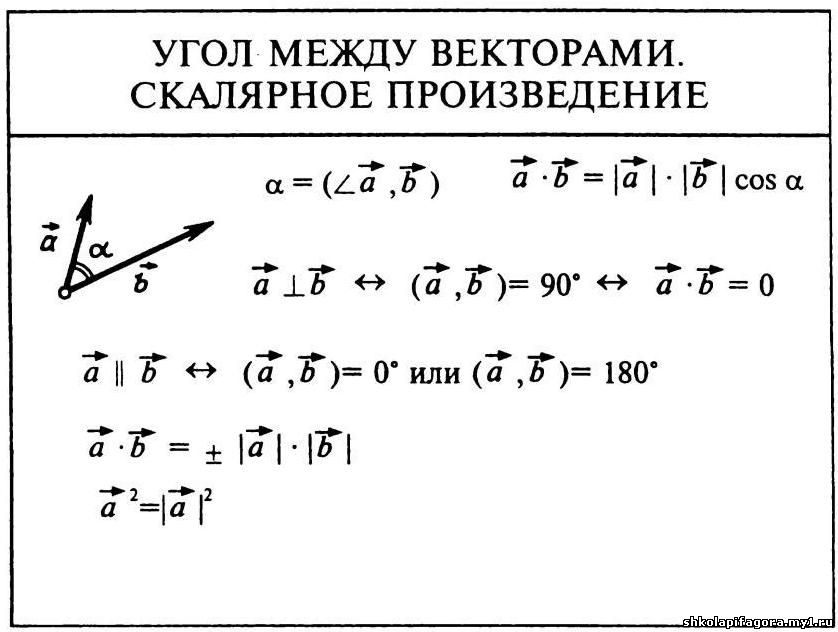

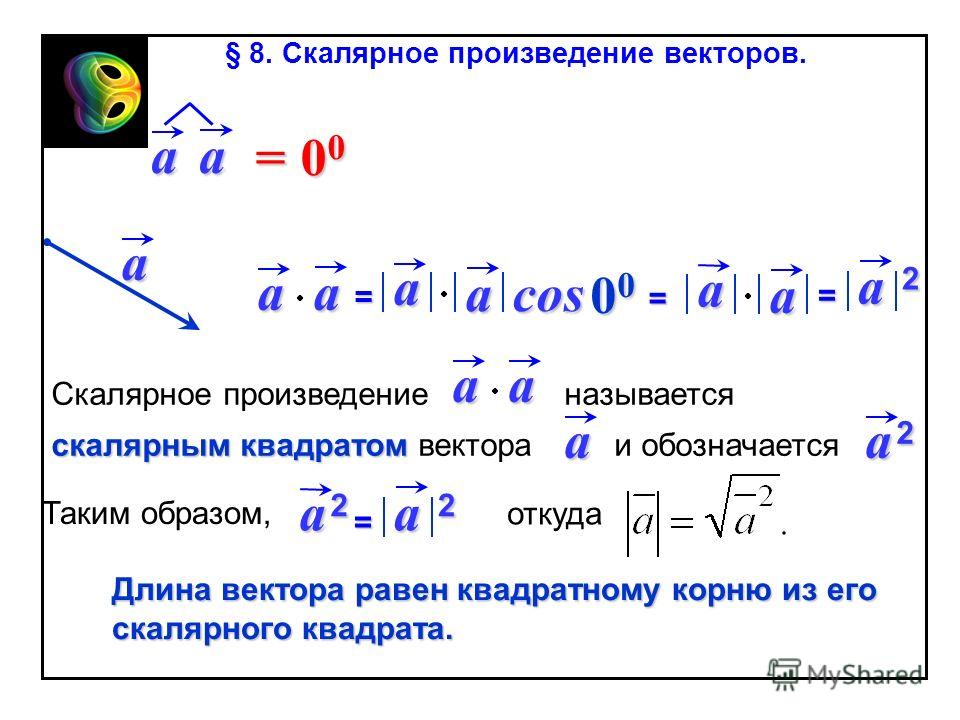

| Из-за того, что скалярное произведение | |

| любых двух векторов A и B | |

| — это есть длина вектора | |

| A помножить на длину вектора | |

| B на косинус угла между ними, | |

| то из этого факта следует | |

| выражение для косинуса, | |

| а именно: косинус между | |

| любыми двумя векторами — это | |

| есть скалярное произведение | |

| этих двух векторов делить | |

| на длину одного вектора | |

на длину другого вектора. | |

| Соответственно, что в нашем случае | |

| будет являться R-квадратом, | |

| или косинусом квадрата между какими | |

| двумя векторами является R-квадрат? | |

| Косинусом какого угла он является? | |

| Угол φ — это угол между AB и BC. | |

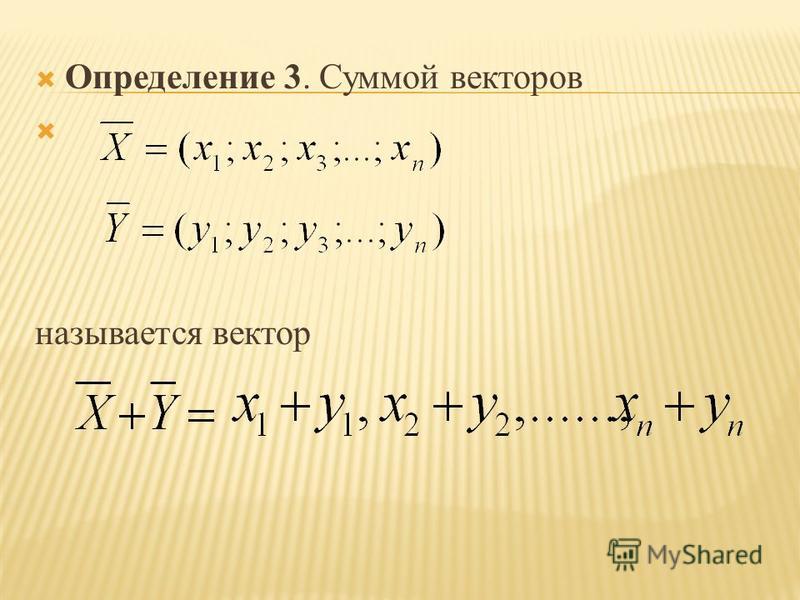

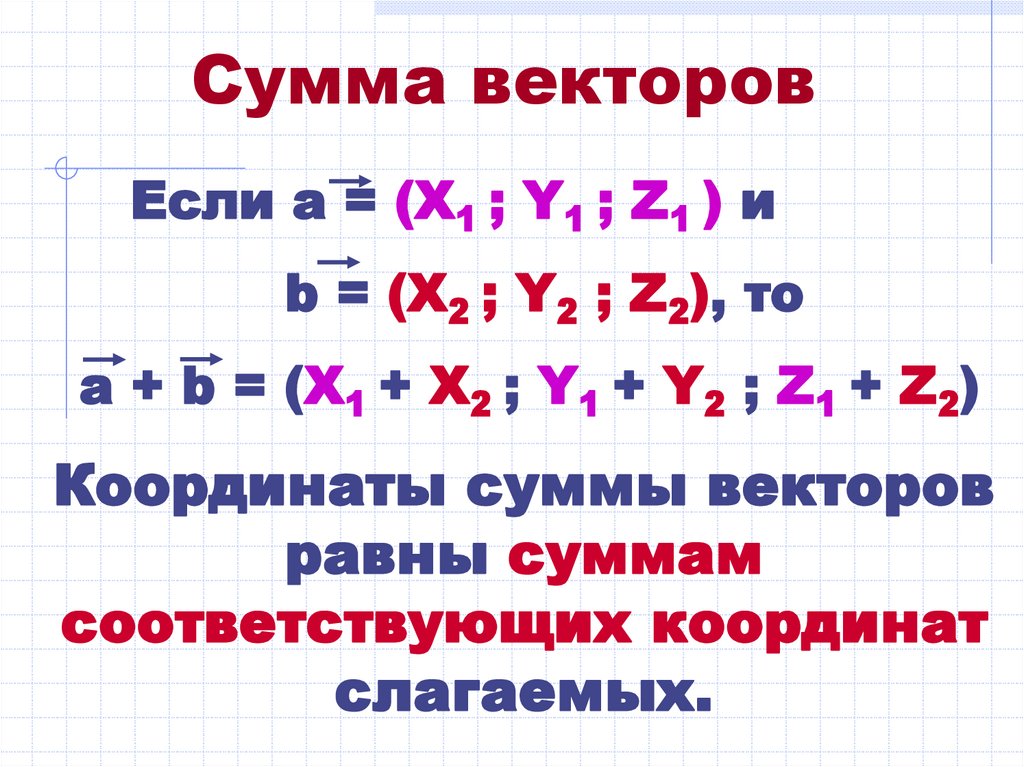

| Соответственно, у нас вектор AB с | |

| точностью до направления можно задать | |

| как y минус y | |

| среднее помножить на вектор из единичек. | |

Соответственно. .. .. | |

| Это на самом деле, конечно, BA. | |

| А вектор, | |

| вектор BC можно задать как вектор | |

| y с крышкой минус y среднее | |

| помножить на вектор из единичек. | |

| Это вектор BC. | |

| Соответственно, нам нужен косинус | |

| угла между этими векторами. | |

| Соответственно, что мы получим, | |

| когда посчитаем длину первого | |

| вектора и длину второго вектора? | |

| У нас получается, | |

| что скалярное произведение | |

| BC c BA — | |

| это есть скалярное произведение вектора | |

| y минус y средняя помножить | |

| на вектор из единичек, | |

| y с крышкой минус y средняя | |

помножить на вектор из единичек. | |

| Соответственно, это есть сумма. | |

| Поскольку с другой стороны скалярное | |

| произведение можно определить как, | |

| скалярное произведение a на b можно | |

| определить как сумму a_i на b_i, | |

| то нам просто нужно попарно | |

| перемножить компоненты этих векторов. | |

| Соответственно, у нас получится: первая | |

| компонента этого вектора — это y_1 минус y79 | |

| 00:06:43,502 —> 00:06:48,930 | |

| средняя, первая компонента второго вектора | |

— это y с крышкой первая минус y средняя. | |

| Соответственно, я беру | |

| y_i минус y средняя и | |

| перемножаю на y_i с | |

| крышкой минус y средняя. | |

| Это я нашёл числитель. | |

| Соответственно, как выглядит знаменатель? | |

| В знаменателе у нас | |

| находится длина вектора BC, | |

| это корень квадратный из суммы | |

| квадратов его компонент, | |

| то есть это корень квадратный из суммы, | |

| BC это y с крышкой, | |

| соответственно: y_i с крышкой | |

минус y средняя в квадрате. | |

| Ну, а соответственно, | |

| длина вектора BA — это | |

| есть корень из суммы | |

| квадратов его компонент, | |

| то есть корень из суммы y_i | |

| минус y средняя в квадрате. | |

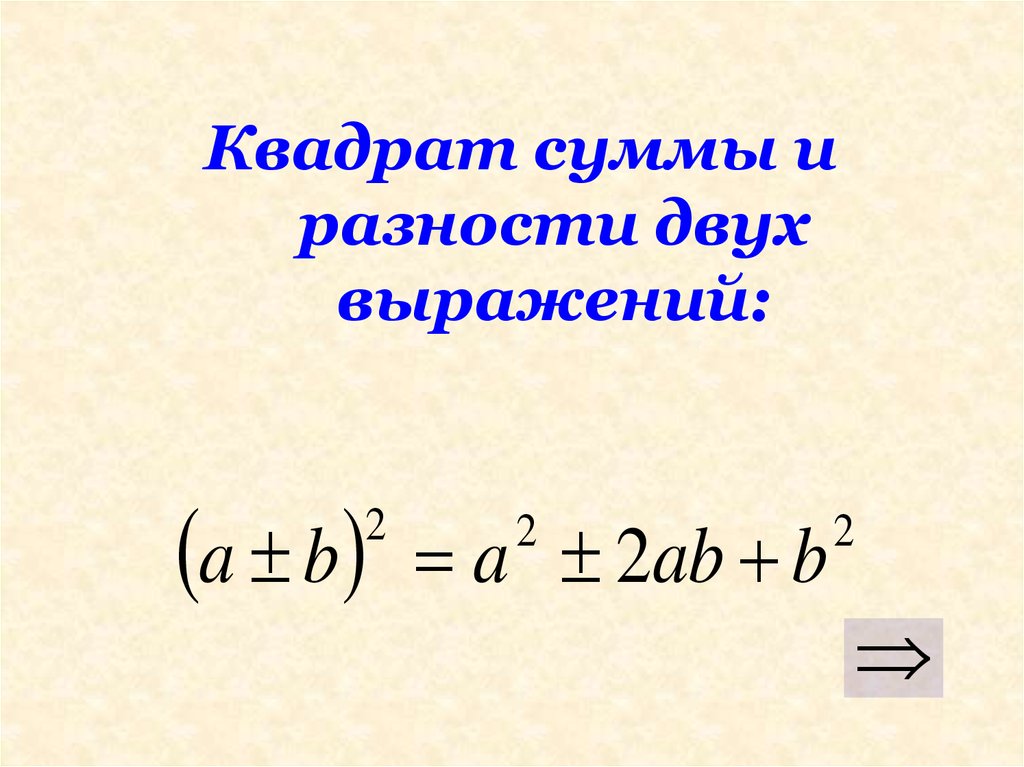

| Соответственно, мы получили ещё одну | |

| формулу для коэффициента R-квадрат, | |

| а именно: R-квадрат | |

| равняется — в числителе сумма y_i минус | |

| y средняя помножить на y_i | |

| с крышкой минус y средняя, | |

| деленное на корень квадратный | |

| из сумма y_i минус y средняя в | |

| квадрате на сумма y_i с крышкой | |

минус y средняя в квадрате. | |

| А, с другой стороны, | |

| что это такое по сути? | |

| Здесь можно узнать формулу выборочной | |

| корреляции между двумя векторами, | |

| а именно: это выборочная корреляция, | |

| обозначу её sCorr (sample | |

| correlation — выборочная | |

| корреляция), между | |

| векторами y и y с крышкой. | |

| И всё, конечно, нужно взять в квадрат, | |

| поскольку я считал косинус угла, | |

а R-квадрат — это косинус квадрат угла. | |

| Таким образом, | |

| мы получили две интерпретации для | |

| показателя в качестве регрессии. | |

| С одной стороны, R-квадрат — это | |

| доля объяснённой дисперсии y, доля | |

| объяснённого разброса y: это объяснённый | |

| разброс y делить на общий разброс y. | |

| А с другой стороны, | |

| R-квадрат — это выборочна корреляция между | |

| прогнозами и настоящим y, | |

взятое в квадрат. | |

| Чем R-квадрат выше, | |

| тем больше y с крышкой похож на y, | |

| чем чем R-квадрат выше, | |

| тем выше доля объяснённой дисперсии. | |

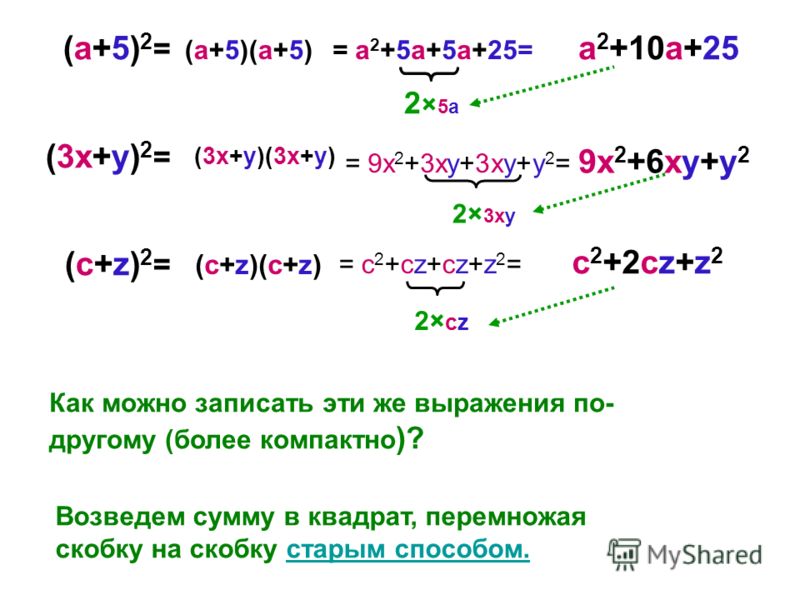

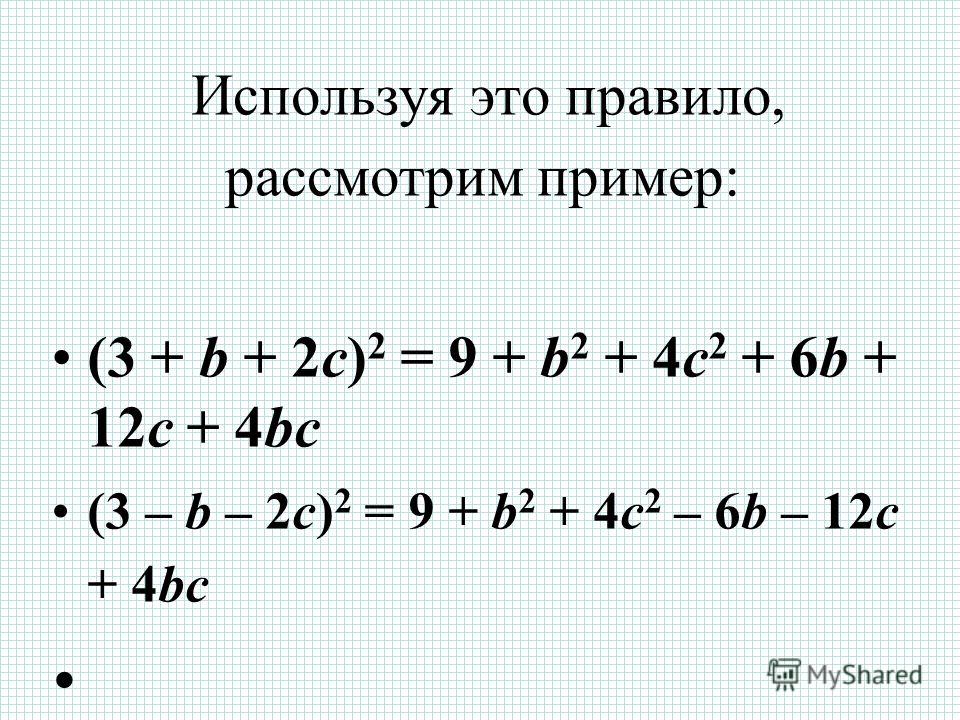

Возведение вектора в квадрат? — Математический стек Exchange

спросил

Изменено 6 лет, 9 месяцев назад

Просмотрено 100 тысяч раз

$\begingroup$

Итак, это базовый. И должно быть довольно быстро. Допустим, у меня есть вектор $\vec{r}$: 92$, когда понятно, что ты не имеешь в виду

$$

{\ bf r} {\ bf r} = \ sum_ {i, j} r_i r_j {\ bf e} _i {\ bf e} _j

$$

что равно вполне допустимой величине [1].

Что касается ${\bf r} = {\bf x} + {\bf y} + {\bf z}$, $$ \begin{выравнивание} {\bf r} \cdot {\bf r} &=& {\bf x} \cdot {\bf x} + {\bf x} \cdot {\bf y} + {\bf x} \cdot {\ bf z} + {\bf y} \cdot {\bf x} + {\bf y} \cdot {\bf y} + {\bf y} \cdot {\bf z} + {\bf z} \cdot {\bf x} + {\bf z} \cdot {\bf y} + {\bf z} \cdot {\bf z} \\ &=& {\bf x} \cdot {\bf x} + {\bf y} \cdot {\bf y} + {\bf z} \cdot {\bf z} + 2\left( {\bf x } \cdot {\bf y} + {\bf x} \cdot {\bf z} + {\bf y} \cdot {\bf z}\right) \end{эквнаррай} $$ равно ${\bf x} \cdot {\bf x} + {\bf y} \cdot {\bf y} + {\bf z} \cdot {\bf z}$ для всех $\bf x$, $ \bf y$, $\bf z$ тогда и только тогда, когда ${\bf x} \cdot {\bf y} + {\bf x} \cdot {\bf z} + {\bf y} \cdot {\bf z} = 0$ — особый случай, когда ${\bf x} \cdot {\bf y} = {\bf x} \cdot {\bf z} = {\bf y} \cdot {\bf z} = 0$. 93 {\ bf r} \ \ rho \ слева ({\ bf r} \ справа) \ слева [\ слева ({\ bf r} \ cdot {\ bf r} \ справа) {\ bf I} — {\ bf г}{\бф г}\право] $$ где $$ {\bf I} = \sum_{i,j} \delta_{ij} {\bf e}_i {\bf e}_j $$

$\endgroup$

4

$\begingroup$

Почему бы вам не разработать расширение самостоятельно. 2 + 2 \left((\vec{x} \cdot\vec{z}) +(\vec{y}\cdot\vec{z}) + (\vec{x} \cdot\vec{y}) \ справа)$$ 92$$

2 + 2 \left((\vec{x} \cdot\vec{z}) +(\vec{y}\cdot\vec{z}) + (\vec{x} \cdot\vec{y}) \ справа)$$ 92$$

$\endgroup$

$\begingroup$

Существует два основных способа умножения вектора, скалярного произведения, как показано в ссылке Скалярное произведение, которое дает скаляр, независимо от того, умножаете ли вы A.B или возводите его в квадрат, A.A.

Или у вас может быть перекрестное произведение, то есть A X B, которое дает вам другой вектор, перпендикулярный обоим перекрестным произведениям.

Причина, по которой существуют два разных способа умножения векторов, заключается в том, что они имеют дело с различными физическими ситуациями, поэтому скалярное произведение может использоваться для работы, которая является скалярной, F.D, а векторное произведение используется для крутящего момента, скажем, или углового скорости, которые являются векторами.

$\endgroup$

4

microbenchmark — Вычислить матрицу квадрата суммы в R

спросил

Изменено 1 год, 5 месяцев назад

Просмотрено 112 раз

92Есть ли в r функция, позволяющая сделать это без ручного написания?

Большое спасибо за помощь.

- r

- микротест

2

Все, что вам нужно, это внешний продукт:

v <- 1:5 внешний (v, v, '*') # [1] [2] [3] [4] [5] #[1,] 1 2 3 4 5 #[2,] 2 4 6 8 10 #[3,] 3 6 9 12 15 #[4,] 4 8 12 16 20 #[5,] 5 10 15 20 25

Сравнение различных подходов:

библиотека (микротестирование)

библиотека (ggplot2)

v <- 1:1000

mbm <- microbenchmark("outer" = { external(v, v, '*') },

"matprod" = {v%*%t(v)},

"tcrossprod" = {tcrossprod(v)})

автоплот (мбм)

На приведенном выше рисунке показано, что external() и прямое матричное произведение более эффективны, чем tcrossprod()

1

v = 1:4 tcrossprod (v) #> [1] [2] [3] [4] #> [1,] 1 2 3 4 #> [2,] 2 4 6 8 #> [3,] 3 6 9 12 #> [4,] 4 8 12 16

Создано 04.10.2021 в пакете reprex (v2.