Как работает видеокарта? Часть 1. Компоненты и взаимодействие. / zremcom.com

|

Графические карты берут данные от центрального процессора и преобразуют их в изображения. |

Изображения, которые вы видите на своем мониторе, сделаны из крошечных точек, названых пикселями. В большинстве имеющихся на сегодняшний день мониторах настройки разрешения экрана позволяют показывать более чем миллион пикселей, и компьютер должен решать, что же делать со всеми ими, чтобы создать изображение. Для выполнения этой задачи и были разработаны видеокарты, так сказать переводчики – которые берут двоичные данные от центрального процессора и превращают их в картинку, которую мы и видим на экранах своих мониторов. Почти все современные материнские платы оснащены встроенным видеоконтроллером, который хоть и способен преобразовывать графические данные, все же не сможет обеспечивать хорошую производительность в видеоиграх и 3D приложениях. Поэтому чтобы обеспечить качественную и количественную частоту кадров в секунду – высокое разрешение и скорость используют графические карты, подключаемые к материнской плате отдельно.

Работа графической карты сложна, но её принцип, и компонентный состав легко понять. В этой статье рассмотрим основные части видеокарты и их функции в процессе работы.

Давайте представим, что компьютер это компания, в штате которой состоит собственный художественный отдел. Когда люди в компании хотят получить иллюстрации или художественные работы, они посылают запрос художественному отделу. Художественный отдел решает, как создать изображение затем рисует его на бумаге, т.е. идея становится фактической, видимой картиной.

Развитие Видеокарт. Видеокарты проделали длинный путь. |

Графическая карта работает подобно тем же принципам, что и наша компания. Центральный процессор, работающий в связке с программным обеспечением, посылает информацию об изображении на видеокарту. Видеокарта решает, как расположить пиксели на экране, чтобы создать правильное изображение. После чего она посылает подготовленную информацию на монитор через соединительный кабель.

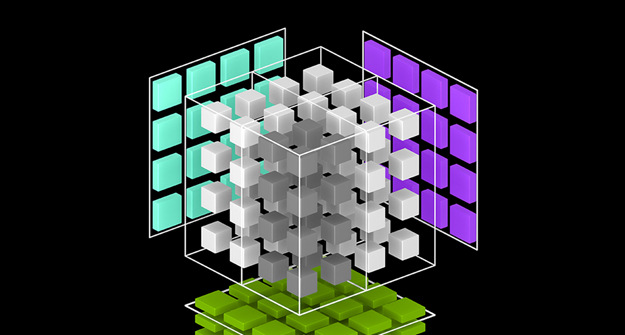

Создание изображения из двоичных данных является достаточно требовательным процессом. Например, чтобы сделать 3-х мерное изображение, графическая карта в первую очередь создает структуру изображения из прямых линий, затем проводит растрирование (заполнение пикселями), изображения, добавляет освещение, структуру и цвет. Для быстро изменяющихся видеоигр компьютер должен пройти этот процесс приблизительно шестьдесят раз в секунду. Без графической карты, чтобы выполнить необходимые вычисления, нагрузка на процессор была бы слишком большой, что бы приводило к зависанию картинки на мониторе, или другим системным сбоям.

Для выполнения своей функции графическая карта, использует четыре основных составляющих её компонента:

- Порт соединения с материнской платой (AGP, PCI-E) для передачи данных и управления.

- Процессор (GPU), чтобы решить, что сделать с каждым пикселем на экране.

- Память (VRAM), чтобы держать информацию о каждом пикселе и временно хранить сформированные изображения.

- Вывод на монитор (VGA, DVI), чтобы видеть окончательный результат обработки.

В следующей статье рассмотрим работу графического процессора и памяти видеокарты более подробно.

Как работает видеокарта — КомпЛайн

Процесс построения трехмерного изображения

Этот процесс – 3D-рендеринг – похож на создание фотографии-натюрморта: большую часть времени занимает расположение объектов в кадре, а затем делается моментальный «снимок», результаты которого выводятся на экран. В отличие от фотографии, процедура рендеринга при синтезе компьютерного изображения в реальном времени – например, в игре – повторяется несколько десятков раз в секунду (другой вариант: рендеринг производится заранее, а в итоге получается статичная картинка или видеоролик с высокой степенью реалистичности).

Исходным материалом для рендеринга является множество треугольников различного размера, из которых складываются все объекты виртуального мира: пейзаж, игровые персонажи, монстры, оружие и т.д. Однако сами по себе модели, созданные из треугольников, выглядят как проволочные каркасы. Поэтому на них накладываются текстуры – цветные двухмерные «обои». И текстуры, и модели помещаются в память графической карты, а дальше, при создании каждого кадра игрового действия выполняется цикл рендеринга, состоящий из нескольких этапов.

1. Игровая программа отправляет графическому процессору информацию, описывающую игровую сцену: состав присутствующих объектов, их окраску, положение относительно точки наблюдения, освещение и видимость. Передаются и дополнительные данные, характеризующие сцену и позволяющую видеокарте увеличить реалистичность получаемого изображения, добавив туман, размытие, блики и т.д.

2. Графический процессор располагает трехмерные модели в кадре, определяет, какие из входящих в них треугольников находятся на виду и отсекает скрытые другими объектами или, например, тенями.

Затем создаются источники света и определяется их влияние на цвет освещаемых объектов. Этот этап рендеринга называется «трансформация и освещение» (T&L – Transformation & Lighting).

3. На видимые треугольники накладываются текстуры с применением различных технологий фильтрации. Билинейная фильтрация предусматривает наложение на треугольник двух версий текстуры с различным разрешением. Результатом ее использования являются хорошо различимые границы между областями четких и размытых текстур, возникающие на трехмерных поверхностях перпендикулярно направлению обзора. Трилинейная фильтрация, использующая три варианта одной текстуры, позволяет создать более мягкие переходы.

Однако в результате использования обеих технологий по-настоящему четко выглядят лишь те текстуры, которые расположены перпендикулярно к оси зрения. При взгляде под углом они сильно размываются. Для того чтобы это предотвратить, используется анизотропная фильтрация.

Такой метод фильтрации текстур задается в настройках драйвера видеоадаптера либо непосредственно в компьютерной игре. Кроме того, можно изменять силу анизотропной фильтрации: 2х, 4х, 8х или 16х – чем больше «иксов», тем более четкими будут изображения на наклонных поверхностях. Но при увеличении силы фильтрации возрастает нагрузка на видеокарту, что может привести к снижению скорости работы и к уменьшению количества кадров, генерируемых в единицу времени.

На этапе текстурирования могут использоваться различные дополнительные эффекты. Например, наложение карт среды (Enironmental Mapping) позволяет создавать поверхности, в которых будет отражаться игровая сцена: зеркала, блестящие металлические предметы и т.д. Другой впечатляющий эффект получается с применением карт неровностей (Bump Mapping), благодаря которому свет, падающий на поверхность под углом, создает видимость рельефа.

Текстурирование является последним этапом рендеринга, после которого картинка попадает в кадровый буфер видеокарты и выводится на экран монитора.

Электронные компоненты видеокарты

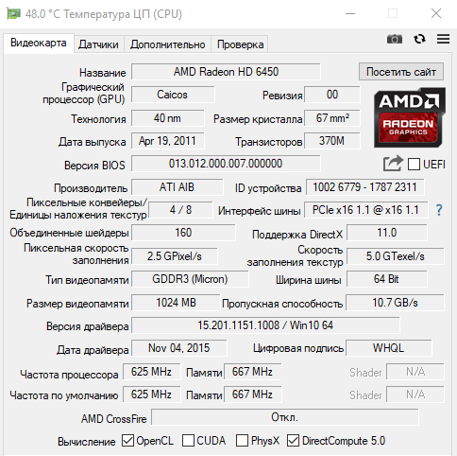

Теперь, когда стало понятно, каким образом происходит процесс построения трехмерного изображения, можно перечислить технические характеристики компонентов видеокарты, которые определяют скорость процесса. Главными составными частями видеокарты являются графический процессор (GPU – Graphics Processing Unit) и видеопамять.

Графический процессор

Одной из основных характеристик этого компонента (как и центрального процессора ПК), является тактовая частота. При прочих равных условиях, чем она выше, тем быстрее происходит обработка данных, а следовательно – увеличивается количество кадров в секунду (FPS – frames per second) в компьютерных играх. Частота графического процессора – важный, но не единственный, влияющий на его производительность параметр – современные модели производства Nvidia и ATI, имеющие сопоставимый уровень быстродействия, характеризуются различными частотами GPU.

Для адаптеров Nvidia, обладающих высокой производительностью, характерны тактовые частоты GPU от 550 МГц до 675 МГц. Частоту работы графического процессора меньше 500 МГц имеют «середнячки» и дешевые низкопроизводительные карты.

В то же время GPU «топовых» карт производства ATI имеют частоты от 600 до 800 МГц, и даже у самых дешевых видеоадаптеров частота графического процессора не опускается ниже 500 МГц.

Однако, несмотря на то, что графические процессоры Nvidia обладают меньшей частотой, чем GPU, разработанные ATI, они обеспечивают, по крайней мере, такой же уровень производительности, а зачастую – и более высокий. Дело в том, что не меньшее значение, чем тактовая частота, имеют другие характеристики GPU.

1. Количество текстурных модулей (TMU – Texture Mapping Units) – элементов графического процессора, выполняющих наложение текстур на треугольники. От количества TMU напрямую зависит скорость построения трехмерной сцены.

2. Количество конвейеров рендеринга (ROP – Render Output Pipeline) – блоков, выполняющих «сервисные» функции (пару примеров, pls). В современных графических процессорах ROP, как правило, меньше, чем текстурных модулей, и это ограничивает общую скорость текстурирования. К примеру, чип видеокарты Nvidia GeForce 8800 GTX имеет 32 «текстурника» и 24 ROP. У процессора видеокарты ATI Radeon HD 3870 только 16 текстурных моделей и 16 ROP.

Производительность текстурных модулей выражается в такой величине как филлрейт – скорость текстурирования, измеряемая в текселах за секунду. Видеокарта GeForce 8800 GTX имеет филлрейт в 18,4 млрд текс/с. Но более объективным показателем является филлрейт, измеряемый в пикселах, так как он отражает скорость работы ROP. У GeForce 8800 GTX эта величина равна 13,8 млрд пикс./с.

3. Количество шейдерных блоков (шейдерных процессоров), которые – как следует из названия – занимаются обработкой пиксельных и вершинных шейдеров. Современные игры активно используют шейдеры, так что количество шейдерных блоков имеет решающее значение для определения производительности.

Не так давно графические процессоры имели отдельные модули для выполнения пиксельных и вершинных шейдеров. Видеокарты Nvidia серии GeForce 8000 и адаптеры ATI Radeon HD 2000 первыми перешли на унифицированную шейдерную архитектуру. Графические процессоры этих карт имеют блоки, способные обрабатывать как пиксельные, так и вершинные шейдеры – универсальные шейдерные процессоры (потоковые процессоры). Такой подход позволяет полностью задействовать вычислительные ресурсы чипа при любом соотношении пиксельных и вершинных расчетов в коде игры. Кроме того, в современных графических процессорах шейдерные блоки часто работают на частоте, превышающей тактовую частоту GPU (например, у GeForce 8800 GTX эта частота составляет 1350 МГц против «общих» 575 МГц).

Обращаем ваше внимание на то, что компании Nvidia и ATI по-разному считают количество шейдерных процессоров в своих чипах. К примеру, Radeon HD 3870 имеет 320 таких блоков, а GeForce 8800 GTX – только 128. На самом деле, ATI указывает вместо целых шейдерных процессоров их составные компоненты. В каждом шейдерном процессоре содержится по пять компонентов, так что общее количество шейдерных блоков у Radeon HD 3870 – всего 64, поэтому и работает эта видеокарта медленнее, чем GeForce 8800 GTX.

Память видео карты

Видеопамять по отношению к GPU выполняет те же функции, что и оперативная память – по отношению к центральному процессору ПК: она хранит весь «строительный материал», необходимый для создания изображения – текстуры, геометрические данные, программы шейдеров и т.д.

Какие характеристики видеопамяти влияют на производительность графической карты

1. Объем. Современные игры используют огромное количество текстур с высоким разрешением, и для их размещения требуется соответствующий объем видеопамяти. Основная масса выпускаемых сегодня «топовых» видеоадаптеров и карт среднего ценового диапазона снабжается 512 Мб памяти, которая не может быть увеличена впоследствии. Более дешевые видеокарты оснащаются вдвое меньшим объемом памяти, для современных игр его уже недостаточно.

В случае нехватки памяти графический процессор вынужден постоянно загружать текстуры из оперативной памяти ПК, связь с которой осуществляется гораздо медленнее, в результате производительность может заметно снижаться. С другой стороны, чрезмерно большой объем памяти может не дать никакого увеличения скорости, так как дополнительное «место» просто не будет использоваться. Покупать видеоадаптер с 1 Гб памяти имеет смысл только в том случае, если он принадлежит к «топовым» продуктам (видеокарты ATI Radeon HD 4870, Nvidia GeForce 9800, а также новейшие карты серии GeForce GTX 200).

2. Частота. Этот параметр у современных видеокарт может изменяться от 800 до 3200 МГц и зависит, в первую очередь, от типа используемых микросхем памяти. Чипы DDR 2 могут обеспечить рабочую частоту в пределах 800 МГц и используются только в самых дешевых графических адаптерах. Память GDDR 3 и GDDR 4 увеличивает частотный диапазон вплоть до 2400 МГц. Новейшие графические карты ATI Radeon HD 4870 используют память GDDR-5 с фантастической частотой – 3200 МГц.

Частота памяти, как и частота графического процессора, оказывает большое влияние на производительность видеокарты в играх, особенно при использовании полноэкранного сглаживания. При прочих равных условиях, чем больше частота памяти, тем выше быстродействие, т.к. графический процессор будет меньше «простаивать» в ожидании поступления данных. Частота памяти в 1800 МГц является нижней границей, отделяющей высокопроизводительные карты от менее быстрых.

3. Разрядность шины видеопамяти гораздо сильнее влияет на общую производительность карты, чем частота памяти. Она показывает, сколько данных может передать память за один такт. Соответственно, двукратное увеличение разрядности шины памяти эквивалентно удвоению ее тактовой частоты. Основная масса современных видеокарт имеют 256-битную шину памяти. Уменьшение разрядности до 128 или, тем более, до 64 бит наносит сильный удар по быстродействию. С другой стороны, в самых дорогих видеокартах шина может быть «расширена» до 512 бит (пока этим может похвастаться лишь новейший GeForce GTX 280), что оказывается весьма кстати, принимая во внимание мощность их графических процессоров.

Где найти информацию о технических характеристиках видеокарты

Если графическая карта обладает некими выдающимися параметрами (высокая тактовая частота процессора и памяти, ее объем), то они, как правило, указываются непосредственно на коробке. Но наиболее полные спецификации видеоадаптеров и GPU, на которых они основаны, можно найти только в Интернете. Общая информация выкладывается на корпоративных сайтах производителей графических процессоров: Nvidia (www.nvidia.ru) и ATI (www.ati.amd.com/ru). Подробности можно узнать на неофициальных веб-сайтах, посвященных видеокартам – www.nvworld.ru и www.radeon.ru. Хорошим подспорьем станет электронная энциклопедия Wikipedia (www.ru.wikipedia.org). Пользователи, покупающие карту с прицелом на разгон могут воспользоваться ресурсом www.overclockers.ru.

Одновременное использование двух видеокарт

Для того чтобы получить максимальную производительность, можно установить в компьютер сразу две видеокарты. Производители предусмотрели для этого соответствующие технологии – SLI (Scalable Link Interface, используется картами Nvidia) и CrossFire (разработка ATI). Для того чтобы воспользоваться ими, материнская плата должна не только иметь два слота PCI-E для видеокарт, но и поддерживать одну из названных технологий. Многие «материнки» на чипсетах Intel могут использовать платы ATI в режиме CrossFire, а вот объединить в одну «упряжку» две (или даже три!) видеокарты производства Nvidia могут лишь платы на чипсетах этой же фирмы. В случае, если материнская плата не обладает поддержкой этих технологий, две видеокарты смогут с ней работать, но в играх будет использоваться только одна, а вторая лишь даст возможность выводить изображение на пару дополнительных мониторов.

Заметим, что использование двух видеокарт не приводит к удвоению производительности. Средний результат, на который стоит рассчитывать – 50% прироста скорости. Кроме того, весь потенциал тандема будет раскрыт лишь при использовании мощного центрального процессора и монитора с высоким разрешением.

Что такое шейдеры

Шейдеры – микропрограммы, присутствующие в коде игры, с помощью которых можно изменять процесс построения виртуальной сцены, открывая возможности, недостижимые при использовании традиционных средств 3D-рендеринга. Современная игровая графика без шейдеров немыслима.

Вершинные шейдеры изменяют геометрию трехмерных объектов, благодаря чему можно реализовать естественную анимацию сложных моделей игровых персонажей, физически корректную деформацию предметов или настоящие волны на воде. Пиксельные шейдеры применяются для изменения цвета пикселей и позволяют создавать такие эффекты, как реалистичные круги и рябь на воде, сложное освещение и рельеф поверхностей. Кроме того, с помощью пиксельных шейдеров осуществляется постобработка кадра: всевозможные «кинематографические» эффекты размытия движущихся объектов, сверхъяркого света и т.д.

Существует несколько версий реализации шейдерной модели (Shader Model). Все современные видеокарты поддерживают пиксельные и вершинные шейдеры версии 4.0, обеспечивающие по сравнению с предыдущей – третьей – версией более высокую реалистичность эффектов. Shader Model 4.0 поддерживается API DirectX 10 , которая работает исключительно в среде Windows Vista. Кроме того, сами компьютерные игры должны быть «заточены» под DirectX 10.

Нужна ли AGP-видеокарта старой системе

Если «материнка» вашего ПК оснащена портом AGP, возможности апгрейда видеокарты сильно ограничены. Максимум, который может себе позволить обладатель такой системы – это видеокарты серии Radeon HD 3850 фирмы AMD (ATI).

По современным меркам, они обладают производительностью ниже среднего. Кроме того, подавляющее большинство материнских плат с поддержкой интерфейса AGP предназначено для устаревших процессоров Intel Pentium 4 и AMD Athlon XP, так что общее быстродействие системы все равно будет недостаточно высоким для современной трехмерной графики. Только на материнские платы для процессоров AMD Ahtlon 64 с разъемом Socket 939 стоит устанавливать новые видеокарты с портом AGP. Во всех остальных случаях лучше купить новый компьютер с интерфейсом PCI-E, памятью DDR 2 (или DDR 3) и современным ЦП.

Теги материала: графическая карта, видео, карта, ускоритель, графики

Не играми едиными. Ускорение программ с помощью видеокарты | Видеокарты | Блог

Что такое видеокарта, знает каждый, ведь это главный элемент ПК, отвечающий за игры. И чем он мощнее, тем лучше. Однако в словосочетание «графический адаптер» вложено намного больше смысла. И кроме умения отапливать помещение и жрать электроэнергию «майнить» видеокарты способны ускорять работу некоторых полезных программ. В их число входят приложения для видеомонтажа, графического дизайна, 3D-моделирования, VR-разработок.

Техническая сторона вопроса

Обычно основная часть нагрузки ложится на центральный процессор. Но есть задачи, с которыми GPU справится во много раз быстрее, и было бы глупо этим не воспользоваться. Логично, что чаще всего это касается программ для работы с графикой, видео и 3D-моделированием.

Во время GPU-ускорения задействуется исключительно память видеокарты. Для простой работы с FHD достаточно 2 ГБ. Однако, когда один кадр компонуется из нескольких (картинка в картинке) или используются эффекты, одновременно обрабатывающие несколько кадров (шумодавы и т. д.), расход возрастает. Для UHD/4K-видео необходимо уже минимум 4 ГБ видеопамяти.

Конечный прирост производительности зависит от правильности настройки и общих параметров системы. В случае, например, рендеринга иногда разница с CPU составляет разы, а это сэкономленное время, которое, как известно, — деньги. Гарантировать точный результат ускорения не возьмется ни один производитель, ссылаясь на индивидуальность каждой системы.

Любая видеокарта в той или иной степени способна проводить сложные вычисления и обрабатывать графику. Больше других акцентирует внимание на неигровых возможностях и технологиях своих GeForce компания nVidia.

Тензорные ядра — присутствуют в адаптерах серии RTX, повышают производительность и энергоэффективность. Поддержка ИИ ускоряет расчеты и работу с графикой.

CUDA — проприетарная технология nVidia, доступная для устройств GTX и RTX. Позволяет использовать графический процессор для вычислений общего назначения, улучшает работу с фото, видео и 3D.

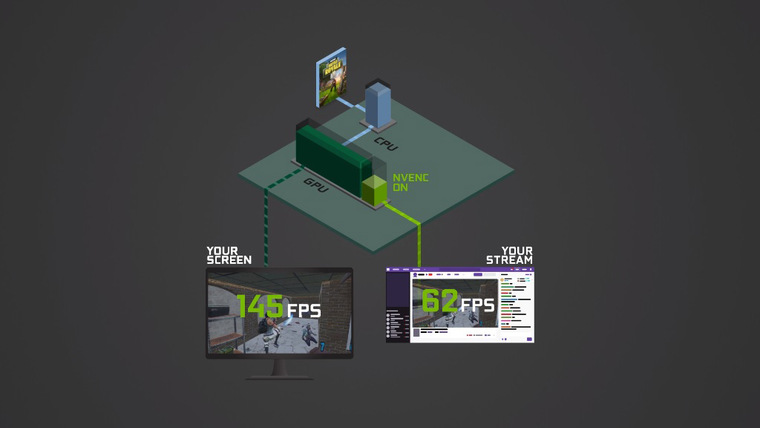

NVENC — отдельный аппаратный блок, способный кодировать и декодировать видеопоток. Благодаря этому разгружаются центральный и графический процессоры для запуска игр и других ресурсоемких задач. В первую очередь это интересно стримерам, но многие программы видеомонтажа уже приспособили NVENC под себя.

NVIDIA STUDIO DRIVER — выходит для видеокарт серии 10хх и моложе. Оптимизирует работу адаптера под такие приложения, как Autodesk Maya, 3ds Max, Arnold 5, DaVinci Resolve и т. д.

Карты AMD тоже хорошо справляются с вычислениями и обработкой графики, но любит говорить об этом исключительно компания Apple. AMD использует открытые технологии OpenGL и Vulcan — альтернативу CUDA.

Программы, работающие с GPU-ускорением

О возможности ускорения программы с помощью видеокарты можно узнать на официальном сайте. Все ведущие производители софта дают четкие инструкции, какая видеокарта подойдет и как включить GPU-ускорение. А первое, что приходит на ум, когда речь идет о работе с графикой и видео, — решения студии Adobe.

Adobe Premiere Pro использует вычислительные ресурсы видеокарт, начиная с версии CS5. Текущие версии для Windows поддерживают все современные GPU (включая встроенную графику Intel). CS6 и выше имеют функцию стабилизации видео Warp Stabilizer, которая устраняет дрожание камеры. Плагин использует GPU-ускорение только при финальном рендеринге изображения. Также в CS6 появился рендер Ray-traced 3D, который обсчитывает на видеокарте 3D-слои, камеру и источники света в композиции. Adobe Premiere CC научился работать одновременно с несколькими видеокартами, причем допускается использование разных серий и даже производителей (MultipleGPU). Выигрыш зависит от общей конфигурации ПК. Интересные возможности дает использование GPU сторонними плагинами. Можно ускорять Premiere при помощи CUDA одной видеокарты, при этом его плагин будет ускоряться OpenGL другой видеокарты. Такие плагины, как Magic Bullet Looks, Elements3D и т. п. могут использовать ресурсы GPU независимо от настроек Adobe. Подробные требования приложения к видеокарте можно найти на официальном сайте.

- Adobe After Effects предъявляет к видеокартам аналогичные с предыдущим клиентом требования.

Adobe Photoshop также активно использует видеокарты в процессе обработки изображений. Фоторедактор закрывает некоторые свои возможности, если видеокарта их не поддерживает. Яркими примерами таких функций являются «Деформация перспективы», «Умная резкость», «Размытие». Пользователю доступны три режима: базовый, обычный и расширенный. Наиболее интенсивно использует видеокарту последний. Если наблюдается снижение быстродействия, стоит переключиться на уровень ниже, воспользовавшись вкладкой Дополнительные параметры.

Кроме продукции компании Adobe нельзя не вспомнить такие программы, как 3ds Max, DaVinci Resolve и Vegas Pro.

Данные о поддержке наиболее адаптированных приложений производители видеокарт публикуют на своих официальных сайтах:

eGPU — внешний графический процессор

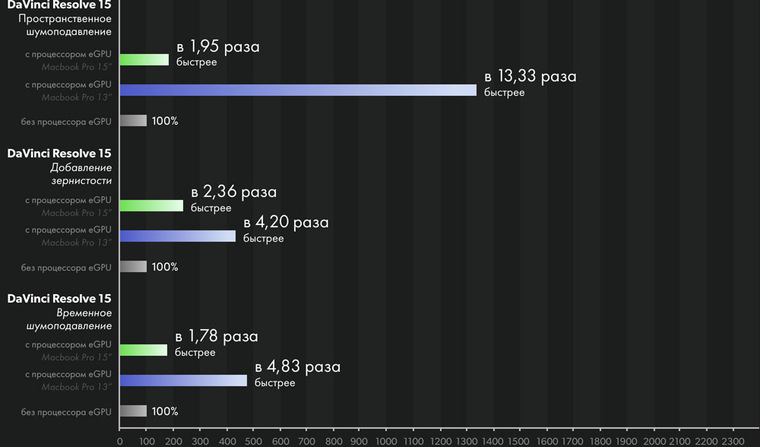

Этот раздел касается в первую очередь техники компании Apple. Купертиновцы любят делать упор на творческие возможности своих устройств, однако пользователи макбуков и аймаков ограничены исходной комплектацией. На помощь приходит eGPU — внешняя видеокарта, с помощью которой, по заявлению производителя, можно увеличить скорость обработки графики на Mac в несколько раз.

По сути, это обычная видеокарта в специальном боксе с блоком питания и дополнительным охлаждением. Она подключается к макам посредством Thunderbolt 3. Уже много лет Apple использует видеокарты AMD, и весь софт Apple затачивается под новый API Metal. Графические решения nVidia ощутимого прироста производительности на Apple не дают, так как из-за патологической жадности компании не смогли договориться, и весь софт на маке заточен исключительно под AMD. В отместку nVidia недавно полностью отменила поддержку CUDA на MacOS.

А что могут «профи»?

Есть заблуждение, что для работы с графикой нужно купить максимальную видеокарту, а процессор любой сойдет. Это не так. Если процессор не будет успевать давать задания видеокарте, пользователь столкнется с простоем в ресурсоемких задачах. Есть и обратная зависимость: слабая видеокарта может сдерживать процессор в финальном рендеринге. Важен баланс. Если потребности пользователя все же переросли возможности обычных моделей, можно направить свой взгляд на дорогие и узкоспециализированные решения. Технически профессиональные и потребительские видеокарты отличаются несильно, все дело в ПО.

Несколько лет назад компания nVidia выпустила первый TITAN — запредельную по производительности и цене игровую видеокарту. Но вместо того, чтобы стать нишевым продуктом, она была буквально сметена с прилавков. Оказалось, что карта прекрасно справляется с расчетами, и многие компании с удовольствием покупали ее вместо дорогих про-аналогов. Разумеется, nVidia быстро смекнула, в чем дело, и в начале 2018 года прикрыла лавочку запретила использовать графические процессоры GeForce и Titan в составе дата-центров. По словам nVidia, нельзя гарантировать их безотказную работу в жарких условиях (и это не фигуральный оборот) в режиме 24/7. В качестве альтернативы предлагается использовать, например, Tesla V100, который гораздо мощнее GeForce и стоит в десять раз больше создан специально для работы в условиях ЦоД.

nVidia имеет три линейки профессиональных видеокарт: Quadro, NVS и Tesla.

- Quadro — служит для рендеринга видео, производства VR/AR, 3D-моделирования. Быстрые и дорогие. Чтобы оправдать стоимость, производитель оснащает их самыми современными и совершенными разработками, которые появятся только в следующих сериях GeForce. Для очень богатых дизайнеров и инженеров.

NVS — многопортовые карточки, созданные для подключения большого количества мониторов в одну панель. Например, с их помощью в Макдональдсе можно выбрать бигмак с помидорами или беконом, а в аэропорте найти свой рейс. По сути, это самая обычная «затычка», на которой распаяли много портов. Очень слабые по железу и очень дорогие по соотношению цена/производительность, но ценят их не за FPS в Батле.

Tesla — узкоспециализированная и сверхдорогая линейка для математических и физических расчетов. Для работы требуется CPU. Портов нет, поиграть нельзя, расходимся пацаны.

Компания AMD в качестве профессионального решения предлагает серию Radeon Pro. Также у них есть вычислительные аналоги Tesla с космическим ценником под названием Instinct.

7 распространенных ошибок при выборе видеокарты | Видеокарты | Блог

Естественное желание каждого покупателя — получить максимум отдачи от приобретенного товара. То есть — выбрать из конкурирующих решений наиболее качественное, функциональное, либо просто в большей степени соответствующее вкусам нового владельца.

Это стремление логично и не нуждается в каких-либо пояснениях. Но парадокс заключается в том, что чем более технологичным (а следовательно — более дорогостоящим и менее регулярно приобретаемым) является товар — тем в меньшей степени покупатели склонны оценивать его первостепенные характеристики, обращая внимание на менее значимые моменты или вовсе сводя покупку в область эмоций.

Комплектующие для компьютера — в частности, видеокарты, — отнюдь не исключение из этого правила. Ошибок при их выборе совершается немало, и в данной статье мы постараемся осветить основные из них.

Нужно ли смотреть на объем памяти?

К сожалению, фразы вроде «фу, у этой карты 4 гигабайта, на ней только в пасьянс играть!», «у этой видеокарты всего 6 гигабайт памяти, я лучше возьму вот эту — у ней сразу 8!» или бессмертное «у меня карта на 8 гигабайт, эта игрушка на ультра летает!» буквально заполоняют компьютерные форумы, карточки товаров в интернет-магазинах, социальные сети и прочие смежные ресурсы.

Принято считать, что чем больше у карты набортной памяти — тем выше ее производительность, а прочие характеристики либо второстепенны, либо вовсе не имеют значения.

На самом деле, конечно же, это не так.

Набортная память видеокарты сама по себе не влияет на производительность — это всего лишь хранилище для используемых видеокартой данных. И фраза о преимуществах видеокарты с 8 гигабайтами набортной памяти над картой с 6 гигабайтами звучит буквально как «автомобиль с багажником на 500 литров быстрее, экономичнее, комфортнее и лучше в управлении, чем автомобиль с багажником на 350 литров».

Иначе говоря — представляет собой полный абсурд.

Во-первых, производительность видеокарты определяется в первую очередь характеристиками ее ГПУ: количеством исполнительных блоков, архитектурными особенностями, рабочими частотами. Говоря проще — при одинаковом объеме набортной памяти (6 гигабайт), бюджетная GeForce GTX 1660 никогда не будет равна GeForce RTX 2060, стоящей на пару ступеней выше в линейке продуктов.

Но в качестве наглядного примера мы рассмотрим другие карты аналогичных классов:

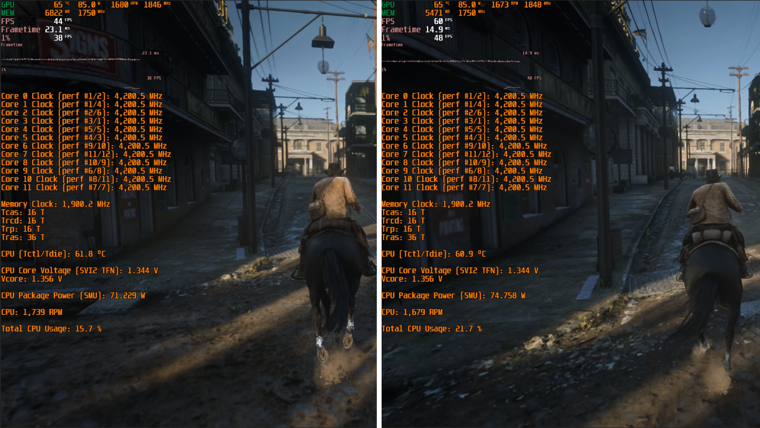

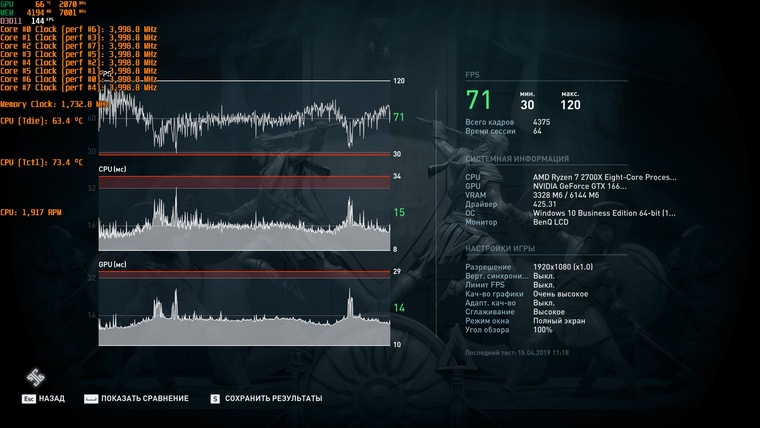

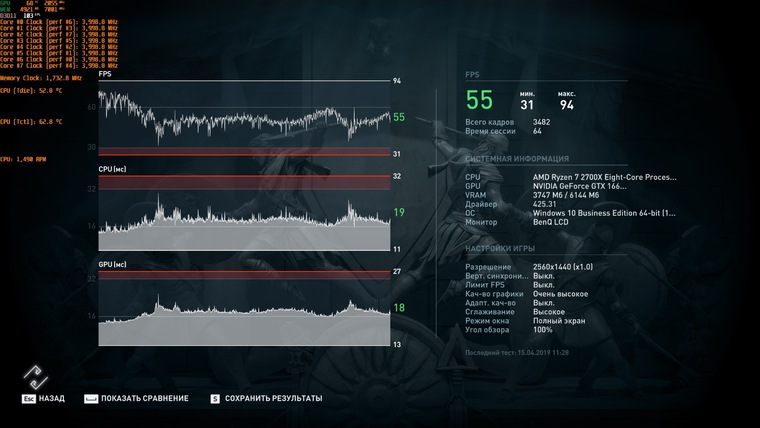

Встроенный бенчмарк игры Assassin’s Creed: Odyssey запущен в разрешении FullHD с настройками графики, соответствующими штатному профилю «Высокое качество». Конфигурация ПК полностью идентична, за исключением самих видеокарт.

Слева — Radeon RX 5600 XT в исполнении Sapphire с типичными для этой модели 6 гигабайтами набортной памяти.

Справа — Radeon RX 5500 XT в исполнении MSI в версии с 8 гигабайтами набортной памяти.

Частоты видеокарт, в отличие от ЦПУ и оперативной памяти, не приведены к общему знаменателю, но в данном случае этого и не требуется — разница и без того очевидна.

В первом случае по итогу тестовой сцены мы получаем 74 кадра по среднему фпс, 62 кадра по минимальному и просадки до 59 кадров в 1% редких событиий. Во втором — 60, 50 и 48 кадров соответственно.

Так какая карта оказывается быстрее — с 6 или с 8 гигабайтами памяти на борту?

Во-вторых, как уже говорилось выше, память видеокарты — это хранилище данных. А размеры любого хранилища рассчитываются исходя из объема содержимого, которое в него планируется поместить. В случае видеокарты — исходя из объема памяти, который реально задействуют игры. А требования игр — отнюдь не константа, они находятся в прямой зависимости от разрешения экрана и настроек графики. Говоря проще — одна и та же игра на высоких и на средних настройках будет обладать совершенно разными аппетитами.

Рассмотрим следующий пример:

Red Dead Redemption 2, одна из самых требовательных игр последних лет. Здесь используется одна и та же видеокарта — Radeon RX 5500 XT 8gb в исполнении MSI.

В чем же разница?

Слева используются высокие настройки графики, справа — средние. Разрешение в обоих случаях — FullHD.

Мониторинг позволяет увидеть, что на высоких настройках используется до 6900 мегабайт набортной памяти, так что 8 гигабайт, чтобы поиграть в RDR 2 на высоких, — вполне реальная необходимость. На средних же потребление памяти снижается до 5500 мегабайт — так что карт с 6 гигабайтами памяти на борту для этих настроек тоже хватит. Однако есть одно большое «НО».

C RX 5500 XT, пусть у него и есть необходимые 8 гигабайт памяти, на высоких настройках мы получаем 45 кадров по среднему фпс, 38 — по минимальному и просадки до 36 кадров в 1%.

Бесспорно, многие назовут этот режим играбельным, но, если подходить к вопросу объективно — для по-настоящему комфортного геймплея настройки следует понижать.

На средних же настройках с тем же RX 5500 XT мы получаем 61, 52 и 49 кадров соответственно. Эти показатели как раз и можно назвать комфортными.

Вывод из примеров выше будет следующим:

Объем памяти — важный параметр, но учитывать его необходимо не в отдельности, а только и исключительно в комплексе всех прочих характеристик видеокарты.

Да, в реалиях сегодняшнего дня, даже если вы выбираете видеокарту для игр в самом ходовом разрешении FullHD, следует ориентироваться на карты с объемом памяти в 6 и 8 гигабайт, НО — только в том случае, если выбранная вами карта способна обеспечить комфортный фпс в интересующей вас игре на тех настройках, где эти 6 или 8 гигабайт реально потребуются.

Если же вас интересуют сетевые игры со сравнительно простой графикой, если вы планируете играть в игры не последних лет выпуска, либо если выбирается очень бюджетное решение, способное тянуть тяжелые новинки только на средневысоких настройках — нет смысла гнаться за большим объемом памяти. Во всех этих случаях либо реальное потребление памяти в игре будет сравнительно низким, либо производительность упрется в возможности ГПУ, а не памяти карты.

Так ли важны характеристики разрядности шины памяти или частоты в отдельности?

Этот и последующий пример можно охарактеризовать так же, как и вопрос с объемом памяти видеокарты. А именно — как стремление не рассматривать характеристики продукта не в комплексе, а максимально упростить их, сведя лишь к одному параметру.

Тезисы, разумеется, здесь звучат максимально похоже: «как можно выпускать в 2020 году обрезок со 128-битной шиной?», «да тут всего 192 бита, а еще в прошлом поколении было 256 — я лучше возьму старую карту, она явно быстрее!» и так далее.

Во-первых, помимо ширины шины памяти, есть такие понятия как рабочие частоты и тип памяти. Итоговую пропускную способность подсистемы памяти эти характеристики формируют не по отдельности, а в комплексе. И современные чипы GDDR6 даже на 128-битной шине могут обеспечить те же, или близкие значения к показателям GDDR5 на 256-битной шине.

224 гигабита в секунду против 256 — совсем не та разница, которую следовало бы ожидать, говоря о вдвое «снизившейся» ширине шины памяти.

Однако, во-вторых, сводя все к одному параметру, пусть даже он является комплексным, мы совершаем ровно ту же ошибку, что и рядовые покупатели. Пропускная способность интерфейса описывает лишь максимальный объем данных, который теоретически можно передать за единицу времени.

Ключевое слово здесь — теоретически. На практике же значение имеет архитектура ГПУ и предполагаемые ей алгоритмы сжатия данных.

Рассмотрим очередной практический пример:

Metro: Exodus, встроенный бенчмарк. Разрешение — FullHD, настройки графики — высокие, тесселяция включена, технологии Hairworks и Advanced PhysX — выключены.

Слева — Radeon RX Vega 56, использующий скоростную память типа HBM2 на 2048-битной шине. Справа –GeForce RTX 2060, с типичной для нее GDDR6 на 192-битной шине.

Казалось бы, при таких вводных данных разница в пользу первого решения должна быть очевидной, но на самом деле с Vega56 по итогу теста мы получаем 67 кадров по среднему фпс и 35 — по минимальному, а с RTX 2060 — 66 и 35 кадров соответственно.

Видеокарта — это крайне сложное и технологичное устройство, буквально «компьютер в компьютере», оснащенный собственным процессором, собственным объемом памяти и интерфейсами для передачи данных. И, как у любого компьютера, у видеокарты есть своя архитектура и свой софт, использующий ее преимущества. Поэтому любой параметр, касающийся характеристик видеокарты, нельзя рассматривать в отдельности, а уж тем более — делать какие-то выводы, основываясь исключительно на одном этом параметре.

Впрочем, не совсем так.

Есть один параметр, который действительно может определять и описывать абсолютно все, и согласно которому можно расставлять видеокарты по умозрительной лестнице предпочтений. И это, как легко догадаться — производительность карты в реальных играх.

Корректно ли сопоставлять количество функциональных блоков чипа при сравнении видеокарт разных поколений и от разных производителей?

Характеристики графического процессора, как и центрального процессора компьютера, определяются в первую очередь его частотой и количеством исполнительных блоков — т.е. универсальных шейдерных процессоров, текстурных блоков и блоков растровых операций.

И, как в случае центральных процессоров 6 ядер на частоте в 4000 МГц будут быстрее 4-х ядер на 3400 МГц, так и в случае ГПУ — чем выше частота и больше блоков, тем выше производительность. Однако, тут тоже есть свое большое «НО».

Как и ЦПУ, графические ядра видеокарт можно сравнивать «по цифрам» только в рамках одного поколения и одной архитектуры. Например, Radeon RX 580 с его 2304 процессорами, 144 TMU и 32 блоками ROP будет всегда быстрее RadeonRX 570, характеристики которого можно записать по формуле 2048/128/32.

Но вот когда заходит речь о картах разных поколений или разных производителей — стоит всегда иметь ввиду, что первостепенное значение имеет архитектура, а не частота или количество блоков. Так, карта нового поколения может иметь 2300 универсальных процессоров, а карта предыдущего поколения — все 3600, но в реальных играх полуторакратной разницы вы не увидите:

World of Tanks — правда, уже довольно старой на сегодня версии 1.5.1.3, актуальной на момент проведения тестов. FullHD, настройки графики — ультра.

Слева — Radeon RX 5700, располагающий 2304 универсальными процессорами, 144 текстурными блоками и 64 блоками ROP.

Справа — Radeon RX Vega 56, его прямой предшественник. 3584, 224 и 64 блока соответственно.

Разумеется, частота ГПУ у новинки немного выше, но 240–250 МГц не могли бы обеспечить столь заметный отрыв в производительности при такой разнице в количестве исполнительных блоков. А вот новая архитектура — еще как может!

Оценивать по количественным параметрам и сравнивать между собой можно только видеокарты одного поколения. Если же говорить о картах на принципиально разной архитектуре — можно прийти к условной ситуации, в которой есть некий чип с 1000 универсальных процессоров и его более старый аналог, у которого их 1500.

Казалось бы, второй вариант будет гарантированно быстрее, но вот незадача: 1500 процессоров на старой архитектуре могут выполнять лишь 2 инструкции за каждый такт, а каждый из 1000 новых процессоров — все 4 инструкции.

Пример, разумеется, полностью умозрительный, и аллюзий на реальные графические чипы не предполагающий. Но суть он передает верно.

Как не ошибиться при расчете питания?

Как и любые другие комплектующие, для своей работы видеокарты требуют определенное количество электроэнергии. Соответственно, встает вопрос о том, с помощью чего запитать видеокарту, планируемую к покупке. И в этом случае могут иметь место две крайности:

- Либо пользователь учитывает только заявленную мощность имеющегося блока питания, не обращая внимания на его реальные характеристики и фактическое состояние (в лучшем случае — задается вопрос «а подойдет ли блок на 500 ватт к этой видеокарте?»).

- Либо потенциальный владелец новинки бросается в другую крайность — приобретает новый блок питания заведомо избыточной мощности, при том что уже имеющийся у него блок тоже легко справился бы с задачей.

В обоих этих случаях пользователь оказывается в проигрыше. Поэтому, чтобы не потратить лишних денег и не получить заведомо нестабильную систему, нужно обязательно помнить следующее:

— Блок питания выбирается не «под видеокарту», а под всю систему в целом.

Видеокарта — это только один из составляющих элементов. Помимо нее, в системном блоке также проживают центральный процессор, жесткие диски, оперативная память, материнская плата и, возможно, какие-то платы расширения вроде звуковой карты. Все они в работе также потребляют какое-то количество ватт, и их также нужно учитывать при выборе блока питания.

— Указанная на вашем блоке мощность не обязательно есть в нем фактически.

Качество блоков питания — довольно скользкая тема, и касаться ее в рамках данной статьи мы не будем. Но все же — напомним, что условный блок на 500 ватт, выпущенный в 2010 году и активно эксплуатировавшийся до сегодняшних дней, и современный блок на те же 500 ватт, в реальных замерах выдадут совершено разную мощность. Поэтому, при расчетах совместимости оперировать нужно не цифрами с этикетки, а реальными моделями блоков питания и их фактическим состоянием.

— Фактическое энергопотребление видеокарты и рекомендуемая мощность блока питания — разные вещи.

В характеристиках видеокарт. Указанных на сайтах производителей и в карточках магазинов, можно обнаружить такой параметр, как «рекомендуемая мощность БП». Некоторые часто путают ее с энергопотреблением видеокарты, что и порождает «авторитетные советы» приобретать блоки мощностью 800 ватт к бюджетным видеокартам вроде GTX 1650 — GTX 1660 — RX 5500 XT.

На самом деле, производители видеокарт как раз прекрасно знают предыдущие два тезиса. И рекомендуемая ими мощность — это как раз мощность для ВСЕЙ системы с установленной в нее видеокартой. Более того — мощность эта намеренно завышена, поскольку тем самым производитель защищает себя от претензий со стороны владельцев низкокачественных БП.

Так как определить реальное энергопотребление интересующей вас видеокарты?

Проще всего — прочесть обзор на нее от авторитетного источника. Да, нередко в обзорах указывается энергопотребление всей системы, а не отдельно видеокарты — но так получается даже более наглядно. Ведь, если тестовая система на условном Core i9-9900K в разгоне показывает пиковое энергопотребление на уровне 580 ватт, то ваш компьютер с опять же, условным Core i5-9400F есть будет очевидно меньше.

Впрочем, если в вас вдруг проснется азарт исследователя, можно пойти и более сложным путем.

Одной из основных характеристик современных видеокарт является лимит энергопотребления. Это программное ограничение (аппаратным может являться, разве что, конфигурация разъемов дополнительного питания), по достижении которого видеокарта начинает сбрасывать частоты и понижать напряжения, чтобы остаться в обозначенных пределах.

К примеру, если видеокарта имеет лимит на 130 ватт, то без разгона и ручного поднятия лимита больше есть она не будет — как бы различные «интернет-знатоки» ни советовали вам покупать для нее блоки мощностью 800 ватт минимум.

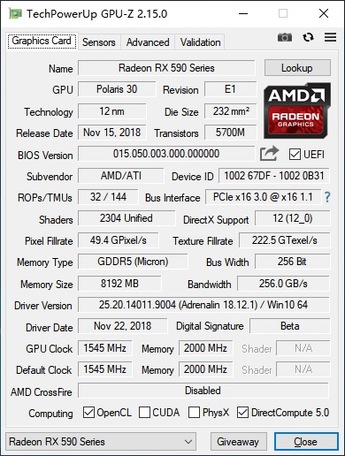

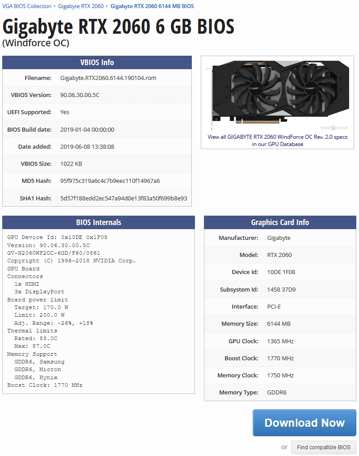

А поскольку ограничение это программное — узнать его можно напрямую из биос видеокарты. Для этого нужно либо скачать файл и открыть его диагностической утилитой, либо обратиться, например, к базе данных портала Techpowerup.

Слева — отчет утилиты MorePowerTool о лимитах видеокарты Sapphire Radeon RX 5600 XT Pulse. Лимит энергопотребления для ГПУ составляет 160 ватт. Остальные элементы в данном случае не учитываются, однако их потребление существенно ниже чем у ГПУ, для простоты можно округлить до 30–40 ватт.

Справа — информация о видеокарте Gigabyte GeForce RTX 2060 Windforce OC из базы данных Techpowerup. Здесь уже приводится общий лимит энергопотребления, и он составляет 200 ватт.

Разумеется, лимит энергопотребления — это именно пиковое значение, в реальных задачах видеокарта не всегда будет потреблять максимальное количество электроэнергии, но при расчетах мощности БП следует учитывать именно возможный максимум.

И, конечно же, надо помнить, что при разгоне видеокарты лимит энергопотребления вам придется повышать — а, следовательно, нужно закладывать некоторый запас сверх штатного значения. Опять же, здесь поможет изучение характеристик биос карты — так, на примере выше видно, что для конкретно этой версии RTX 2060 штатными средствами лимит можно поднять лишь на 18%.

При расчетах мощности блока питания для вашей системы следует учитывать всего два фактора: реальное энергопотребление ваших комплектующих и не менее реальные характеристики вашего БП. И с первым, и со вторым поможет вдумчивое изучение обзоров.

В крайнем случае — можно просто сравнить энергопотребление видеокарты, которую вы планируете приобрести, с той, которая стоит в вашем системном блоке сейчас. Хотя современные микросхемы и более сложны, их аппетиты вполне могут оказаться ниже, чем у предшественников.

Важно ли подбирать видеокарту под конкретный процессор?

Сегодня вопросы вроде «а подойдет ли эта видеокарта к моему процессору?» по своему количеству и частоте задавания уже уверенно обходят вопросы совместимости с блоками питания. Можно предположить, что здесь действительно есть какие-то тонкости, однако на самом деле это не так.

Если вопрос касается именно совместимости системы с видеокартой — то модель и семейство установленного процессора ее не определяют. Более того: как правило, если видеокарта использует интерфейс PCI-e и поддерживается в установленной на компьютере ОС — это все, что от нее требуется.

Иначе говоря, если вы собираете ПК на новой платформе, но бюджет не позволяет сразу приобрести видеокарту актуального поколения — можно использовать карту, оставшуюся от предыдущей системы, или бюджетное решение старого поколения, купленное на вторичном рынке.

И обратное тоже верно: в компьютеры, собранные на не самых новых платформах, можно устанавливать видеокарты актуальных поколений, если вам не хватает производительности графической части, или бюджет позволяет заменить только видеокарту.

Встроенный бенчмарк игры Assassin’s Creed: Odyssey утверждает, что тестовая система объединяет процессор Intel Corei7-4930K, выпущенный в 2013 году для уже давно устаревшей платформы LGA 2011, и видеокарту GeForce RTX 2080 Ti, выпущенную в конце 2018 года, и актуальную до сих пор.

Причем, разумеется, пример выше — далеко не единственный. При желании в Интернете можно найти множество сборок даже на более старых процессорах — к примеру, Core i5/i7 Sandy Bridge и FX Piledriver, объединенных с современными видеокартами. И не только в виде статичных картинок, но и видеороликов, посвященных сборке и тестированию получившихся систем.

Безусловно, бывают случаи индивидуальной несовместимости, когда видеокарта напрочь отказывается инициализироваться и работать, хотя сама она гарантированно исправна. Но, во-первых, в современных реалиях это большая редкость, а во-вторых, вопросы в данном случае следует адресовать к материнской плате, а не к процессору.

Однако речь может идти не просто о совместимости и возможности эксплуатировать систему с новой видеокартой, но и об итоговой производительности получившегося компьютера в играх. И здесь все уже отнюдь не так просто.

Мифы о «раскрывашках»

«Раскрывашки», наиболее активно нервировавшие интернет-сообщество в период с 2014 по 2018 год, сегодня уже являются в большей степени забавным мемом и поводом для шуток, нежели серьезной проблемой. Однако и сейчас изредка проскакивают вопросы вроде «а раскроИт ли?», в которых потенциальные владельцы новых видеокарт желают знать, насколько быстрой окажется их система после апгрейда.

Согласно популярному заблуждению, к новым и быстрым видеокартам обязательно приобретать процессоры новых поколений. Причем чем выше будет индекс модели — тем лучше для производительности. Хотя реальные системные требования игр, как и соотношение производительности уже имеющегося у пользователя процессора с рекомендуемой ему моделью значения здесь никакого не имеют.

Если же пользователь не желает приобретать новый процессор (разумеется, вместе с полагающейся к нему материнской платой и в некоторых случаях — оперативной памятью), ему заявляется, что и в апгрейде видеокарты нет никакого смысла, ведь работать она будет на уровне младших моделей той же линейки, а то — и вовсе так же, как и старая видеокарта.

Разумеется, все это — крайности, доведенные до абсурда. И ключевая задача любой «раскрывашки» — не помочь, а именно убедить пользователя потратить деньги на новое железо помимо видеокарты. Чего ему, возможно, вовсе и не надо делать.

В реальности, конечно, процессор оказывает существенное влияние на производительность системы. Но, во-первых, не он один, а во-вторых — влияние это не во всех играх одинаково, и уж точно не определяется индексом модели процессора.

Рассмотрим несколько примеров.

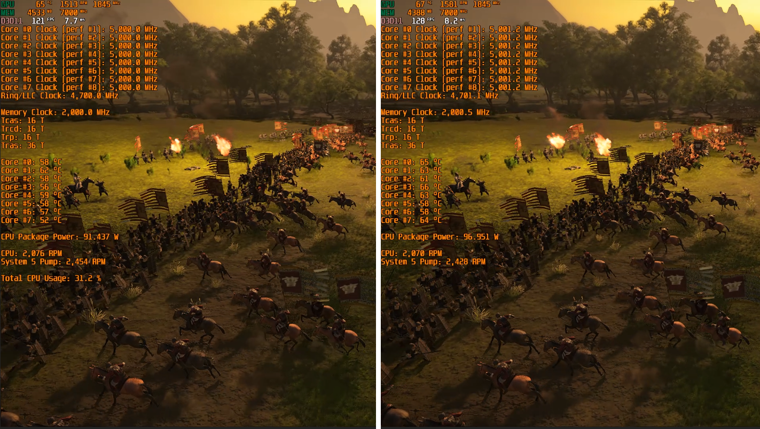

Total War: Three Kingdoms. Игра, довольно требовательная к ресурсам центрального процессора и к тому же — использующая преимущества многопотока.

Слева — Intel Core i9-9900KF. Справа — Intel Core i7-9700KF. Оба процессора разогнаны до 5000 МГц, частота кольцевой шины поднята до 4700 МГц, видеокарта RTX 2080 Ti работает в штатном для нее режиме, все прочие условия идентичны.

При этом, в случае с Core i7-9700KF фпс в бенчмарке оказывается… выше!

Да, это исключительно частный случай, связанный с тем, что технология Hyper Threading, отличающая Core i9 от Core i7, в играх далеко не всегда работает корректно, и производительность старшей (!!!) модели ЦПУ при прочих одинаковых условиях оказывается ниже, чем у младшей.

Встроенный бенчмарк игры WarThunder, являющейся уже диаметрально противоположным примером. Движок игры по сей день активно использует не более 2-х ядер.

Слева — снова Core i9-9900KF, но на сей раз — в номинальном для него режиме. 4700 МГц по всем ядрам за счет технологии MCE, 4300 МГц на кольцевой шине. Справа — уже Core i5-9600KF, разогнанный ровно до тех же параметров. Все прочие характеристики системы идентичны, в качестве видеокарты опять используется RTX 2080 Ti.

Разница в фпс, опять же, в комментариях не нуждается. В данном случае Core i9 в принципе не может иметь никаких преимуществ над Core i5 — игра попросту не использует «лишние» ядра. А технология Hyper Threading здесь опять ведет себя не лучшим образом, что и позволяет Core i5-9600KF выдавать немного больше кадров в секунду.

И это далеко не единственные примеры, категорически не вписывающиеся в картину мира, предлагаемую раскрывашками.

В реальности у каждой игры свои требования к характеристикам центрального процессора. Так, где-то используется максимально доступное количество ядер — и, например, старые процессоры под ту же платформу LGA 2011 могут не только эффективно справляться с игрой, выпущенной на 7 лет позже них самих, но и обеспечивать более комфортный геймплей, чем современные модели под LGA 1151_v2.

Где-то — наоборот, количество ядер не имеет значения, важна только тактовая частота и производительность в однопоточной нагрузке. Какие-то игры в силу особенностей движка в принципе мало зависимы от процессора и более требовательны к видеокарте. Да и сама «зависимость» от характеристик процессора в одной и той же игре может меняться со сменой разрешения экрана и настроек графики: чем они выше — тем выше влияние видеокарты, и менее заметна разница между более и менее быстрыми ЦПУ.

Раскрывашки же эти факты игнорируют и сводят все к одному простому тезису: «более дорогой и новый процессор — лучше». Но для кого именно лучше — обычно умалчивают.

Заключение

Конечно, в данной статье мы рассмотрели лишь часть распространенных ошибок, совершаемых при выборе видеокарт. Если начинать рассматривать отдельные семейства — да что там, даже отдельные ценовые сегменты! — то легенд и мифов можно будет обнаружить великое множество.

Но и эти, и любые другие мифы рождаются там, где нет четкого знания и подтвержденной информации. Выдумка, изложенная максимально просто и понятно, всегда будет более притягательна, чем факты, которые нужно изучать, анализировать и сопоставлять. Однако опираться на выдумки никогда не стоит.

Если вы хотите получить товар, максимально отбивающий свою цену — стоит сперва потрудиться и изучить сведения о нем сразу в нескольких авторитетных источниках, а не следовать первой попавшейся на глаза рекомендации.

Как разогнать видеокарту и зачем это делать | Видеокарты | Блог

Ответ на вопрос «Зачем?» можно свести к одной простой фразе: чтобы повысить производительность.

Производительность компьютерных комплектующих, определяется количественными характеристиками. В случае с рабочими частотами видеокарт зависимость абсолютно прямая и линейная: чем выше частота — тем выше производительность.

Устройство всегда имеет «номинальный» режим работы. Но в каждом выпущенном на рынок чипе есть определенный запас по частотам. Насколько велик этот запас в цифрах — зависит исключительно от конкретного экземпляра, однако заводские частоты практически никогда не являются пределом возможностей.

Ярчайшим примером здесь будет частотная модель последних поколений видеокарт Nvidia — а точнее, чипов из семейств Pascal и Turing. У этих чипов есть базовая частота, которую вы никогда не увидите, а есть частота динамического разгона, которая и указывается в характеристиках, то есть гарантируется производителем для любых условий. А сверх этого есть еще технология GPU Boost, разгоняющая чип еще сильнее, если остается запас по температурам.

Как результат — вполне реальная GTX 1060, выпущенная одним из вендоров, имеет базовую частоту в 1506 МГц, динамический разгон до 1721 МГц, а в реальности умудряется работать в диапазоне от 1870 до 1910 МГц.

А если производитель считает нормальным изменять частоту чипа в столь широких пределах — почему бы рядовому пользователю не заняться тем же самым, тем более если для этого есть необходимый инструментарий?

Какой результат можно получить от разгона видеокарты?

Все линейки видеокарт проектируются таким образом, что даже при помощи разгона практически невозможно добиться от младшей карты производительности старшей. Например, разница в количестве исполнительных блоков между GTX 1660 Ti и RTX 2060 такова, что даже предельный разгон младшей модели не выдаст производительность, которую старшая показывает на номинальных для нее частотах.

Есть, разумеется, и единичные исключения — например, Radeon RX 570 в разгоне может и догонять, и обходить номинальный Radeon RX 580, но такие случаи встречаются редко.

Любой разгон должен быть оправдан практически.

Для примера: если вы используете видеокарты начального класса, вроде Radeon R5 230 или GeForce GT 710, и в более-менее новых играх получаете всего 12 кадров в секунду — разгон, вероятно, позволит получить 14–15 кадров. Кардинально ничего не меняется, геймплей не становится комфортным.

Обратный пример: если в вашем компьютере установлены видеокарты флагманского уровня, вроде Radeon VII или GeForce RTX 2080 Ti, и при любых настройках графики вы получаете более 60 кадров в секунду даже в разрешениях 2K и 4K — лучше забыть о разгоне и наслаждаться непосредственно игровым процессом. Разницы между условными 110 и 120 кадрами в секунду вы также не ощутите.

Разгон действительно оправдан, если вам не хватает производительности, чтобы геймплей был комфортным на выбранных настройках графики, или чтобы попробовать более высокие настройки и/или разрешения экрана. Разница между 45 и 50 кадрами может казаться несущественной на бумаге, но в игре очень хорошо заметна.

Наглядный пример — реальная GeForce GTX 1660 Ti. И два разрешения экрана при одинаковых настройках:

Full HD, номинальный режим

Full HD, режим разгона

В Full HD от разгона получили 71 FPS вместо 67. Играть одинаково комфортно в обоих случаях, и разница в количестве кадров не ощутима.

2К, номинальный режим

2К, режим разгона

А в случае разрешения 2K мы говорим о разнице между 51 и 55 FPS. И хотя кажется, что здесь разница столь же незначительна — это отнюдь не так. Пределом комфортной игры считаются стабильные 60 кадров в секунду, и любое изменение, приближающее производительность к этому значению, ощутимо в реальной игре.

Если до 60 FPS не хватает совсем немного — разгон действительно поможет.

Теория работы и разгона видеокарты

Разгон видеокарты — это программное изменение её параметров при помощи специализированных утилит.

При разгоне важно понять пять параметров, которые и придется менять:

1) Частота графического процессора (Core Clock).

Тут, на первый взгляд, все просто: чем выше частота — тем выше производительность. Но с повышением частоты возрастает энергопотребление и нагрев чипа, и одновременно с этим – требования к напряжению на нём.

При разгоне современных видеокарт Nvidia и AMD по графическому чипу вы задаете им отнюдь не конкретное значение частоты, на котором они будут работать.

Для видеокарт Nvidia задается некий модификатор, добавляющий указанное значение к их базовой частоте. Частота под нагрузкой по-прежнему определяется технологией GPU Boost, и может изменяться на меньший шаг, нежели заданное значение.

Для видеокарт AMD семейств Vega и Navi задается уже конкретное значение частоты, но это значение является лишь верхней границей, за которую карта не перешагнет. Фактическая же частота чипа под нагрузкой будет зависеть от его температуры, напряжения и близости к лимиту энергопотребления.

2) Лимит энергопотребления (Power Limit)

Следующий, более важный пункт при разгоне графического процессора — доступный видеокарте лимит энергопотребления.

Как и любой электрический прибор, видеокарта призвана выполнять определенную задачу, затрачивая на это определенное количество энергии. Для современных карт это количество лимитировано, причем ограничение закладывается программным методом на уровне биос.

Для примера, если в BIOS видеокарты заложен лимит энергопотребления в 200 Вт, то в своем штатном состоянии больше 200 Вт она никак не съест, сколько бы противоположных комментариев про нее не было написано на форумах и в карточках товара магазинов. Если фактическое энергопотребление под нагрузкой превысит 200 Вт — карта начнет сбрасывать частоты, чтобы остаться в пределах программного лимита.

На практике это означает, что при разгоне лимит энергопотребления необходимо увеличивать. Как правило, программным методом его можно повысить на 50% от штатного значения, но бывают и исключения. Ещё не факт, что вам потребуется поднимать его до предела — всё будет зависеть от реального потребления карты в режиме разгона.

3) Напряжение на GPU и памяти (Core Voltage)

Уровень энергопотребления любого чипа зависит не только от его тактовой частоты, но и от напряжения, при котором этот чип работает. Чем оно выше — тем выше энергопотребление и сильнее нагрев, но выше и частотный потенциал разгона.

Возьмем, например, видеокарту Radeon RX 5700 в референсном дизайне. В номинале GPU этой видеокарты работает на частоте в 1750 МГц при напряжении в 1.02 В. На этой же частоте GPU стабильно работает и при 0.98 В, но вот разгон до 2100 МГц возможен уже только при поднятии напряжения до 1.19 В.

Штатный режим с понижением напряжения

Разгон с повышением напряжения

Далеко не все видеокарты допускают изменение напряжения программными средствами, что ограничивает предел разгона.

4) Частота памяти (Memory Clock)

С разгоном памяти все просто. Параметры частоты фиксированы, и если вы задаете условные 2000 МГц базовой частоты — то 2000 МГц вы и получаете под нагрузкой.

Нюанс в том, что чипы на видеокарте имеют понятие реальной и эффективной частоты. Эффективная указывается в рекламных материалах, а при разгоне меняется как раз реальная. Для памяти стандарта GDDR5 эффективная частота в 4 раза выше реальной, то есть вышеупомянутые реальные 2000 МГц дают эффективные 8000 МГц. Для памяти GDDR6 умножать надо уже не на 4, а на 8 — эффективные 14 000 МГц на деле оказываются 1750 МГц.

5) Скорость вентилятора (Fan Speed)

Видеокарту нужно разгонять собственным вентилятором, без шуток. Даже если вы правильно настроите напряжение и лимит энергопотребления, карта может не выйти на ожидаемые частоты, если упрется в потолок по температуре.

Повлиять на температуру видеокарты в разгоне можно лишь одним программным способом: задать повышенную скорость вращения вентилятора. Но, разумеется, уровень шума тоже увеличится.

Готовимся к разгону

Прежде всего — удостоверьтесь, что карте обеспечено достаточное охлаждение. Если разгон упрется в программные лимиты по температурам — карта будет снижать частоты, и никакого эффекта от разгона не будет. Проверьте температуру в штатном режиме: если она близка к 90 градусам или даже выше — забудьте о повышении частот и обеспечьте карте более комфортные условия.

Вмешиваться в конструкцию самой карты не придется, но раскрутить системный блок, вероятно, потребуется. Наладьте вентиляцию в корпусе, уложите провода так, чтобы они не мешали движению воздуха, переставьте системный блок подальше от батареи и ни в коем случае не устанавливайте его в глухие ниши «компьютерных» столов, которые не вентилируются.

Если видеокарта уже работает у вас длительное время — стоит хотя бы почистить её радиатор от скопившейся пыли, а лучше — еще заменить термопасту на графическом процессоре и термопрокладки на прочих элементах. Если собственного опыта недостаточно, любые профилактические работы можно сделать в авторизированном сервис-центре — так и гарантия сохранится.

Убедитесь в том, что мощности вашего блока питания достаточно. Стоит изучить данные о фактическом энергопотреблении вашей модели видеокарты в номинале и в разгоне, а также спецификации и обзоры на ваш блок питания. Если запаса по мощности мало, от разгона лучше отказаться.

Современное «железо» обладает завидным запасом прочности и крайне высокой степенью защиты от действий пользователя — вывести из строя ту же видеокарту при разгоне программными методами очень сложно. А вот блок питания, работающий на пределе и уходящий в защиту от перегрузки, это уже серьезная проблема.

Запасаемся инструментами для разгона

В общем случае, потребуются три отдельные утилиты: для изменения параметров видеокарты, мониторинга показателей, проверки результата. На деле же во многие «тюнеры» мониторинг и простые стресс-тесты зачастую уже встроены.

Софт для разгона

Выбор утилиты, с помощью которой вы будете управлять параметрами видеокарты, зависит исключительно от того, в какой программе вам лично удобнее работать: функционал у них примерно одинаков, различия заключаются в интерфейсе и, очень редко, — в перечне поддерживаемых видеокарт.

Для видеокарт AMD дополнительный софт не обязателен — все операции по разгону, изменению напряжений, лимитов энергопотребления, температур и даже скорости вентиляторов, можно выполнить напрямую из драйвера. Точнее, из надстройки Radeon Settings. При желании можно менять параметры, даже находясь в игре — для этого программу можно вызвать в оверлей нажатием комбинации клавиш.

Впрочем, если вы привыкли к другому интерфейсу — никто не запретит использовать сторонние программы. Как фирменные, вроде MSI Afterburner или Sapphire Trixx, так и написанные сторонними энтузиастами, вроде OverdriveNTool.

Для видеокарт Nvidia лучше использовать как раз сторонний софт — MSI Afterburner, Gigabyte AORUS Engine, Asus GPU Tweak или даже EVGA Precision X. Подобные утилиты есть практически у всех вендоров, причем не обязательно, чтобы производитель утилиты соответствовал производителю видеокарты.

Софт для мониторинга

В процессе разгона необходимо вести мониторинг параметров видеокарты, чтобы иметь представление обо всех изменениях, к которым приводят ваши действия. Разумеется, подобный функционал есть и в самих утилитах для разгона, но не всегда они могут прочесть показания всех нужных датчиков. Поэтому оптимальнее использовать специализированное ПО для мониторинга.

Например, GPU-Z или Hwinfo64. Последняя любопытна прежде всего тем, что постоянно обновляется, получая сведения о новых видеокартах и новых датчиках на них. Кроме того, агрегировав её с тем же MSI Afterburner, можно вывести все интересующие вас параметры в оверлей и контролировать частоты и температуры непосредственно из игры.

Софт для тестов

Разгон предполагает не только изменение и мониторинг параметров видеокарты, но и тестирование изменений на стабильность.

Разумеется, проверить стабильность карты можно и в играх — но для этого потребуется больше времени, да и условия могут быть не самыми подходящими. Например, в одной тестовой игре карта может быть абсолютно стабильной, а в другой — вылетать уже на этапе загрузки уровня.

Поэтому лучше использовать специализированные бенчмарки, прямая задача которых — создание экстремальной нагрузки на видеокарту.

В случае сравнительно старых видеокарт пальму первенства здесь удерживает «пушистый бублик» — FurMark до сих пор умудряется нагревать их так, как не может ни одна современная игра или тест видеокарты.

А вот если речь идет о современных графических чипах, оснащенных технологиями энергосбережения, FurMark не помощник — карты воспринимают его как экстремальную нагрузку, и не выходят на максимальные для них частоты.

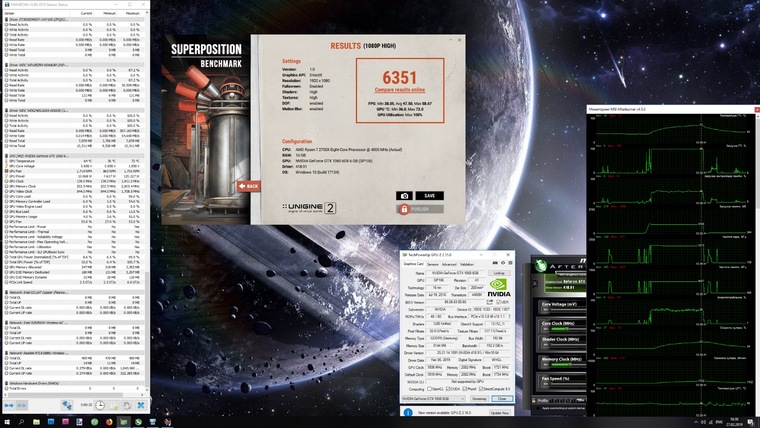

Для проверки современных видеокарт лучше подойдет бенчмарк от компании Unigine — тест Superposition. Он очень быстро грузится и создает достаточно серьезную нагрузку на видеокарту, чтобы выявить возможную нестабильность буквально в первые минуты, а не спустя несколько часов игры.

В приведенных выше картинках обоих бенчмарков тестировался современный Radeon RX 5700 XT. Что примечательно, частота GPU в «пушистом бублике» FurMark лишь чуть выше 1500 МГц, тогда как в Superposition — более 1900 МГц. Разумеется, данные теста Unigine Superposition более достоверные.

Переходим к практике

Рассмотрим изложенные выше тезисы на примере двух современных видеокарт от AMD и Nvidia, относящихся к одному ценовому сегменту и оснащенных сходными по конструкции системами охлаждения — GeForce RTX 2060 и Radeon RX 5700.

GeForce RTX 2060 не имеет заводского разгона, частотная модель полностью соответствует референсному экземпляру: 1365 МГц базовой частоты, динамический разгон до 1680 МГц, но на практике за счет технологии GPU Boost частота в течение теста составляет 1830 МГц.

Память работает на стандартной частоте в 1750 МГц (реальных).

Лимит энергопотребления GeForce RTX 2060 можно увеличить на 20% — и это вполне закономерно, поскольку у нее всего один разъем доппитания, и теоретический лимит энергопотребления составляет 225 Вт (75 по шине PCI-e + 150 Вт через разъем 8-pin). Изменение напряжения на GPU невозможно.

В тесте Superposition получаем результат в 10256 «условных попугаев».

Разгоняем GeForce RTX 2060: поднимаем лимит энергопотребления до максимума — это позволяет добавить 140 МГц к базовой частоте чипа и получить 1505 МГц базовых или 1820 МГц в динамическом разгоне. За счет технологии GPU Boost частота чипа возрастает до 1960–1990 МГц, но упирается уже в лимит температуры — 87 градусов на GPU. Дальнейший разгон возможен либо за счет принудительного повышения оборотов вентилятора, либо замены штатной СО на более эффективную.

К памяти можно добавить 218 реальных МГц — итоговая реальная частота составляет 1968 МГц. Дальнейшее повышение частоты невозможно, это предел потенциала самих чипов.

На разгоне без принудительного включения вентиляторов Superposition выдал 11140 «попугаев» и одно попугайское крылышко.

Radeon RX 5700 является референсным образцом, и его частотная модель полностью соответствует спецификациям AMD. Лимит частоты GPU — 1750 МГц, память работает на тех же 1750 реальных МГц.

Тест производительности выдает 10393 «попугая» в штатном режиме.

Разгоняем Radeon RX 5700: поднимаем напряжение со штатных 1,022 до 1,19 В. Лимит энергопотребления повышаем на 50%, верхний предел частоты GPU — до 2100 МГц, частоту памяти — до 1850 МГц (реальных). Все значения меняем через родной софт от AMD, кроме лимита энергопотребления — его «тюним» через MSI Afterburner. Частота памяти снова уперлась в предел самих чипов, а разгон GPU срезал температурный предел. Частота графического процессора RX 5700 в разгоне под нагрузкой колеблется в пределах 1980-2020 МГц.

Superposition за разгонные заслуги выдал 11927 «попугаев».

«Почему не работает дискретная видеокарта в играх?» – Яндекс.Кью

(дополнено)

спустя 5 лет после покупки Lenovo ideapad Z50-75 удалось решить похожую проблему.

Возможно кому поможет.

важное отступление.

Ноут работает на технологии Dual Graphics (Amd crossfireX). это значит, что вторая видеокарта запускается только в играх (про другие программы не знаю) поддерживающие DirectX 10 и выше, в остальное время не подаёт признаков жизни. Теоретически можно можно запустить только второй графический адаптер через BIOS, хотя это танцы с бубном, т.к на моём ноуте различия между мощностями видеокарт не значительные.

Это всё к тому, что этот ответ будет полезен для обладателей похожей технологии.

Как включить AMD Crossfire.

ПКМ по рабочему столу→»настройки Radeon» (если этой функции нет-качаем видеодрайвер только с сайта производителя). в открывшемся окне снизу нажимаем «настройки»→»дополнительные настройки»→»параметры переключаемой графики». Кликаем на «добавить приложение…». Тут выбираем ярлык запускаемой нами игры.

ВНИМАНИЕ: если тип файла «Ярлык интернета», то при её выборе нам выдаст ошибку. нужен именно .exe игры (зайдите в папку с игрой, в дальнейшем запускайте игру от этого ярлыка).

в «настройках графики» ставим «высокая производительность».

Вернёмся к «настройке radeon»

сверху откройте вкладку «игры», далее нажмите»Глобальные настройки»→включаем AMD Crossfire→возвращаемся на предыдущую вкладку, и если после предыдущих действий в каталоге не отобразилась ваша игра, то: жмём «добавить» и открываем .exe файл вашей игры.

заходим в настройки выбранной нами игры → настраиваем «Режим AMD Crossfire» (пробуем разные настройки в играх). проделываем с настройками всех графических профилей. Профиль OverDrive пока не трогаем (особенно если вы не разбираетесь), т.к. оптимальные настройки видюхи-стандартные. и изменение параметров может отрицательно сказаться на производительности.

Проверим настройки электропитания.

ПКМ по иконке батареи→»электропитание»→ставим «высокая производительность». Рядом нажимаем «настройка схемы электропитания»→»изменить дополнительные параметры питания»→выставляем настройки на «высокую производительность», в приоритете «параметры питания видеоплаты ATI», «переключаемые графические адаптеры», «PCI Express».

ВНИМАНИЕ: Если запускаемая нами игра поддерживает DirectX 9 и ниже, то попробуйте следущие варианты.

Если игра лицензия, и находится в библиотеке Steam, то в параметрах запуска нужно выставить команду -dxlevel (число 100, 101 110 или 111 в зависимости от желаемой версии DirectX). Если игра не находится в библиотеке Steam, или не сработал предыдущий вариант, то запустите dxcpl (если этой проги нет-качайте)→»···»→путь к .exe игры или ярлыку→»add»→»ok»→параметр «Feature level limit»выставляем в зависимости от желаемой версии DirectX. можно экспериментировать с настройками: Debug Layer и Force WARP.

Если кому помог, дайте знать.

Как узнать, какая видеокарта стоит на компьютере | Видеокарты | Блог

Производители игр и программного обеспечения не устают нас радовать потрясающими графическими возможностями своих творений, раз за разом выдвигая новые требования к железу. Если сообщение «Обновите драйвера» появилось на экране или просто захотелось купить очередной шедевр игровой индустрии, то полезно узнать, что за видеокарта установлена в вашем ноутбуке или десктопном компьютере.

Как определить видеокарту в Windows

Обладатель операционной системы от Microsoft, как былинный богатырь, может выбрать один из трех путей.

Быстрый путь

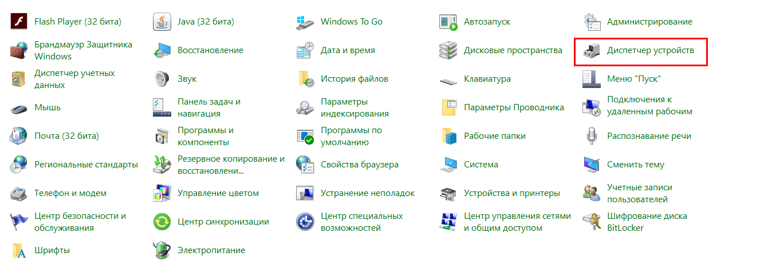

Для определения параметров установленной видеокарты в семействе Windows необходимо вызвать «Диспетчер устройств». Легче всего это сделать, нажав сочетание клавиш «Win+R», в появившемся окне написать «devmgmt.msc».

«Win» — кнопка на клавиатуре со стилизованным логотипом компании.

Второй вариант — через «Пуск» добраться до панели управления и там уже выбрать нужный пункт меню.

Третий — правой клавишей открыть меню ярлыка «Мой компьютер», кликнуть по вкладке «Свойства», перейти в подкатегорию «Оборудование».

В диспетчере устройств нас интересует раздел «Видеоадаптеры» — второй по счету. Нажимаем на него, видим название и серию своей видеокарты. Вызываем контекстное меню правой клавишей мышки, выбираем в конце списка «Свойства».

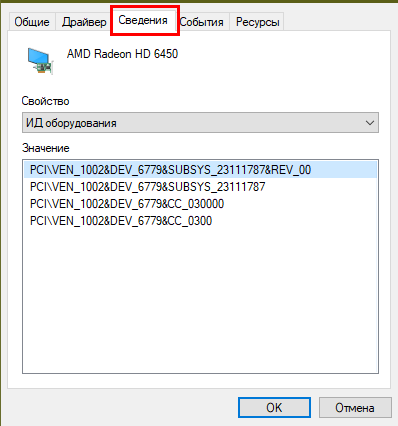

В новом окне переходим к пункту «Сведения». Для получения интересующей нас информации выбираем соответствующую строку из выпадающего списка: хэш идентификаторов, шина данных, характеристики класса, дата последнего обновления драйверов, подключенные дисплеи.

Профессиональный путь

Стандартный набор инструментов не особо удобен, поэтому профессионалы предпочитают работать со сторонним софтом, в котором подробные сведения о видеокарте представлены в удобном формате. Скачать программы можно на официальных страницах разработчиков.

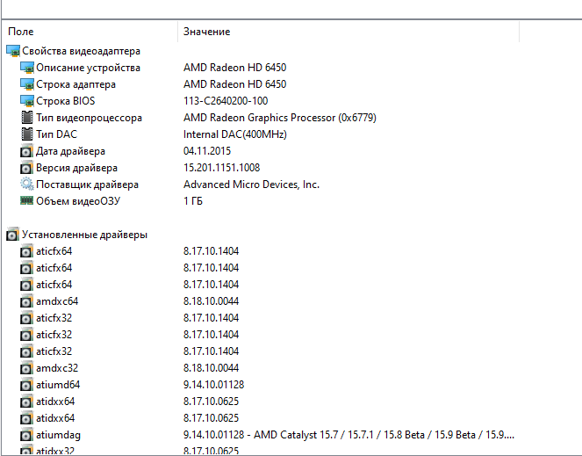

AIDA64 — программа собирает все сведения о ноутбуке или стационарном ПК, в том числе информацию о видеокарте. Все данные находятся в разделе «Отображение». Здесь можно узнать, какая видеокарта установлена — дискретная или интегрированная, модель, партнабмер, объем ОЗУ, тип шины, пропускную способность, частоту, количество шейдеров, кэш, уровень текущей нагрузки, температуру, поддерживаемую версию в DirectX.

Софт «DirectX» сам по себе может стать источником полезных сведений. Жмем Win+R, вводим «dxdiag.exe», переходим во вкладку «Экран».

Здесь указывается номер графического чипа, версия драйверов, расширение экрана и другая информация.

Программа GPU-Z сразу показывает все данные в одном окошке + отдельно частоту вращения вентиляторов, температуру, размер выделенной памяти — быстро и удобно.

Исследовательский путь

Если видеокарта отображается в качестве безымянного адаптера или неизвестного устройства, потребуется установить драйвера. Переходим во вкладку «Сведения», выбираем в списке «ИД оборудования», копируем циферки, VEN — производитель, DEV — само устройство, вводим данные в поле поиска на сайте http://devid.info/ru.

Если видеокарта не подает признаков жизни, есть шанс почувствовать себя Шерлоком, вооружившись увеличительным стеклом. На плате должен быть наклеен стикер с серийным номером.

Вводим его в поисковую строку, смотрим результат.

Как определить видеокарту в Mac OS

Во многих MacBook установлены встроенные графические процессоры, но попадаются и модели с дискретной, то есть съемной видеокартой. Существует еще и гибридный вариант — слабый встроенный графический чип и отключаемая мощная видеокарта для игр.

Чтобы определить, что именно установили «под капот» производители, жмем на иконку «огрызка» — меню Apple. Выбираем пункт «About This Mac». Переходим во вкладку «Подробнее», открываем список «Аппаратные средства», ищем строку «Графика/Мониторы». Если полученных сведений недостаточно, ищем в сети данные по названию модели.

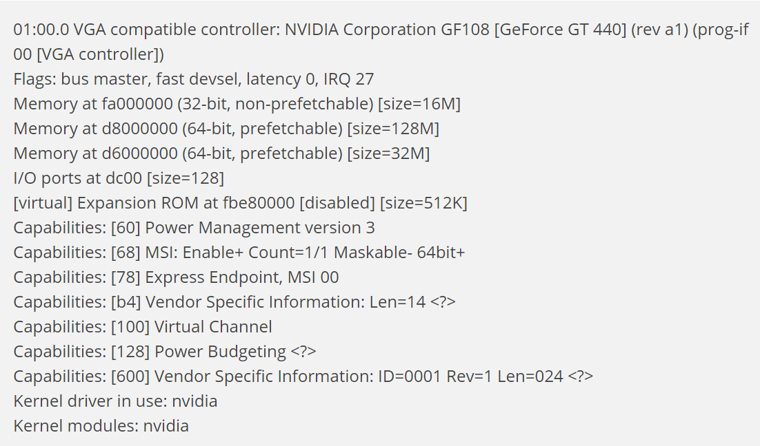

Как определить видеокарту в Windows Linux

После выхода на «пингвиньей» платформе нескольких прожорливых игр (Mad Max, Divinity, Dying Light) появился актуальный вопрос: «Какая у меня установлена видеокарта?».

Операционная система Linux готова дать ответ с помощью двух утилит и одной программы.

Утилита lscpi

Консольная утилита позволяет увидеть все PCI-устройства. Перед поиском нужных данных не лишним будет обновить список всех доступных устройств с помощью команды:

$ sudo update-pciids

После чего для получения сведений о производителе и типе видеоадаптера набираем:

$ lspci | grep -E «VGA|3D»

Получив сведения о PCI-порте, его следует указать вместе с командой «sudo — v — s». Выглядеть это будет так:

$ sudo lspci -v -s 00:01.0

Где «00:01.0» — номер порта.

Так мы сможем определить разрядность, количество виртуальной и физической памяти, версию драйверов.

Утилита lshw

С помощью этой утилиты легко получить сведения, используя команду:

$ sudo lshw -c video

Данные скудные, но больше нам «пингвинус» не скажет. Узнав серию видеокарты, отправляемся на поиски подробной информации во всемирную паутину.

Софтина Hardinfo

Обладателям CentOS следует воспользоваться пакетным менеджером Yum, остальные набирают команду:

$ sudo apt-get install hardinfo

Снова нажимаем «Выполнить», пишем:

$ hardinfo

В открывшемся окошке, очень похожем на AIDA64, выбираем «Devices», затем подкатегорию «PCI Devices».

При поиске данных обращайте внимание на модель — по ней можно найти максимально подробные сведения на сайте производителя или детальный обзор с тестом современных игр и программ.

Как работают видеокарты?

С тех пор, как 3dfx представила оригинальный ускоритель Voodoo, ни один элемент оборудования на ПК не оказал такого сильного влияния на возможность игры на вашей машине, как скромная видеокарта.В то время как другие компоненты имеют большое значение, топовый ПК с 32 ГБ ОЗУ, ЦП за 4000 долларов и хранилищем на базе PCIe задохнется и умрет, если его попросят запустить современные игры AAA на карте десятилетней давности с современными разрешениями и уровнями детализации. . Графические карты, также известные как графические процессоры (графические процессоры), критически важны для производительности игр, и мы подробно их рассмотрим. Но мы не часто вникаем в то, что заставляет GPU работать и как работают карты.

По необходимости, это будет общий обзор функциональности графических процессоров и информация, общая для интегрированных графических процессоров AMD, Nvidia и Intel, а также любых дискретных карт, которые Intel может построить в будущем на основе архитектуры Xe.Он также должен быть общим для мобильных графических процессоров, созданных Apple, Imagination Technologies, Qualcomm, ARM и другими поставщиками.

Почему мы не запускаем рендеринг с помощью ЦП?

Первый момент, который я хочу затронуть, — это то, почему мы вообще не используем процессоры для рендеринга рабочих нагрузок в играх. Честный ответ на этот вопрос заключается в том, что вы, , можете запускать рабочие нагрузки рендеринга непосредственно на CPU. Ранние 3D-игры, предшествовавшие повсеместному распространению графических карт, такие как Ultima Underworld, полностью работали на центральном процессоре.UU является полезным эталонным вариантом по нескольким причинам — у него был более продвинутый движок рендеринга, чем в таких играх, как Doom, с полной поддержкой просмотра вверх и вниз, а также с такими расширенными функциями, как наложение текстур. Но за такую поддержку пришлось заплатить высокую цену — многим людям не хватало ПК, на котором можно было запускать игру.

Ultima Underworld. Изображение GOG

На заре создания 3D-игр многие игры, такие как Half-Life и Quake II, имели программный рендерер, позволяющий игрокам без 3D-ускорителей воспроизводить игру.Но причина, по которой мы отказались от этой опции в современных играх, проста: процессоры спроектированы как микропроцессоры общего назначения, что является еще одним способом сказать, что им не хватает специализированного оборудования и возможностей, которые предлагают графические процессоры. Современный ЦП мог легко обрабатывать названия, которые имели тенденцию к заиканию при работе в программном обеспечении 18 лет назад, но ни один ЦП на Земле не может легко справиться с современной игрой AAA с сегодняшнего дня, если запустить в этом режиме. По крайней мере, без кардинальных изменений сцены, разрешения и различных визуальных эффектов.

В качестве забавного примера: Threadripper 3990X может запускать Crysis в программном режиме, хотя и не так хорошо, как .

Что такое графический процессор?